智源視覺團隊近期的工作:3D視覺大模型Uni3D在ICLR 2024的評審中獲得了688分,被選為Spotlight Presentation。在本文中,作者第一次將3D基礎(chǔ)模型成功scale up到了十億(1B)級別參數(shù)量,并使用一個模型在諸多3D下游應(yīng)用中取得SOTA結(jié)果。代碼和各個scale的模型(從6M-1B)均已開源:

作者主要探索了3D視覺中scale up模型參數(shù)量和統(tǒng)一模型架構(gòu)的可能性。在NLP / 2D vision領(lǐng)域,scale up大模型(GPT-4,SAM,EVA等)已經(jīng)取得了很impressive的結(jié)果,但是在3D視覺中模型的scale up始終沒有成功。Uni3D旨在將NLP/2D中scale up的成功復(fù)現(xiàn)到3D表征模型上。

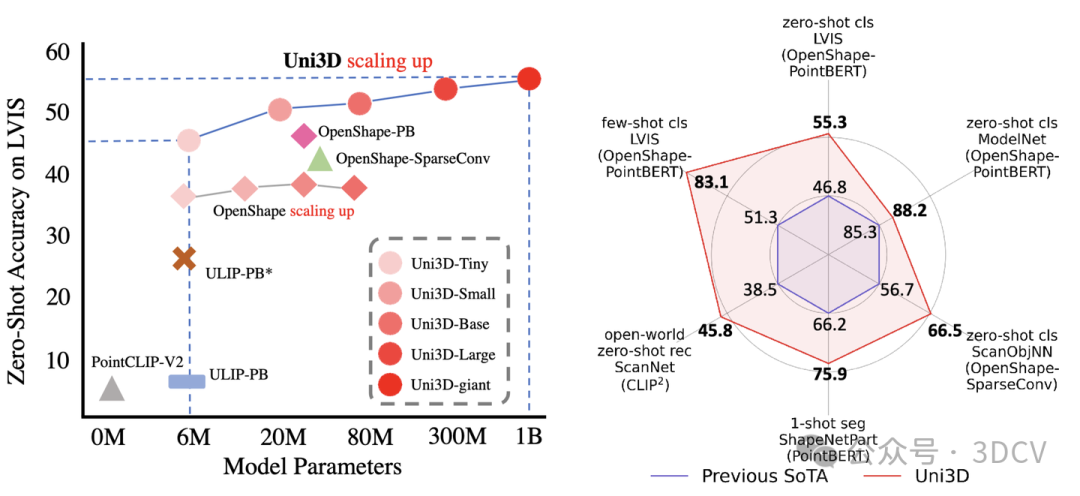

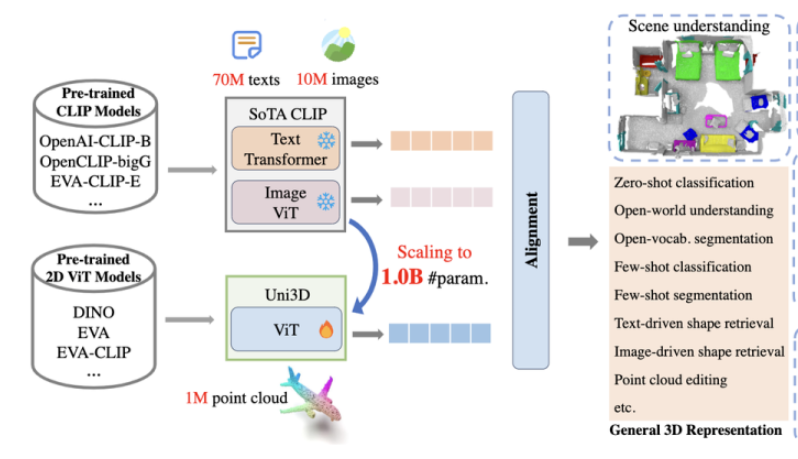

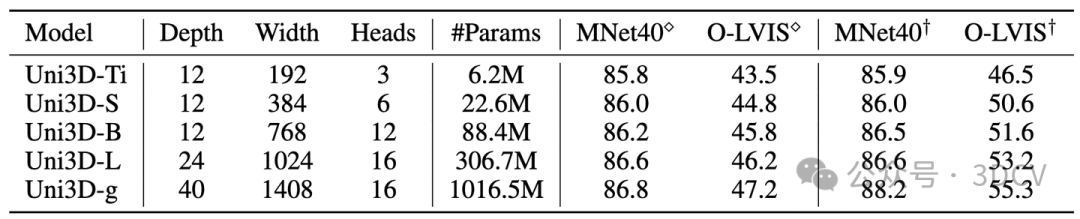

在這項工作中,作者提出了一個3D基礎(chǔ)大模型Uni3D,直接將3D backbone統(tǒng)一為ViT(Vision Transformer),以此利用豐富和強大的2D預(yù)訓(xùn)練大模型作為初始化。Uni3D使用CLIP模型中的文本/圖像表征作為訓(xùn)練目標(biāo),通過學(xué)習(xí)三個模態(tài)的表征對齊(點云-圖像-文本)實現(xiàn)3D點云對圖像和文本的感知。同時,通過使用ViT中成功的scale up策略,我們將Uni3D逐步 scale up,訓(xùn)練了從Tiny到giant的5個不同scale的Uni3D模型,成功地將Uni3D擴展到10億級別參數(shù)。

下游應(yīng)用:

Uni3D在多個3D任務(wù)上達到SoTA,如:zero-shot classification, few-shot classification,open-world understanding, open-world part segmentation.

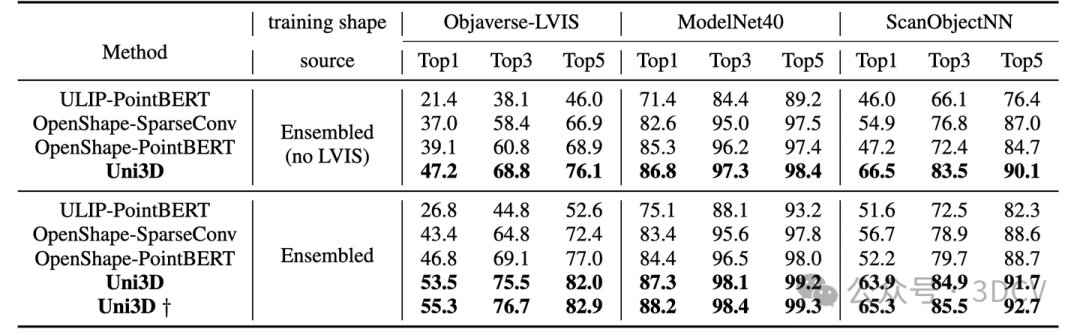

零樣本/少樣本分類

Uni3D在ModelNet上實現(xiàn)了88.2%的零樣本分類準(zhǔn)確率,甚至接近了有監(jiān)督學(xué)習(xí)方法的結(jié)果(如PointNet 89.2 %);

在最困難的Objaverse-LVIS基準(zhǔn)下,Uni3D取得了55.3%的零樣本分類準(zhǔn)確率,大幅刷新了該榜單。

而在Objaverse-LVIS基準(zhǔn)的少樣本分類測試中,Uni3D實現(xiàn)了83.1%的準(zhǔn)確率(16樣本下),明顯超過了以往的最先進基準(zhǔn)OpenShape 32%。

開放世界的理解能力

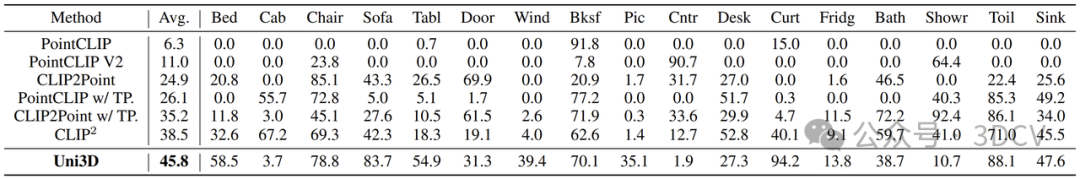

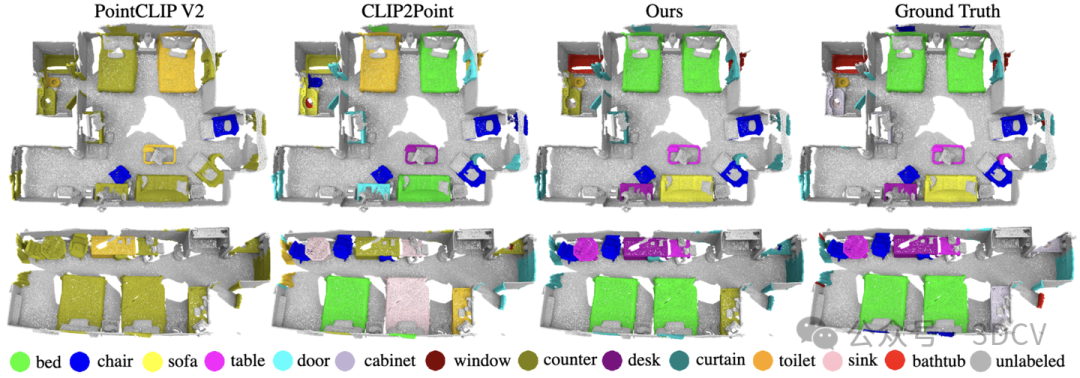

研究團隊采用與CLIP2相同的設(shè)置在ScanNet測試集下探究Uni3D在現(xiàn)實場景下的零樣本識別性能。與之前最先進的SOTA方法PointCLIP、PointCLIP V2 、CLIP2Point 和CLIP2 相比,Uni3D表現(xiàn)最佳。

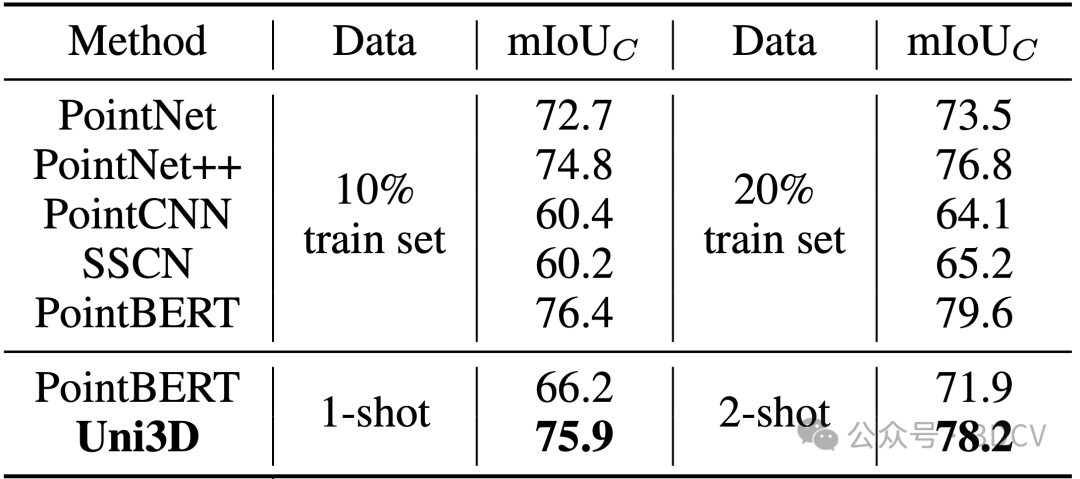

Uni3D在少樣本點云部件分割任務(wù)上也展示出了卓越的性能。下表結(jié)果顯示,在各種實驗條件下,Uni3D的性能都明顯優(yōu)于Point-BERT等基線方法。即便只使用每類一個樣本訓(xùn)練,Uni3D也達到了使用10%的訓(xùn)練數(shù)據(jù)的先前基線方法(如PointNet++,Point-BERT)的水平,在訓(xùn)練集的規(guī)模相對減少兩個數(shù)量級的情況下,仍能顯示出Uni3D更強的細粒度3D結(jié)構(gòu)理解能力。

由于學(xué)到了強大的多模態(tài)表征能力,Uni3D還能夠做一些有意思的應(yīng)用,如point cloud painting(點云繪畫),text/image-based 3D shape retrieval(基于圖像/文本的3D模型檢索),point cloud captioning(點云描述):

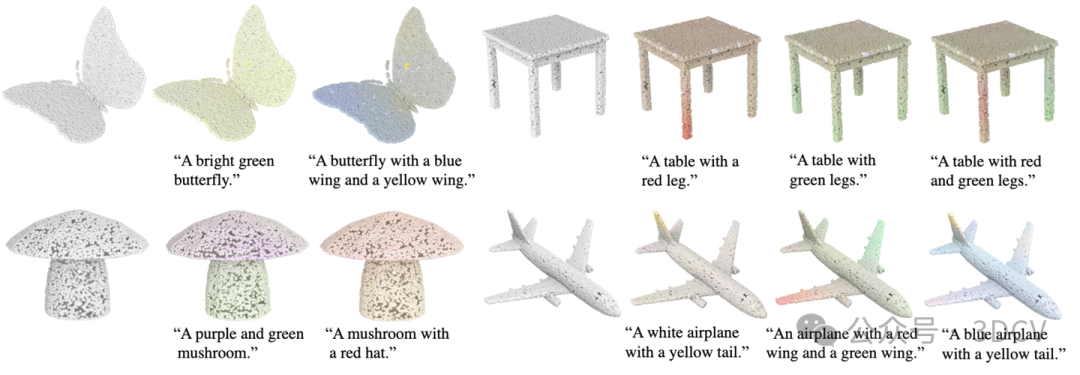

點云繪畫:體現(xiàn)了在3D AIGC上的潛在能力

給定一個文本,Uni3D通過優(yōu)化點云的顏色來提高點云和文本在特征空間的相似度,基于此實現(xiàn)文本操控的點云內(nèi)容創(chuàng)作和點云繪畫。

文本驅(qū)動/圖像驅(qū)動的三維形狀檢索:體現(xiàn)在構(gòu)建多模態(tài)檢索庫上的潛在能力

Uni3D通過學(xué)習(xí)到的統(tǒng)一的三維多模態(tài)表示,具有感知多個2D/語言信號的能力,可以通過圖像或文本輸入從大型3D數(shù)據(jù)集中檢索三維形狀。這是通過計算查詢圖像/文本提示的embedding與3D形狀的embedding入之間的余弦相似度來實現(xiàn)了對查詢的最相似3D形狀的獲取。

Uni3D 還可根據(jù)輸入文本來檢索 3D 形狀

將之前已經(jīng)成熟的“文搜圖/圖搜圖”擴展到“文搜3D/圖搜3D”,這使得檢索互聯(lián)網(wǎng)上大規(guī)模未標(biāo)定的繁雜三維模型成為可能,為相關(guān)三維領(lǐng)域從業(yè)者、創(chuàng)作者搜集素材提供實用工具。

Uni3D 還可給定點云生成對應(yīng)的文本描述

Uni3D擴展為Text-to-3D generation tasks的評測指標(biāo)

在text-to-3D研究領(lǐng)域,目前量化度量仍然是一個較難的問題。目前的量化指標(biāo)都是將生成的3D模型渲染為2D圖片,利用2D指標(biāo)衡量生成質(zhì)量。然而由于渲染角度互相獨立以及3D模型自遮擋等問題,2D評價指標(biāo)難以完全真實反映出3D生成模型的真實能力。如下圖,生成的3D模型有明顯的3D不一致性問題,但是單獨看其中大部分的視角渲染圖片都是正常的物體,導(dǎo)致2D評價指標(biāo)往往難以反映生成3D模型的不一致問題。

作者團隊近期推出的Text-to-3D generation 工作GeoDream提出利用目前最大最強的3D基礎(chǔ)模型Uni3D,直接對3D模型進行評估,避免渲染帶來的視角問題。相應(yīng)的評價指標(biāo)代碼也開源到GeoDream的代碼庫中 (https://github.com/baaivision/GeoDream) 。

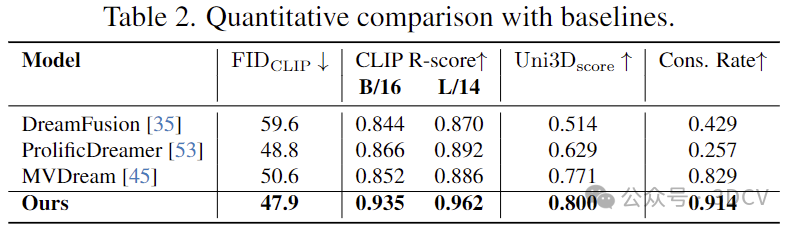

量化比較:在生成質(zhì)量和語義保持性的量化測試上,GeoDream相比于之前方法取得顯著提升。在基于渲染2D圖片的量化指標(biāo)(FID,CLIP-Score)和直接在3D空間度量生成的3D資產(chǎn)量化指標(biāo)(Uni3D-Score)上均有提升,說明GeoDream渲染的圖片和3D結(jié)構(gòu)均有優(yōu)勢。

審核編輯:黃飛

-

3D視覺

+關(guān)注

關(guān)注

4文章

446瀏覽量

28001 -

大模型

+關(guān)注

關(guān)注

2文章

2973瀏覽量

3730

原文標(biāo)題:ICLR‘24 Spotlight 首個十億級別3D通用大模型

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

探索ICLR‘24 Spotlight中的首個十億級別3D通用大模型

探索ICLR‘24 Spotlight中的首個十億級別3D通用大模型

評論