Stability AI 宣布推出迄今為止最強大的小語言模型之一 Stable LM 2 1.6B。以英語、西班牙語、德語、意大利語、法語、葡萄牙語和荷蘭語的多語言數據為基礎進行了訓練,體積小、速度快,降低了硬件門檻;并提供了完全透明的訓練細節,旨在讓開發人員和模型創建者能夠快速進行實驗和迭代。

Stable LM 是一種文本內容生成 LLM,Stability AI 于 2023 年 4 月首次推出了 30 億和 70 億參數模型。新的 StableLM 模型實際上是 Stability AI 在 2024 年發布的第二個模型,此前該公司在早些時候還發布了一個 Stable Code 3B。

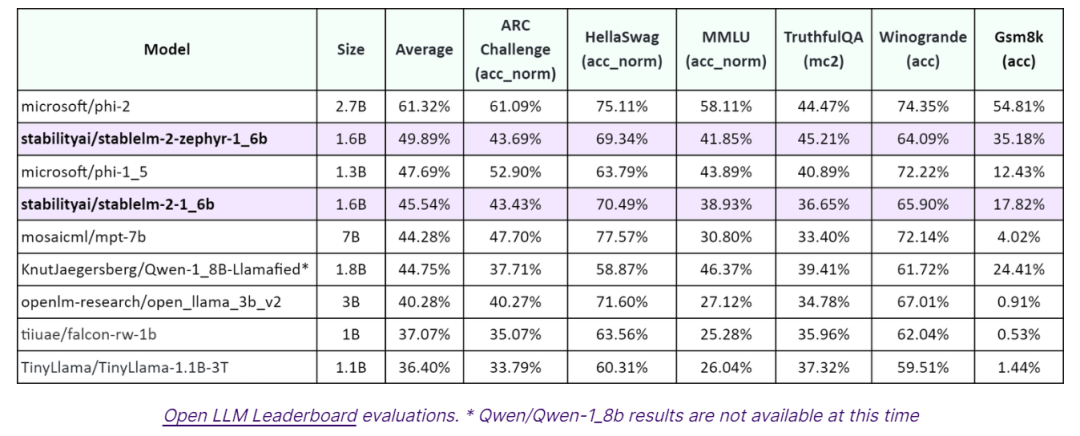

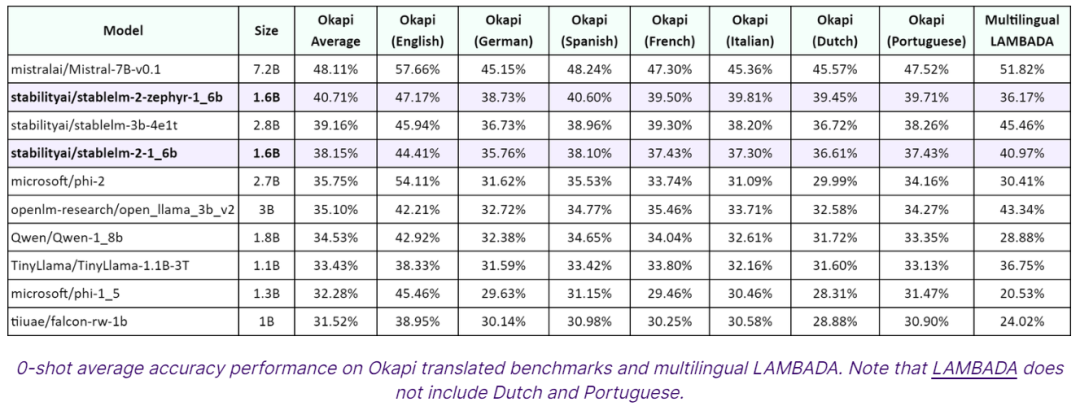

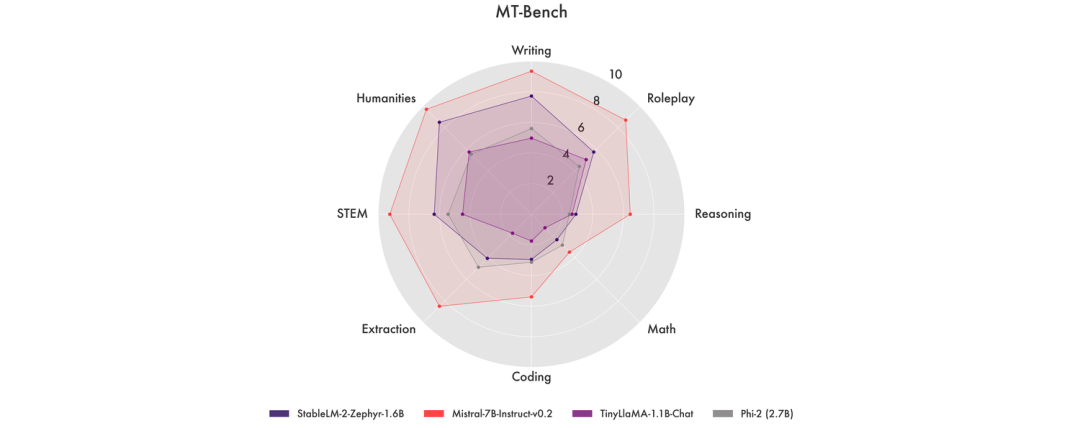

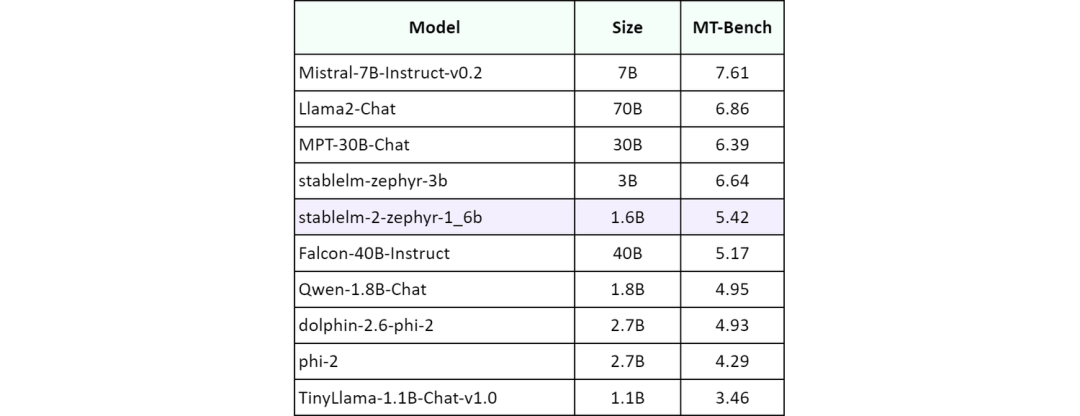

Stability AI 聲稱,Stable LM 2 1.6B 在大多數基準測試中均優于其他參數低于 20 億個的小語言模型,如微軟的 Phi-1.5 (1.3B) 和 Phi-2 (2.7B)、TinyLlama 1.1B 或 Falcon 1B。

不過他們也警告稱,由于小型、低容量語言模型的特性,Stable LM 2 1.6B 可能會出現高幻覺率、潛在的有毒語言等類似的常見問題。“我們要求社區在構建應用程序時牢記這一點,并采取適當措施確保以負責任的方式進行開發。”

Stable LM 2 1.6B 目前可在商業和非商業領域使用,只要擁有 Stability AI 會員資格,即可在 Hugging Face 上測試該模型。

審核編輯:劉清

-

語言模型

+關注

關注

0文章

558瀏覽量

10667 -

LLM

+關注

關注

1文章

319瀏覽量

678

原文標題:Stability AI推出更小、更高效的1.6B語言模型

文章出處:【微信號:OSC開源社區,微信公眾號:OSC開源社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

谷歌Gemini 2.5模型系列更新

樹莓派發布了迄今為止最優秀的電源解決方案!

大語言模型在軍事應用中的安全性考量

AI大語言模型開發步驟

大語言模型開發語言是什么

IBM發布Granite 3.0 AI模型家族

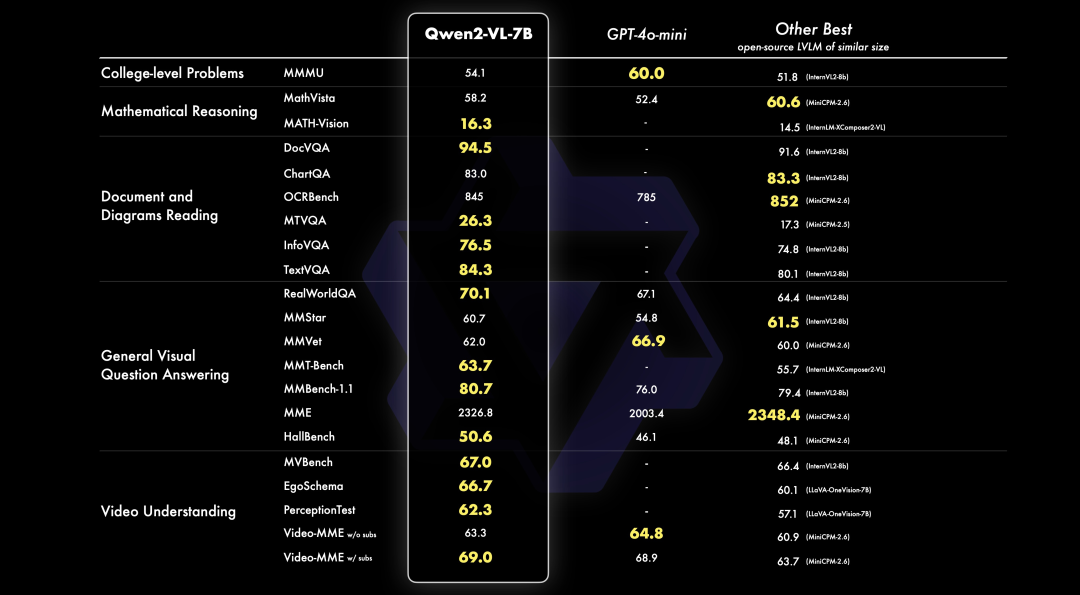

PerfXCloud重磅升級 阿里開源最強視覺語言模型Qwen2-VL-7B強勢上線!

Stability AI推出迄今為止更小、更高效的1.6B語言模型

Stability AI推出迄今為止更小、更高效的1.6B語言模型

評論