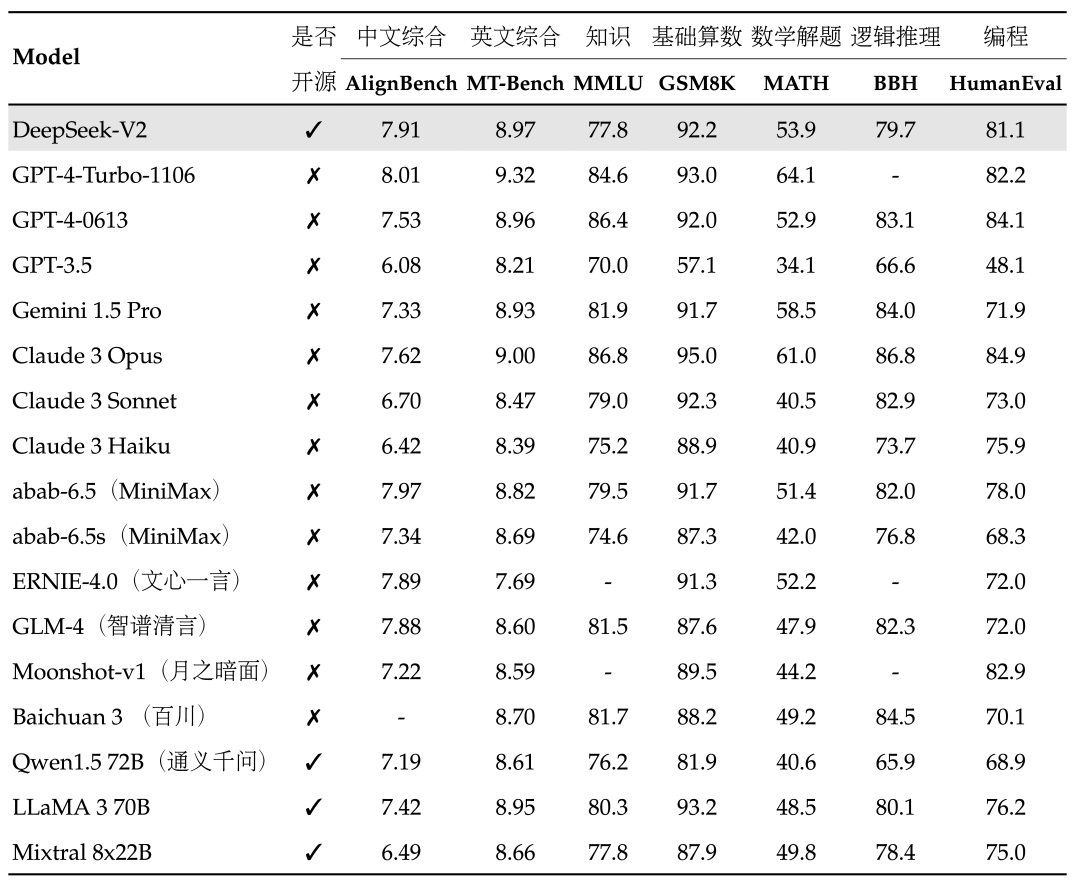

我們都知道,OpenAI 團(tuán)隊(duì)一直對(duì) GPT-4 的參數(shù)量和訓(xùn)練細(xì)節(jié)守口如瓶。Mistral 8x7B 的放出,無(wú)疑給廣大開(kāi)發(fā)者提供了一種「非常接近 GPT-4」的開(kāi)源選項(xiàng)。

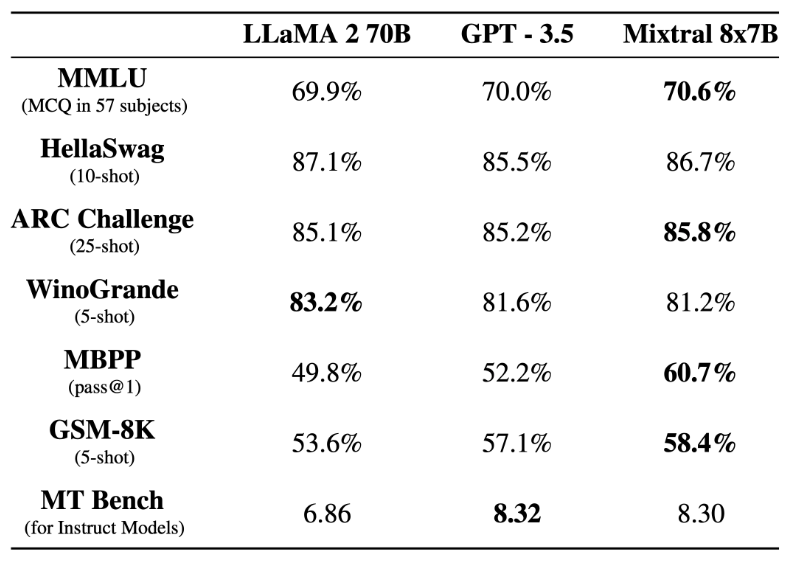

在基準(zhǔn)測(cè)試中,Mistral 8x7B 的表現(xiàn)優(yōu)于 Llama 2 70B,在大多數(shù)標(biāo)準(zhǔn)基準(zhǔn)測(cè)試上與 GPT-3.5 不相上下,甚至略勝一籌。

▲圖源 https://mistral.ai/news/mixtral-of-experts/

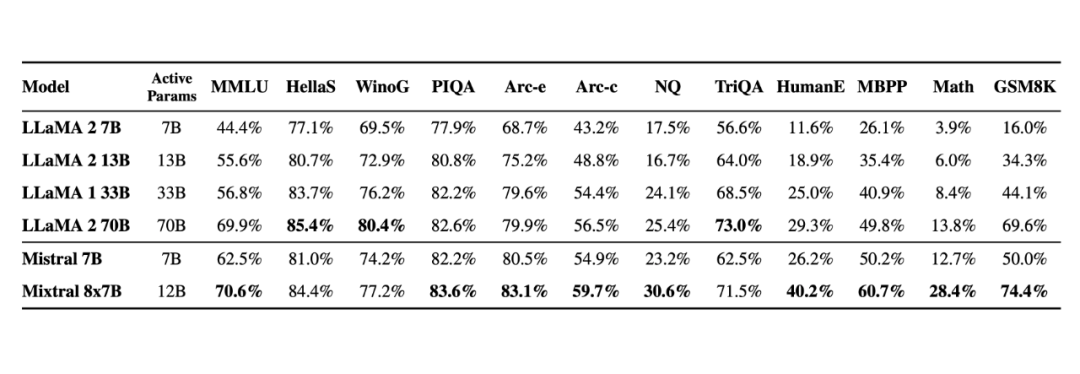

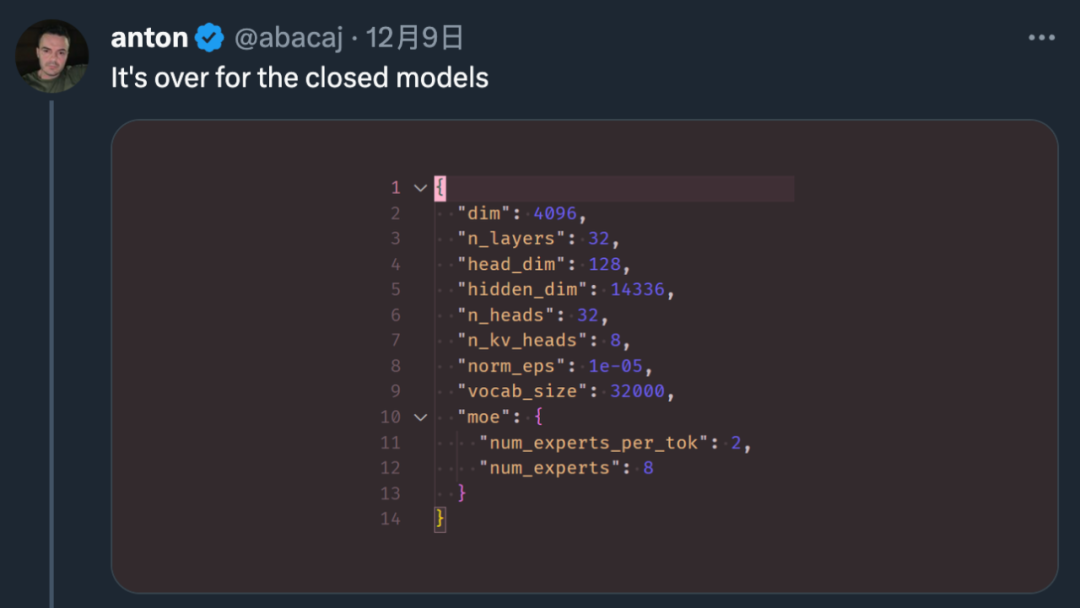

▲圖源 https://mistral.ai/news/mixtral-of-experts/隨著這項(xiàng)研究的出現(xiàn),很多人表示:「閉源大模型已經(jīng)走到了結(jié)局。」

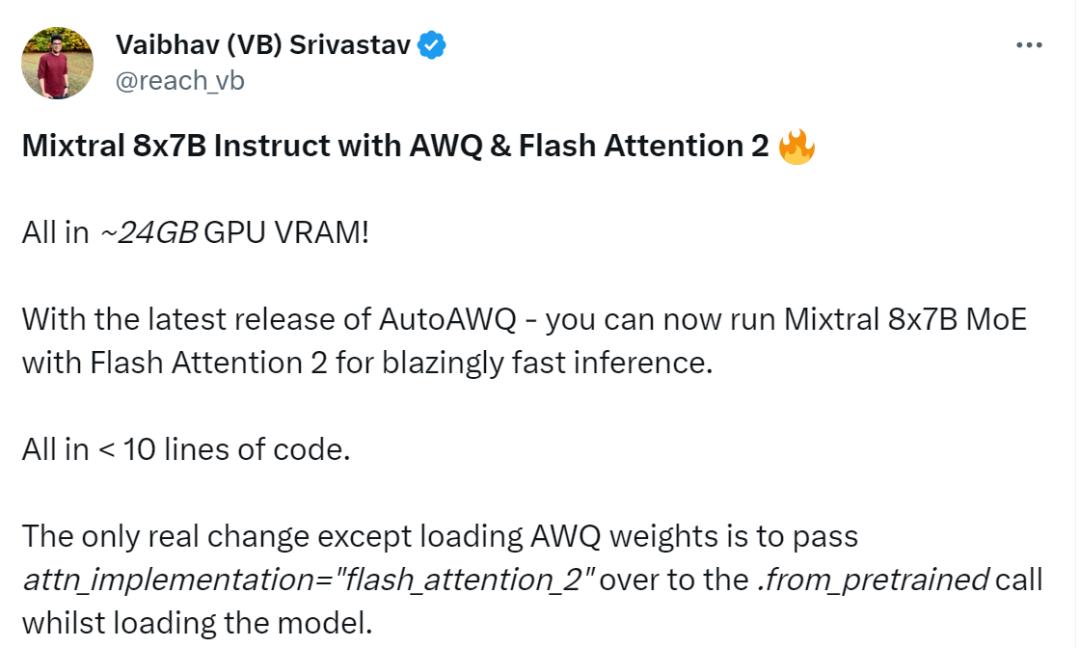

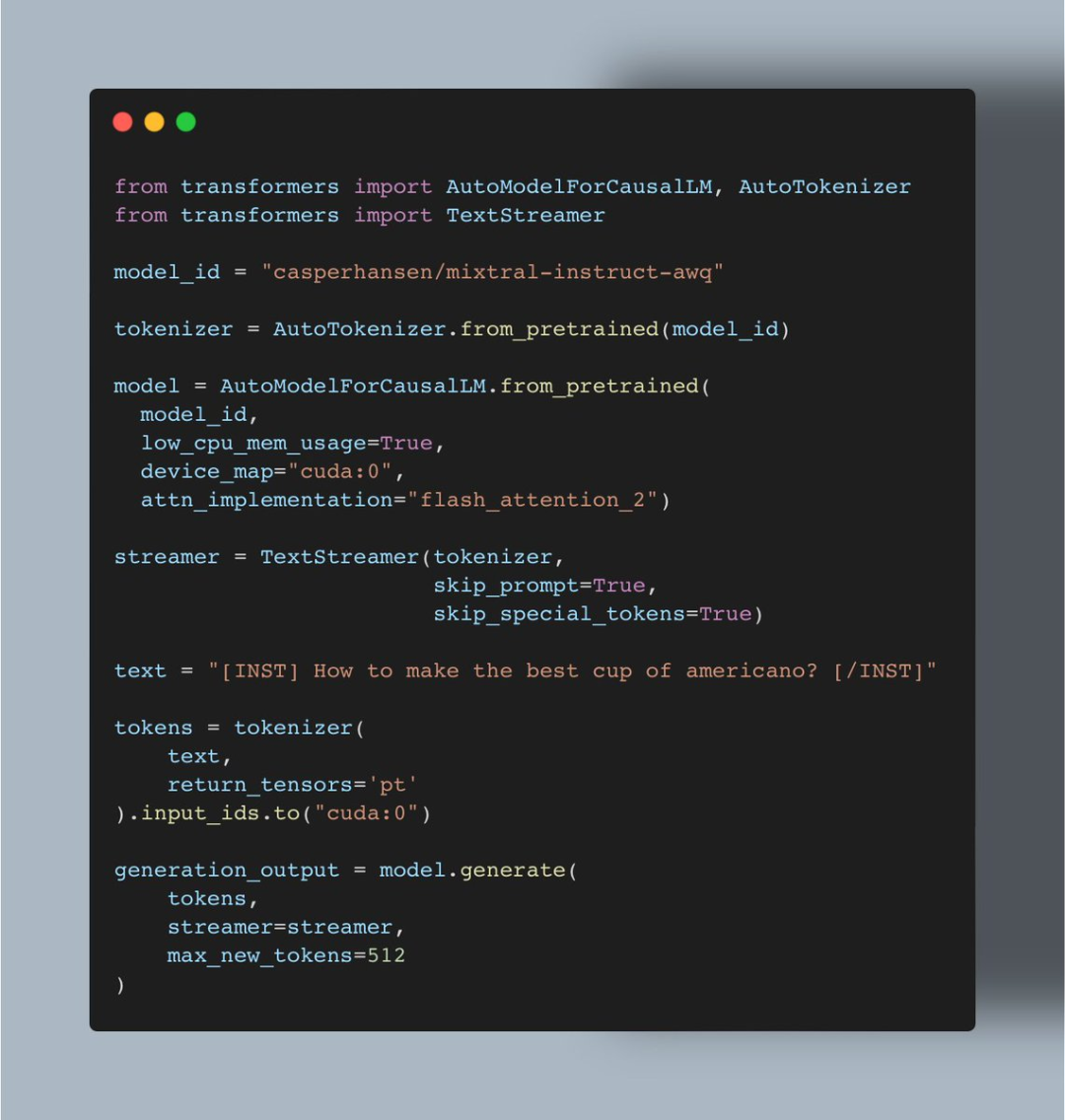

短短幾周的時(shí)間,機(jī)器學(xué)習(xí)愛(ài)好者 Vaibhav (VB) Srivastav 表示:隨著 AutoAWQ(支持 Mixtral、LLaVa 等模型的量化)最新版本的發(fā)布,現(xiàn)在用戶(hù)可以將 Mixtral 8x7B Instruct 與 Flash Attention 2 結(jié)合使用,達(dá)到快速推理的目的,實(shí)現(xiàn)這一功能大約只需 24GB GPU VRAM、不到十行代碼。

▲圖源 https://twitter.com/reach_vb/status/1741175347821883502

▲圖源 https://twitter.com/reach_vb/status/1741175347821883502

AutoAWQ地址:

https://github.com/casper-hansen/AutoAWQ 操作過(guò)程是這樣的: 首先是安裝 AutoAWQ 以及 transformers:

pipinstallautoawqgit+https://github.com/huggingface/transformers.git

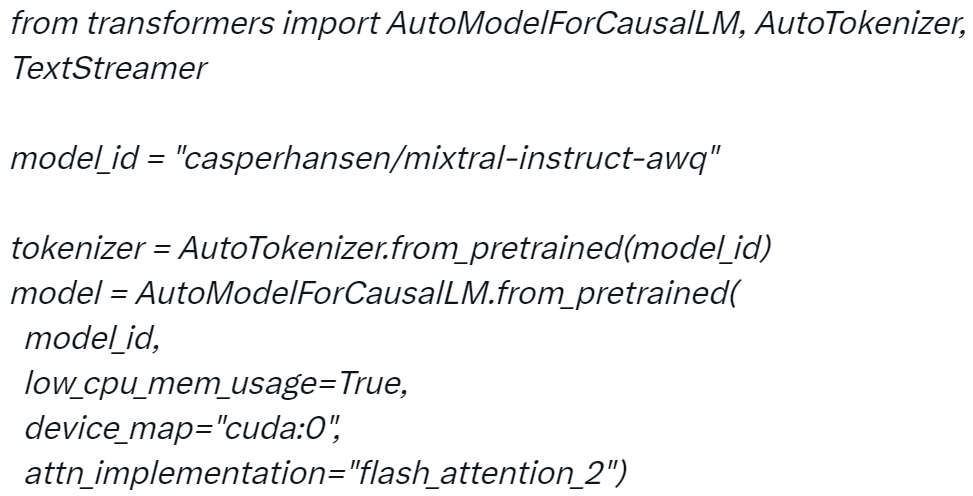

第二步是初始化 tokenizer 和模型:

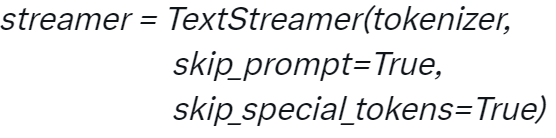

?第三步是初始化 TextStreamer:

?第三步是初始化 TextStreamer:

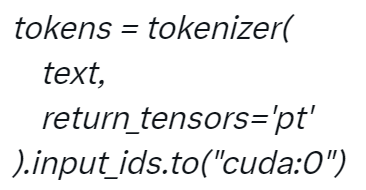

?第四步對(duì)輸入進(jìn)行 Token 化:

?第四步對(duì)輸入進(jìn)行 Token 化:

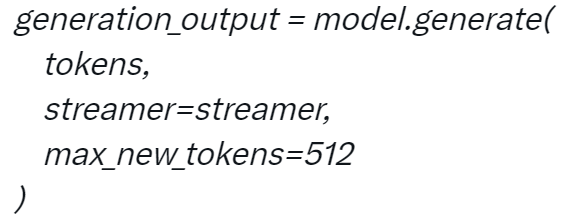

?第五步生成:

?第五步生成:

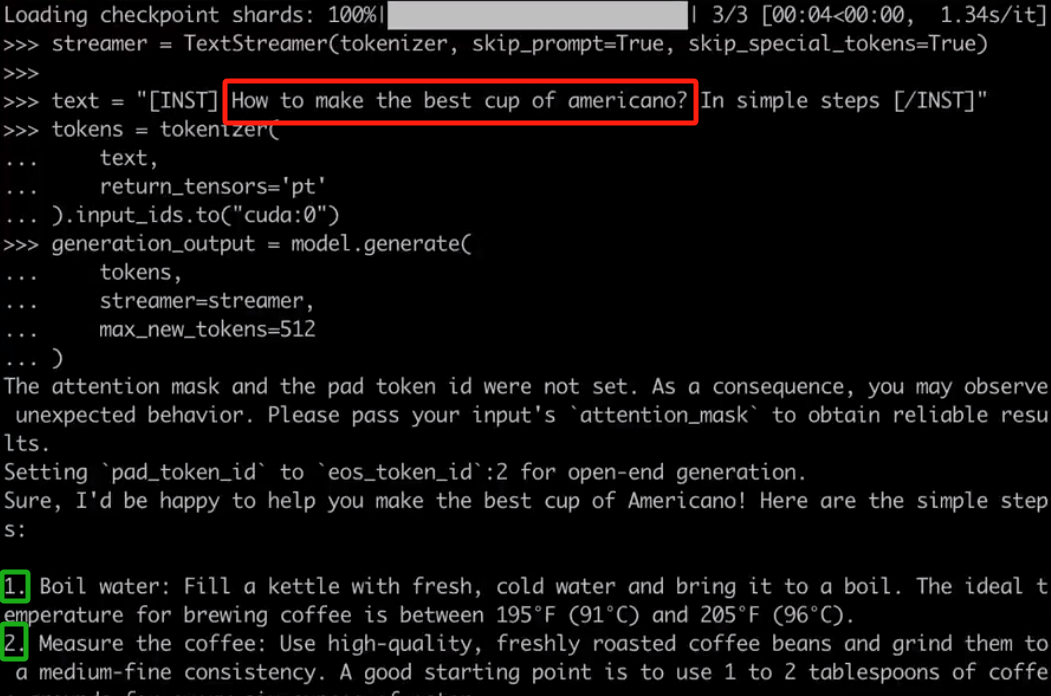

?當(dāng)你配置好項(xiàng)目后,就可以與 Mixtral 進(jìn)行對(duì)話(huà),例如對(duì)于用戶(hù)要求「如何做出最好的美式咖啡?通過(guò)簡(jiǎn)單的步驟完成」,Mixtral 會(huì)按照 1、2、3 等步驟進(jìn)行回答。

?當(dāng)你配置好項(xiàng)目后,就可以與 Mixtral 進(jìn)行對(duì)話(huà),例如對(duì)于用戶(hù)要求「如何做出最好的美式咖啡?通過(guò)簡(jiǎn)單的步驟完成」,Mixtral 會(huì)按照 1、2、3 等步驟進(jìn)行回答。

項(xiàng)目中使用的代碼:

Srivastav 表示上述實(shí)現(xiàn)也意味著用戶(hù)可以使用 AWQ 運(yùn)行所有的 Mixtral 微調(diào),并使用 Flash Attention 2 來(lái)提升它們。 看到這項(xiàng)研究后,網(wǎng)友不禁表示:真的很酷。

?

?

-

代碼

+關(guān)注

關(guān)注

30文章

4897瀏覽量

70579 -

GPT

+關(guān)注

關(guān)注

0文章

368瀏覽量

16056 -

OpenAI

+關(guān)注

關(guān)注

9文章

1206瀏覽量

8842

原文標(biāo)題:8x7B MoE與Flash Attention 2結(jié)合,不到10行代碼實(shí)現(xiàn)快速推理

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

華為宣布開(kāi)源盤(pán)古7B稠密和72B混合專(zhuān)家模型

華為正式開(kāi)源盤(pán)古7B稠密和72B混合專(zhuān)家模型

帶增益的 RX 分集 FEM(B26、B8、B20、B1/4、B3 和 B7) skyworksinc

具有載波聚合的 RX 分集 FEM(B26、B8、B12/13、B2/25、B4 和 B7) skyworksinc

潤(rùn)和軟件StackRUNS異構(gòu)分布式推理框架的應(yīng)用案例

代碼革命的先鋒:aiXcoder-7B模型介紹

基于小凌派RK2206開(kāi)發(fā)板:OpenHarmony如何使用IoT接口控制FLASH外設(shè)

7路達(dá)林頓驅(qū)動(dòng)的16KB Flash ROM的AD型MCU AiP8F3201

基于1F1B的MoE A2A通信計(jì)算Overlap

摩爾線程Round Attention優(yōu)化AI對(duì)話(huà)

Flexus X 實(shí)例 C#/.Net Core 結(jié)合(git 代碼管理、docker 自定義鏡像)快速發(fā)布部署 - 讓你的項(xiàng)目飛起來(lái)~

獵戶(hù)星空發(fā)布Orion-MoE 8×7B大模型及AI數(shù)據(jù)寶AirDS

CC13x2x7和CC26x2x7 SimpleLink無(wú)線MCU技術(shù)參考手冊(cè)

阿里Qwen2-Math系列震撼發(fā)布,數(shù)學(xué)推理能力領(lǐng)跑全球

PerfXCloud順利接入MOE大模型DeepSeek-V2

8x7B MoE與Flash Attention 2結(jié)合,不到10行代碼實(shí)現(xiàn)快速推理

8x7B MoE與Flash Attention 2結(jié)合,不到10行代碼實(shí)現(xiàn)快速推理

評(píng)論