在這篇 NeurIPS23 論文中,來(lái)自魯汶大學(xué)、新加坡國(guó)立大學(xué)和中科院自動(dòng)化所的研究者提出了一種視覺 「讀腦術(shù)」,能夠從人類的大腦活動(dòng)中以高分辨率出解析出人眼觀看到的圖像。

人類的感知不僅由客觀刺激塑造,而且深受過往經(jīng)驗(yàn)的影響,這些共同促成了大腦中的復(fù)雜活動(dòng)。在認(rèn)知神經(jīng)科學(xué)領(lǐng)域,解碼大腦活動(dòng)中的視覺信息成為了一項(xiàng)關(guān)鍵任務(wù)。功能性磁共振成像(fMRI)作為一種高效的非侵入性技術(shù),在恢復(fù)和分析視覺信息,如圖像類別方面發(fā)揮著重要作用。

然而,由于 fMRI 信號(hào)的噪聲特性和大腦視覺表征的復(fù)雜性,這一任務(wù)面臨著不小的挑戰(zhàn)。針對(duì)這一問題,本文提出了一個(gè)雙階段 fMRI 表征學(xué)習(xí)框架,旨在識(shí)別并去除大腦活動(dòng)中的噪聲,并專注于解析對(duì)視覺重建至關(guān)重要的神經(jīng)激活模式,成功從大腦活動(dòng)中重建出高分辨率且語(yǔ)義上準(zhǔn)確的圖像。

論文鏈接:https://arxiv.org/abs/2305.17214

項(xiàng)目鏈接:https://github.com/soinx0629/vis_dec_neurips/

論文中提出的方法基于雙重對(duì)比學(xué)習(xí)、跨模態(tài)信息交叉及擴(kuò)散模型,在相關(guān) fMRI 數(shù)據(jù)集上取得了相對(duì)于以往最好模型接近 40% 的評(píng)測(cè)指標(biāo)提升,在生成圖像的質(zhì)量、可讀性及語(yǔ)義相關(guān)性相對(duì)于已有方法均有肉眼可感知的提升。該工作有助于理解人腦的視覺感知機(jī)制,有益于推動(dòng)視覺的腦機(jī)接口技術(shù)的研究。相關(guān)代碼均已開源。

功能性磁共振成像(fMRI)雖廣泛用于解析神經(jīng)反應(yīng),但從其數(shù)據(jù)中準(zhǔn)確重建視覺圖像仍具挑戰(zhàn),主要因?yàn)?fMRI 數(shù)據(jù)包含多種來(lái)源的噪聲,這些噪聲可能掩蓋神經(jīng)激活模式,增加解碼難度。此外,視覺刺激引發(fā)的神經(jīng)反應(yīng)過程復(fù)雜多階段,使得 fMRI 信號(hào)呈現(xiàn)非線性的復(fù)雜疊加,難以逆轉(zhuǎn)并解碼。

傳統(tǒng)的神經(jīng)解碼方式,例如嶺回歸,盡管被用于將 fMRI 信號(hào)與相應(yīng)刺激關(guān)聯(lián),卻常常無(wú)法有效捕捉刺激和神經(jīng)反應(yīng)之間的非線性關(guān)系。近期,深度學(xué)習(xí)技術(shù),如生成對(duì)抗網(wǎng)絡(luò)(GAN)和潛在擴(kuò)散模型(LDMs),已被采用以更準(zhǔn)確地建模這種復(fù)雜關(guān)系。然而,將視覺相關(guān)的大腦活動(dòng)從噪聲中分離出來(lái),并準(zhǔn)確進(jìn)行解碼,依然是該領(lǐng)域的主要挑戰(zhàn)之一。

為了應(yīng)對(duì)這些挑戰(zhàn),該工作提出了一個(gè)雙階段 fMRI 表征學(xué)習(xí)框架,該方法能夠有效識(shí)別并去除大腦活動(dòng)中的噪聲,并專注于解析對(duì)視覺重建至關(guān)重要的神經(jīng)激活模式。該方法在生成高分辨率及語(yǔ)義準(zhǔn)確的圖像方面,其 50 分類的 Top-1 準(zhǔn)確率超過現(xiàn)有最先進(jìn)技術(shù) 39.34%。

方法概述

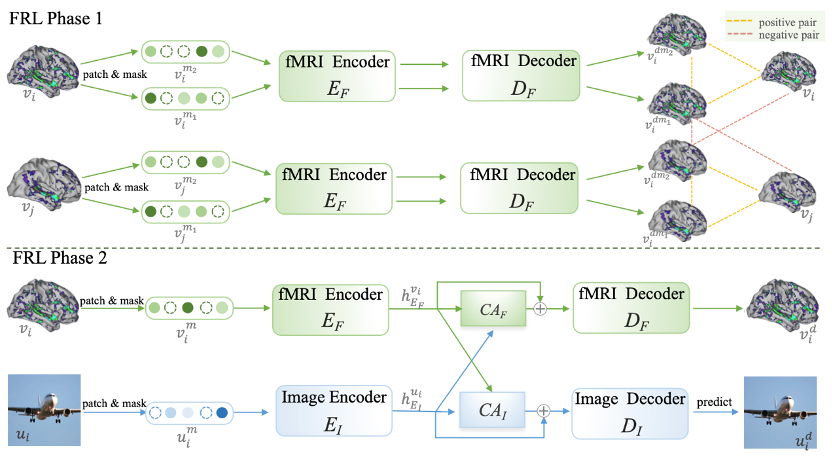

fMRI 表征學(xué)習(xí) (FRL)

第一階段:預(yù)訓(xùn)練雙對(duì)比掩模自動(dòng)編碼器 (DC-MAE)

為了在不同人群中區(qū)分共有的大腦活動(dòng)模式和個(gè)體噪聲,本文引入了 DC-MAE 技術(shù),利用未標(biāo)記數(shù)據(jù)對(duì) fMRI 表征進(jìn)行預(yù)訓(xùn)練。DC-MAE 包含一個(gè)編碼器 和一個(gè)解碼器

和一個(gè)解碼器 ,其中

,其中 以遮蔽的 fMRI 信號(hào)為輸入,

以遮蔽的 fMRI 信號(hào)為輸入, ?則被訓(xùn)練以預(yù)測(cè)未遮蔽的 fMRI 信號(hào)。所謂的 “雙重對(duì)比” 是指模型在 fMRI 表征學(xué)習(xí)中優(yōu)化對(duì)比損失并參與了兩個(gè)不同的對(duì)比過程。

?則被訓(xùn)練以預(yù)測(cè)未遮蔽的 fMRI 信號(hào)。所謂的 “雙重對(duì)比” 是指模型在 fMRI 表征學(xué)習(xí)中優(yōu)化對(duì)比損失并參與了兩個(gè)不同的對(duì)比過程。

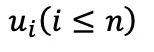

在第一階段的對(duì)比學(xué)習(xí)中,每個(gè)包含 n 個(gè) fMRI 樣本 v 的批次中的樣本 被隨機(jī)遮蔽兩次,生成兩個(gè)不同的遮蔽版本

被隨機(jī)遮蔽兩次,生成兩個(gè)不同的遮蔽版本 和

和 ,作為對(duì)比的正樣本對(duì)。隨后,1D 卷積層將這兩個(gè)版本轉(zhuǎn)換為嵌入式表示,分別輸入至 fMRI 編碼器

,作為對(duì)比的正樣本對(duì)。隨后,1D 卷積層將這兩個(gè)版本轉(zhuǎn)換為嵌入式表示,分別輸入至 fMRI 編碼器 。解碼器

。解碼器 ?接收這些編碼的潛在表示,產(chǎn)生預(yù)測(cè)值

?接收這些編碼的潛在表示,產(chǎn)生預(yù)測(cè)值 和

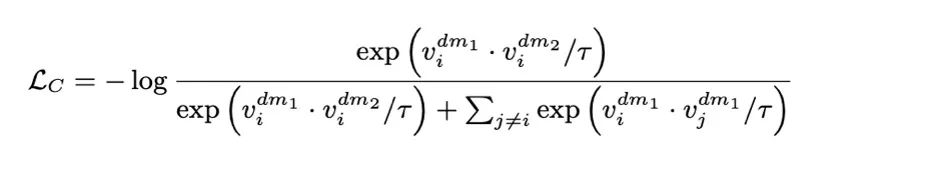

和 。通過 InfoNCE 損失函數(shù)計(jì)算的第一次對(duì)比損失,即交叉對(duì)比損失,來(lái)優(yōu)化模型:

。通過 InfoNCE 損失函數(shù)計(jì)算的第一次對(duì)比損失,即交叉對(duì)比損失,來(lái)優(yōu)化模型:

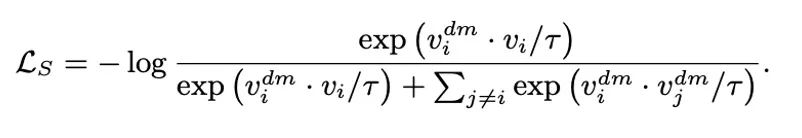

在第二階段對(duì)比學(xué)習(xí)中,每個(gè)未遮蔽的原始圖像 及其相應(yīng)的遮蔽圖像

及其相應(yīng)的遮蔽圖像 形成一對(duì)天然正樣本。這里的

形成一對(duì)天然正樣本。這里的 代表解碼器

代表解碼器 預(yù)測(cè)出的圖像。第二次對(duì)比損失,也就是自對(duì)比損失,根據(jù)以下公式進(jìn)行計(jì)算:

預(yù)測(cè)出的圖像。第二次對(duì)比損失,也就是自對(duì)比損失,根據(jù)以下公式進(jìn)行計(jì)算:

優(yōu)化自對(duì)比損失 能夠?qū)崿F(xiàn)遮蔽重建。無(wú)論是

能夠?qū)崿F(xiàn)遮蔽重建。無(wú)論是 還是

還是 ,負(fù)樣本

,負(fù)樣本 都來(lái)自同一批次的實(shí)例。

都來(lái)自同一批次的實(shí)例。 和

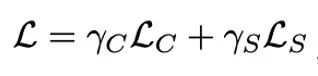

和 共同按如下方式優(yōu)化:

共同按如下方式優(yōu)化: ,其中超參數(shù)

,其中超參數(shù) 和

和 用于調(diào)節(jié)各損失項(xiàng)的權(quán)重。

用于調(diào)節(jié)各損失項(xiàng)的權(quán)重。

-

第二階段:使用跨模態(tài)指導(dǎo)進(jìn)行調(diào)整

考慮到 fMRI 記錄的信噪比較低且高度卷積的特性,專注于與視覺處理最相關(guān)且對(duì)重建最有信息價(jià)值的大腦激活模式對(duì) fMRI 特征學(xué)習(xí)器來(lái)說至關(guān)重要。

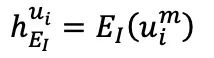

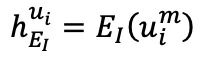

在第一階段預(yù)訓(xùn)練后,fMRI 自編碼器通過圖像輔助進(jìn)行調(diào)整,以實(shí)現(xiàn) fMRI 的重建,第二階段同樣遵循此過程。具體而言,從 n 個(gè)樣本批次中選擇一個(gè)樣本 及其對(duì)應(yīng)的 fMRI 記錄的神經(jīng)反應(yīng)

及其對(duì)應(yīng)的 fMRI 記錄的神經(jīng)反應(yīng) 。

。 和

和 經(jīng)過分塊和隨機(jī)遮蔽處理,分別轉(zhuǎn)變?yōu)?/span>

經(jīng)過分塊和隨機(jī)遮蔽處理,分別轉(zhuǎn)變?yōu)?/span> 和

和 ,然后分別輸入到圖像編碼器

,然后分別輸入到圖像編碼器 和 fMRI 編碼器

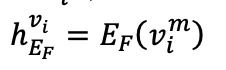

和 fMRI 編碼器 中,生成

中,生成 和

和 。為重建 fMRI

。為重建 fMRI ,利用交叉注意力模塊將

,利用交叉注意力模塊將 和

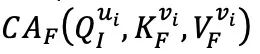

和 進(jìn)行合并:

進(jìn)行合并:

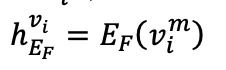

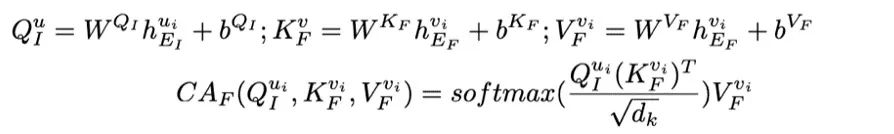

W 和 b 分別代表相應(yīng)線性層的權(quán)重和偏置。 是縮放因子,

是縮放因子, 是鍵向量的維度。CA 是交叉注意力(cross-attention)的縮寫。

是鍵向量的維度。CA 是交叉注意力(cross-attention)的縮寫。 加上

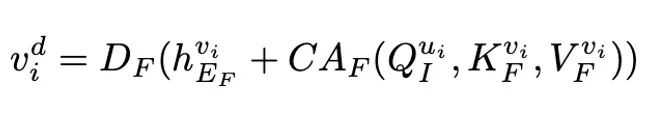

加上 后,輸入到 fMRI 解碼器中以重建

后,輸入到 fMRI 解碼器中以重建 ,得到

,得到 :

:

圖像自編碼器中也進(jìn)行了類似的計(jì)算,圖像編碼器 的輸出

的輸出 通過交叉注意力模塊

通過交叉注意力模塊 與

與 的輸出合并,然后用于解碼圖像

的輸出合并,然后用于解碼圖像 ,得到

,得到 :

:

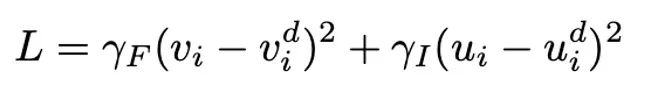

通過優(yōu)化以下?lián)p失函數(shù),fMRI 和圖像自編碼器共同進(jìn)行訓(xùn)練:

使用潛在擴(kuò)散模型 (LDM) 生成圖像

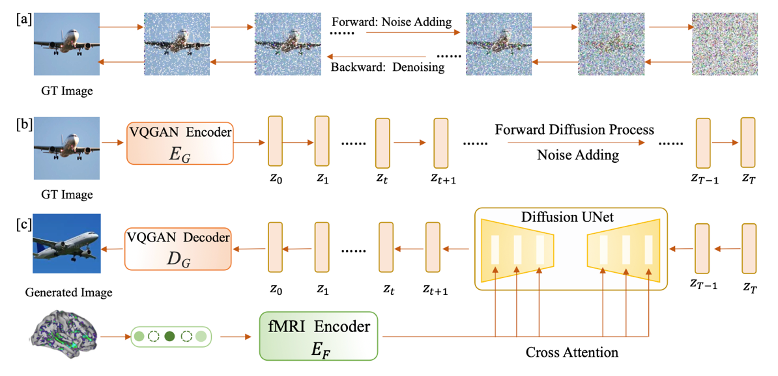

在完成 FRL 第一階段和第二階段的訓(xùn)練后,使用 fMRI 特征學(xué)習(xí)器的編碼器 來(lái)驅(qū)動(dòng)一個(gè)潛在擴(kuò)散模型(LDM),從大腦活動(dòng)生成圖像。如圖所示,擴(kuò)散模型包括一個(gè)向前的擴(kuò)散過程和一個(gè)逆向去噪過程。向前過程逐漸將圖像降解為正態(tài)高斯噪聲,通過逐漸引入變方差的高斯噪聲。

來(lái)驅(qū)動(dòng)一個(gè)潛在擴(kuò)散模型(LDM),從大腦活動(dòng)生成圖像。如圖所示,擴(kuò)散模型包括一個(gè)向前的擴(kuò)散過程和一個(gè)逆向去噪過程。向前過程逐漸將圖像降解為正態(tài)高斯噪聲,通過逐漸引入變方差的高斯噪聲。

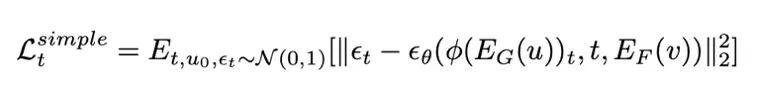

該研究通過從預(yù)訓(xùn)練的標(biāo)簽至圖像潛在擴(kuò)散模型(LDM)中提取視覺知識(shí),并利用 fMRI 數(shù)據(jù)作為條件生成圖像。這里采用交叉注意力機(jī)制,將 fMRI 信息融入 LDM,遵循穩(wěn)定擴(kuò)散研究的建議。為了強(qiáng)化條件信息的作用,這里采用了交叉注意力和時(shí)間步條件化的方法。在訓(xùn)練階段,使用 VQGAN 編碼器 和經(jīng) FRL 第一和第二階段訓(xùn)練的 fMRI 編碼器

和經(jīng) FRL 第一和第二階段訓(xùn)練的 fMRI 編碼器 處理圖像 u 和 fMRI v,并在保持 LDM 不變的情況下微調(diào) fMRI 編碼器,損失函數(shù)為:

處理圖像 u 和 fMRI v,并在保持 LDM 不變的情況下微調(diào) fMRI 編碼器,損失函數(shù)為:

其中, 是擴(kuò)散模型的噪聲計(jì)劃。在推理階段,過程從時(shí)間步長(zhǎng) T 的標(biāo)準(zhǔn)高斯噪聲開始,LDM 依次遵循逆向過程逐步去除隱藏表征的噪聲,條件化在給定的 fMRI 信息上。當(dāng)?shù)竭_(dá)時(shí)間步長(zhǎng)零時(shí),使用 VQGAN 解碼器

是擴(kuò)散模型的噪聲計(jì)劃。在推理階段,過程從時(shí)間步長(zhǎng) T 的標(biāo)準(zhǔn)高斯噪聲開始,LDM 依次遵循逆向過程逐步去除隱藏表征的噪聲,條件化在給定的 fMRI 信息上。當(dāng)?shù)竭_(dá)時(shí)間步長(zhǎng)零時(shí),使用 VQGAN 解碼器 將隱藏表征轉(zhuǎn)換為圖像。

將隱藏表征轉(zhuǎn)換為圖像。

實(shí)驗(yàn)

重建結(jié)果

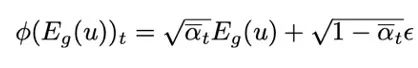

通過與 DC-LDM、IC-GAN 和 SS-AE 等先前研究的對(duì)比,并在 GOD 和 BOLD5000 數(shù)據(jù)集上的評(píng)估中顯示,該研究提出的模型在準(zhǔn)確率上顯著超過這些模型,其中相對(duì)于 DC-LDM 和 IC-GAN 分別提高了 39.34% 和 66.7%

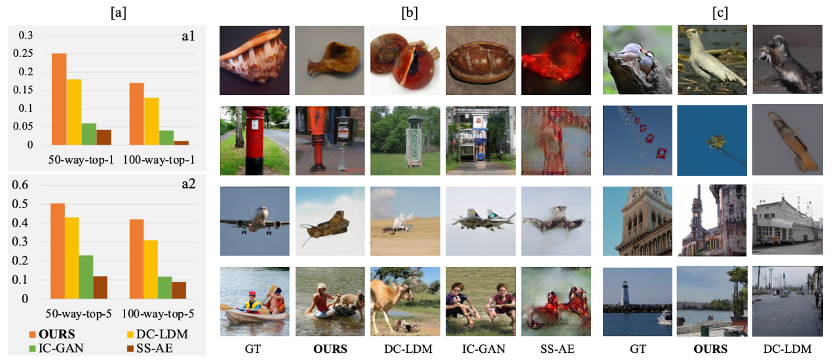

在 GOD 數(shù)據(jù)集的其他四名受試者上的評(píng)估顯示,即使在允許 DC-LDM 在測(cè)試集上進(jìn)行調(diào)整的情況下,該研究提出的模型在 50 種方式的 Top-1 分類準(zhǔn)確率上也顯著優(yōu)于 DC-LDM,證明了提出的模型在不同受試者大腦活動(dòng)重建方面的可靠性和優(yōu)越性。

實(shí)驗(yàn)結(jié)果表明,利用所提出的 fMRI 表示學(xué)習(xí)框架和預(yù)先訓(xùn)練的 LDM,可以更好的重建大腦的視覺活動(dòng),大大優(yōu)于目前的基線。該工作有助于進(jìn)一步挖掘神經(jīng)解碼模型的潛力。

原文標(biāo)題:NeurIPS23|視覺 「讀腦術(shù)」:從大腦活動(dòng)中重建你眼中的世界

文章出處:【微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

物聯(lián)網(wǎng)

+關(guān)注

關(guān)注

2927文章

45822瀏覽量

387399

原文標(biāo)題:NeurIPS23|視覺 「讀腦術(shù)」:從大腦活動(dòng)中重建你眼中的世界

文章出處:【微信號(hào):tyutcsplab,微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

具身智能×邊緣計(jì)算:AI的“大腦”和“身體”如何聯(lián)手闖蕩世界?

腦電基礎(chǔ)系列之腦電電極的分類與技術(shù)對(duì)比

腦電偽跡系列之腦電偽跡處理與技術(shù)剖析

腦電偽跡全解析:類型、成因與影響

Meta非入侵式腦機(jī)技術(shù):AI讀取大腦信號(hào)打字準(zhǔn)確率80%

如何才從ADS1118中讀回命令寄存器中的值呢?

使用ADS1299進(jìn)行腦電信號(hào)采集時(shí)采集不到腦電信號(hào),怎么解決?

解鎖機(jī)器人視覺與人工智能的潛力,從“盲人機(jī)器”改造成有視覺能力的機(jī)器人(上)

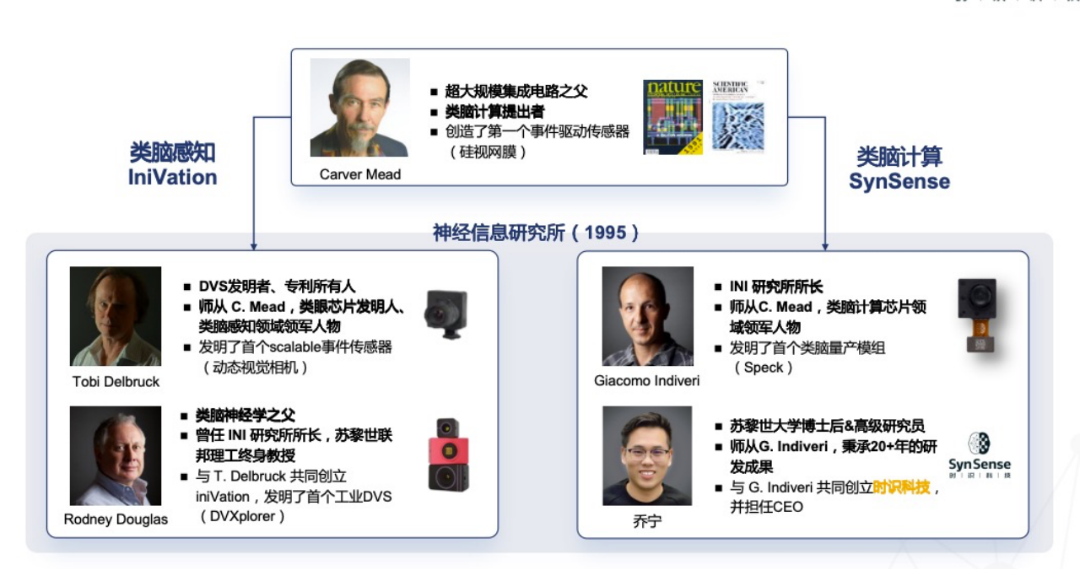

SynSense時(shí)識(shí)科技收購(gòu)瑞士類腦視覺傳感器公司iniVation 100%股權(quán)

SynSense時(shí)識(shí)科技成功收購(gòu)瑞士類腦視覺傳感器公司iniVation,類腦智能航母蓄勢(shì)待發(fā)

腦機(jī)接囗疲勞預(yù)測(cè)解決方案

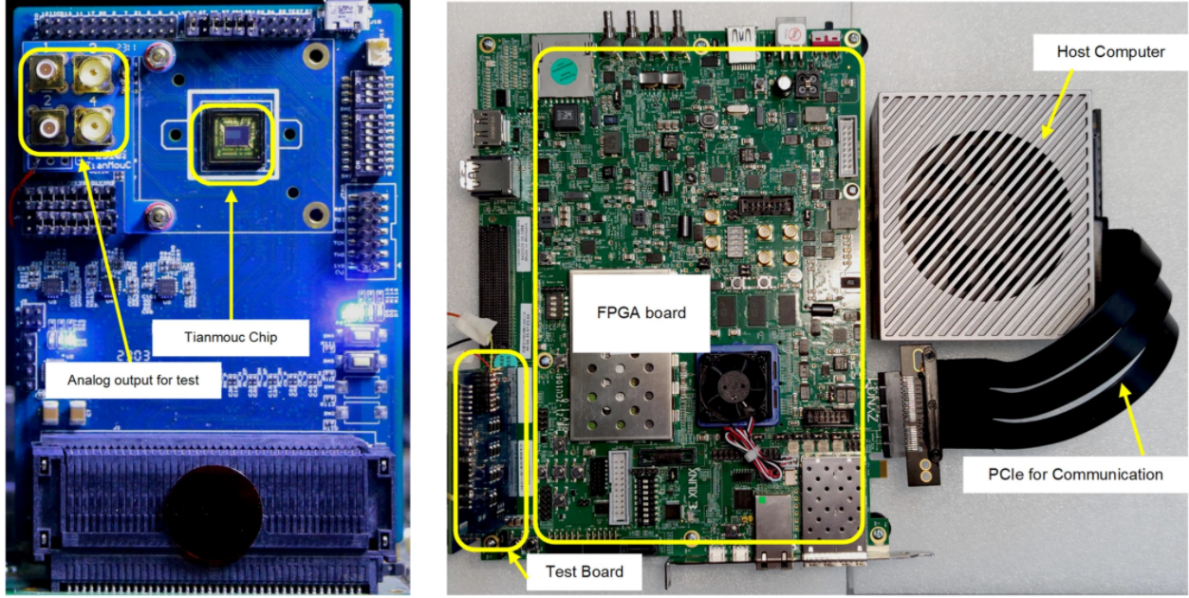

基于FPGA的類腦計(jì)算平臺(tái) —PYNQ 集群的無(wú)監(jiān)督圖像識(shí)別類腦計(jì)算系統(tǒng)

機(jī)器視覺應(yīng)用之檢測(cè) 遠(yuǎn)景達(dá)工業(yè)讀碼器行業(yè)知識(shí)

世界首款!又是清華:類腦互補(bǔ)視覺芯片“天眸芯”

清華類腦視覺芯片取得重大突破,“天眸芯”登上Nature封面

NeurIPS23|視覺 「讀腦術(shù)」:從大腦活動(dòng)中重建你眼中的世界

NeurIPS23|視覺 「讀腦術(shù)」:從大腦活動(dòng)中重建你眼中的世界

評(píng)論