YOLOv6人臉檢測模型

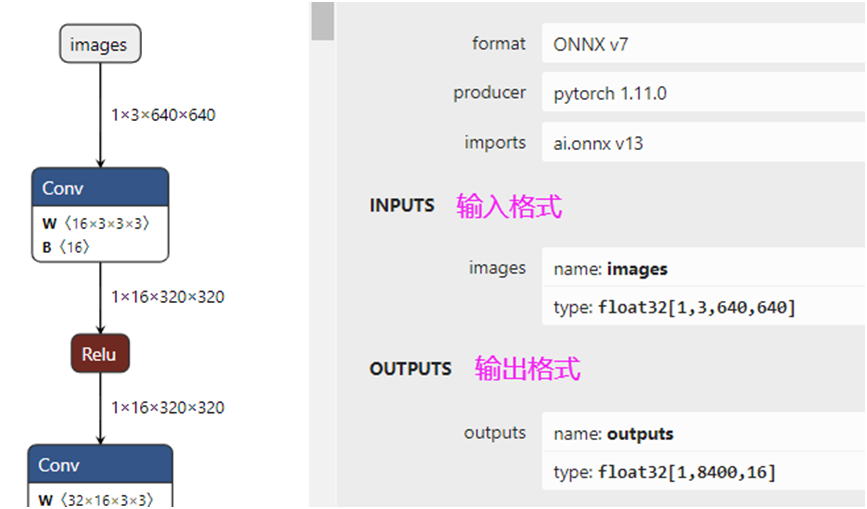

YOLOv6上次(應(yīng)該是很久以前)發(fā)布了一個(gè)0.3.1版本,支持人臉檢測與五點(diǎn)landmark調(diào)用,后來我就下載,想使用一下,發(fā)現(xiàn)居然沒有文檔,也沒有例子。但是官方有個(gè)infer.py文件是可以調(diào)用的,說明這個(gè)模型文件應(yīng)該沒問題。下載打開模型文件的輸入與輸出結(jié)構(gòu)如下:

輸出格式8400x16,其中16的輸出表示為人臉框+landmark坐標(biāo)信息。xyxy, conf, cls, lmdks,前面四個(gè)是Box信息、后面是置信度與分類得分、最后是10個(gè)值五點(diǎn)XY坐標(biāo)

輸出解析順序

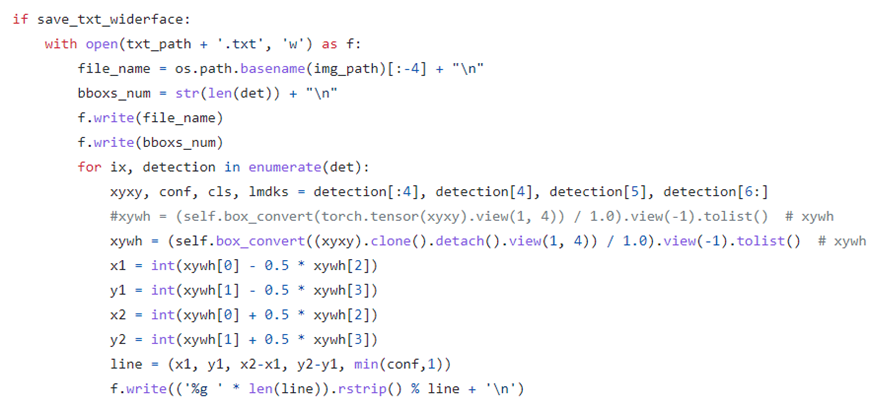

官方代碼與參考文檔給出的解析順序,xyxy, conf, cls, lmdks,這部分還有官方的參考文件:

https://github.com/meituan/YOLOv6/blob/yolov6-face/yolov6/core/inferer.py

第110行就是這樣說明的,于是我按上述格式一通解析,結(jié)果讓我崩潰了,輸入圖像與解析結(jié)果如下:

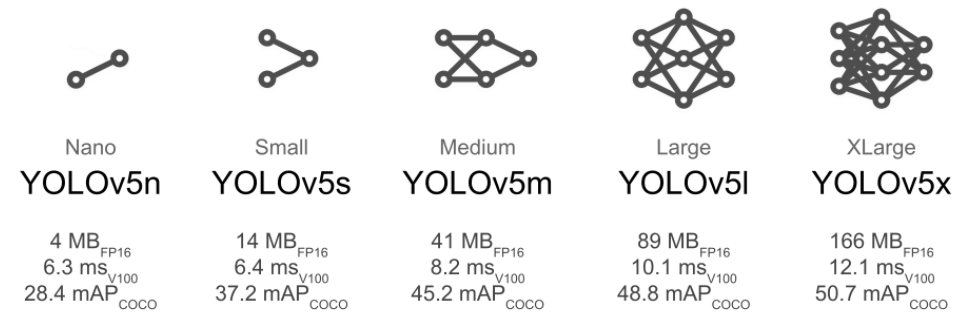

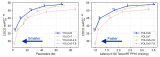

這個(gè)時(shí)候我才明白為什么這個(gè)發(fā)布了這么久,網(wǎng)上居然一篇文章關(guān)于YOLOv6人臉檢測的文章都沒有,網(wǎng)上的文章很多都是YOLOv5跟YOLOv7的人臉+Landmark檢測,原因一切都是有原因的。 我debug一下,發(fā)現(xiàn)預(yù)測出來的16個(gè)值,只有最后兩個(gè)值的結(jié)果是小于或者等于1的,所以我當(dāng)時(shí)猜想16個(gè)順序應(yīng)該是:xyxy, lmdks, conf, cls,按照我猜測的順序我又改下代碼,然后直接運(yùn)行測試,奇跡出現(xiàn)了:

這張圖是AI生成的,如有雷同純屬巧合! 整個(gè)推理的流程跟YOLOv5、YOLOv6對象檢測一樣,就是后處理不同,所以附上后處理部分的代碼:

defwrap_detection(self,input_image,out_data): confidences=[] boxes=[] kypts=[] rows=out_data.shape[0] image_width,image_height,_=input_image.shape x_factor=image_width/640.0 y_factor=image_height/640.0 sd=np.zeros((5,2),dtype=np.float32) sd[0:5]=(x_factor,y_factor) sd=np.squeeze(sd.reshape((-1,1)),1) #xyxy,lmdks,conf,cls, forrinrange(rows): row=out_data[r] conf=row[14] cls=row[15] if(conf>0.25andcls>0.25): confidences.append(conf) x,y,w,h=row[0].item(),row[1].item(),row[2].item(),row[3].item() left=int((x-0.5*w)*x_factor) top=int((y-0.5*h)*y_factor) width=int(w*x_factor) height=int(h*y_factor) box=np.array([left,top,width,height]) boxes.append(box) kypts.append(np.multiply(row[4:14],sd)) indexes=cv.dnn.NMSBoxes(boxes,confidences,0.25,0.25) result_confidences=[] result_boxes=[] result_kypts=[] foriinindexes: result_confidences.append(confidences[i]) result_boxes.append(boxes[i]) result_kypts.append(kypts[i]) returnresult_kypts,result_confidences,result_boxes

責(zé)任編輯:彭菁

-

模型

+關(guān)注

關(guān)注

1文章

3519瀏覽量

50411 -

代碼

+關(guān)注

關(guān)注

30文章

4900瀏覽量

70709 -

人臉檢測

+關(guān)注

關(guān)注

0文章

86瀏覽量

16848

原文標(biāo)題:YOLOv6 人臉Landmark檢測

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學(xué)堂】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

Yolov5算法解讀

怎樣使用PyTorch Hub去加載YOLOv5模型

YOLOv6中的用Channel-wise Distillation進(jìn)行的量化感知訓(xùn)練

YOLOv5網(wǎng)絡(luò)結(jié)構(gòu)解析

全志V853 在 NPU 轉(zhuǎn)換 YOLO V3 模型

yolov7 onnx模型在NPU上太慢了怎么解決?

YOLOv3的darknet模型先轉(zhuǎn)為caffe模型后再轉(zhuǎn)為fp32bmodel,模型輸出和原始模型輸出存在偏差是怎么回事?

一個(gè)YOLO系列的算法實(shí)現(xiàn)庫YOLOU

關(guān)于YOLOU中模型的測試

YOLOv8版本升級支持小目標(biāo)檢測與高分辨率圖像輸入

YOLOv6在LabVIEW中的推理部署(含源碼)

一文徹底搞懂YOLOv8【網(wǎng)絡(luò)結(jié)構(gòu)+代碼+實(shí)操】

YOLOv8+OpenCV實(shí)現(xiàn)DM碼定位檢測與解析

深度學(xué)習(xí)YOLOv3 模型設(shè)計(jì)的基本思想

YOLOv6模型文件的輸入與輸出結(jié)構(gòu)

YOLOv6模型文件的輸入與輸出結(jié)構(gòu)

評論