金融事件分析背景

在金融領(lǐng)域,事件是理解信息的有效載體,如何更好的理解和分析事件一直是金融領(lǐng)域研究的熱點(diǎn)。預(yù)訓(xùn)練模型技術(shù)在翻譯、搜索、生成等領(lǐng)域都體現(xiàn)了它強(qiáng)大的能力,應(yīng)用在金融事件分析中也取得非常顯著的進(jìn)步。

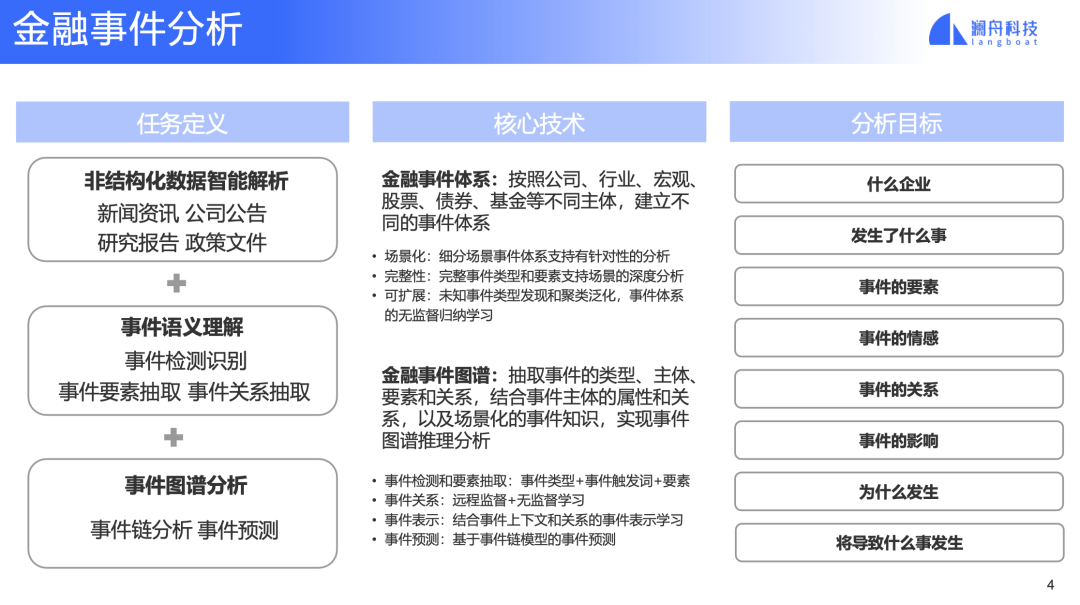

圖 1

金融事件分析的主要任務(wù)有三塊:

第一塊是非結(jié)構(gòu)化數(shù)據(jù)智能解析。金融領(lǐng)域的信息多數(shù)以非結(jié)構(gòu)化的數(shù)據(jù)形式存在,比如PDF。從非結(jié)構(gòu)數(shù)據(jù)中解析出重要的、準(zhǔn)確的、格式語(yǔ)義清楚的文本對(duì)后面的事件分析至關(guān)重要,它能有效減少噪音數(shù)據(jù)、臟數(shù)據(jù)對(duì)模型的干擾,提高結(jié)果的準(zhǔn)確度。

第二塊是事件語(yǔ)義理解。這里主要涉及事件類(lèi)型的檢測(cè)、事件要素的抽取和事件之間的關(guān)系,在這些對(duì)事件的理解基礎(chǔ)之上。

第三塊就可以構(gòu)建事件圖譜并進(jìn)行事件圖譜的分析,包括事件鏈分析和事件預(yù)測(cè)。

為了完成這些任務(wù),這里面涉及到的技術(shù)主要有兩個(gè):金融事件體系和金融事件圖譜。

金融領(lǐng)域,有不同的主體,不同的主體也有不一樣的場(chǎng)景,為了能最好的支持這些主體和場(chǎng)景,需要建立相應(yīng)的事件體系,這里面既有領(lǐng)域知識(shí)的人工工作,也結(jié)合技術(shù)做無(wú)監(jiān)督的歸納學(xué)習(xí),從而能夠提供場(chǎng)景化、完整性和可擴(kuò)展的事件體系。金融事件圖譜把事件分析技術(shù)集成在了一起,抽取事件和事件關(guān)系,學(xué)習(xí)事件的表示,然后結(jié)合圖的信息進(jìn)行預(yù)測(cè)。

有了這些技術(shù)和能力,我們對(duì)事件的分析,讓我們能夠回答諸如“這是一家什么公司的事?是一件什么事?人們對(duì)事情評(píng)價(jià)的情緒如何?為什么會(huì)發(fā)生?”等等。能夠回答這些問(wèn)題對(duì)金融領(lǐng)域的很多場(chǎng)景都是非常有價(jià)值的。

金融事件體系

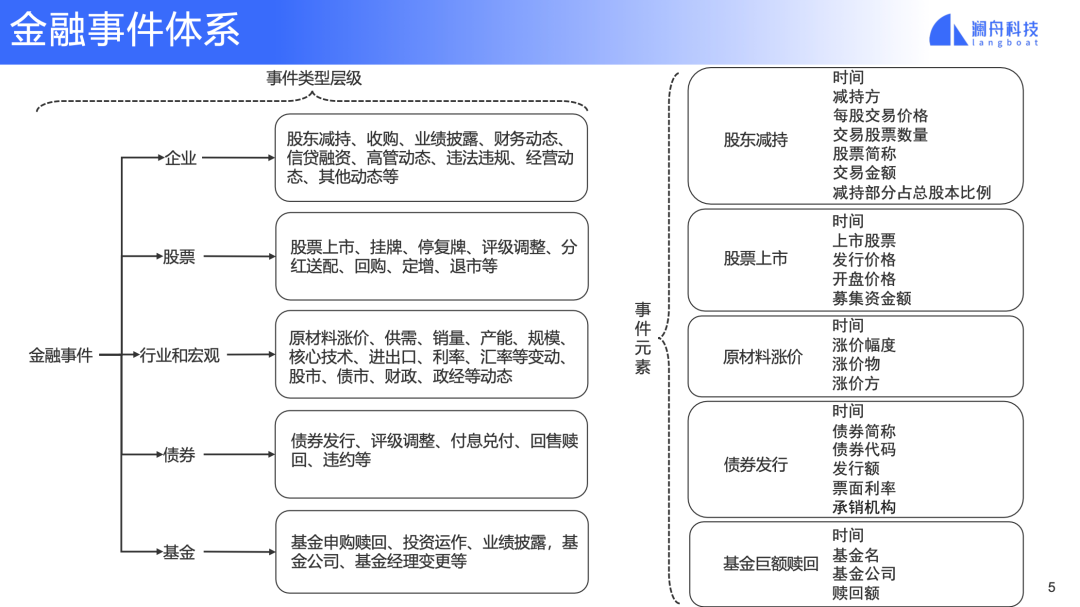

圖 2

圖 2 是一個(gè)金融事件體系的例子。我們將金融事件分為兩級(jí):

第一級(jí)根據(jù)事件的主體分為5類(lèi),分別是企業(yè)、股票、行業(yè)和宏觀、債券和基金。這些都是金融領(lǐng)域非常重要和常見(jiàn)的對(duì)象。

第二級(jí)將每種類(lèi)型主體事件的再進(jìn)行的細(xì)分,比如企業(yè)這個(gè)一級(jí)事件類(lèi)型下面有股東減持事件。那么最后,一個(gè)二級(jí)事件類(lèi)型將包含這個(gè)事件相關(guān)的主要元素。再拿股東減持為例,減持的時(shí)間,哪個(gè)股東減持,減持每股交易價(jià)格等等。

一個(gè)定義完整、對(duì)場(chǎng)景有針對(duì)性的事件體系,是事件分析最后能夠達(dá)成目標(biāo)的重要前提。比如股東減持事件沒(méi)有被減持的股票,你就沒(méi)有辦法了解當(dāng)前發(fā)生的事情影響了那家公司。

1. 事件圖譜

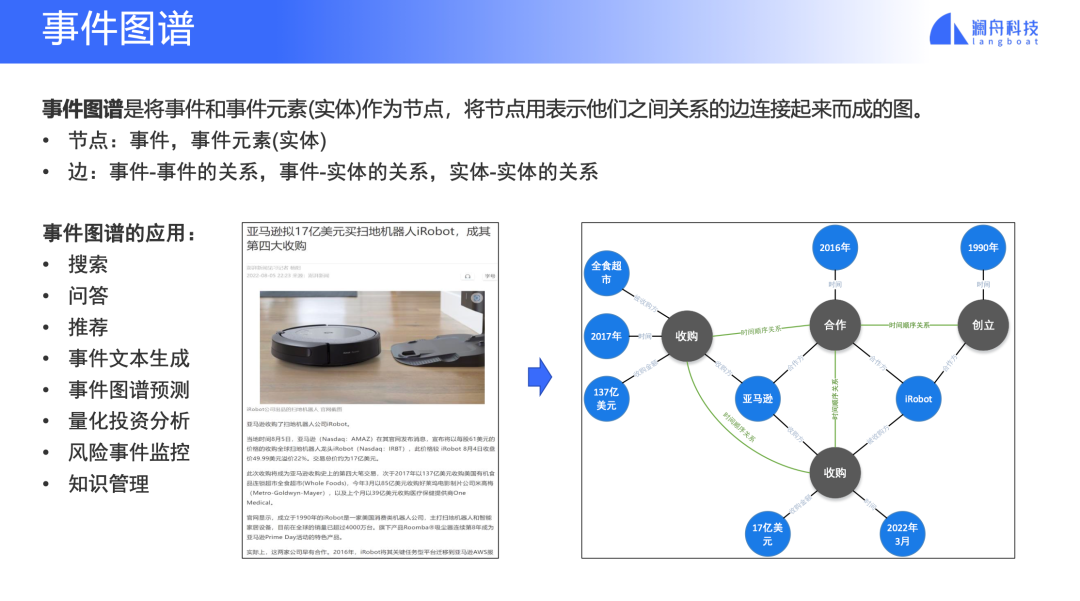

圖 3

事件圖譜首先是個(gè)「圖」,一個(gè)圖是由節(jié)點(diǎn)和邊組成。在事件圖譜中,節(jié)點(diǎn)可以是事件,也可以是事件的元素對(duì)應(yīng)的實(shí)體,比如公司。邊就是事件與事件間的關(guān)系,實(shí)體-事件間的關(guān)系,實(shí)體與實(shí)體間的關(guān)系。

我們來(lái)看一個(gè)例子,如圖 3 所示,這是一篇報(bào)道亞馬遜收購(gòu)iRobot公司的新聞。這篇報(bào)道中,一共有四個(gè)事件,其中兩個(gè)收購(gòu)事件,一個(gè)合作事件和一個(gè)創(chuàng)立公司事件,將這些事件連接起來(lái)的關(guān)系是時(shí)間順序關(guān)系。除了事件,這里面還有其他一些實(shí)體,比如公司和時(shí)間。這些實(shí)體和時(shí)間之間也由相應(yīng)的關(guān)系連接。這樣看來(lái),一個(gè)非結(jié)構(gòu)化網(wǎng)頁(yè)信息,通過(guò)解析出正文文本和段落,抽取事件和關(guān)系,建立事件圖譜,最終就轉(zhuǎn)化成了一個(gè)結(jié)構(gòu)化的信息。

結(jié)構(gòu)化的信息,更容易進(jìn)行理解和處理,可以應(yīng)用在搜索、問(wèn)答這樣的信息獲取場(chǎng)景,或者風(fēng)險(xiǎn)監(jiān)控、量化投資分析這樣的金融業(yè)務(wù)場(chǎng)景。

2. 事件鏈

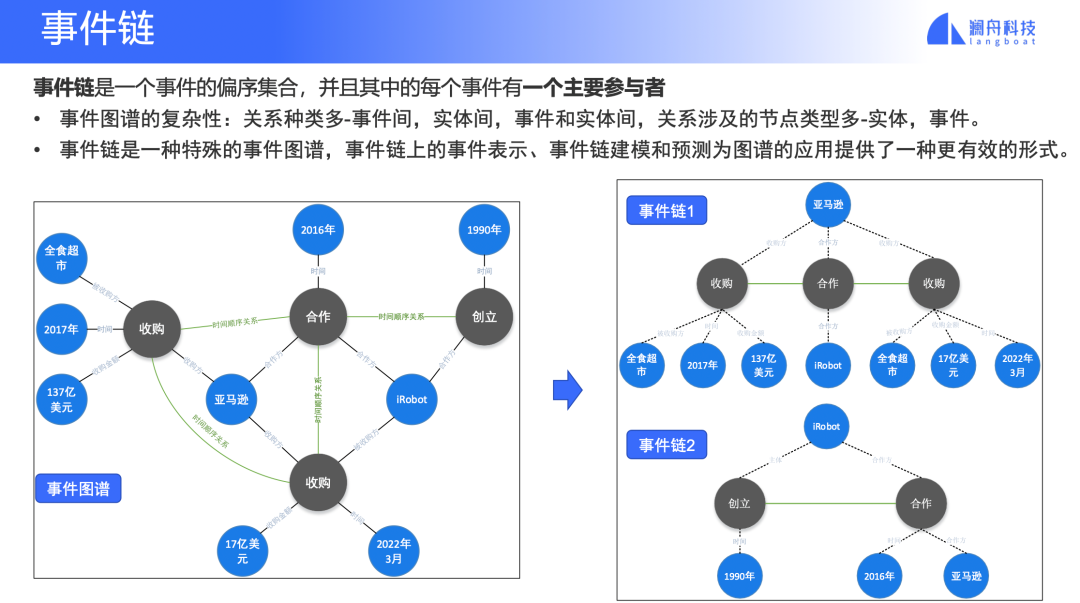

圖 4

事件鏈?zhǔn)鞘录D譜的一種特殊的、簡(jiǎn)化的形式,它主要關(guān)注一個(gè)參與者發(fā)生的一系列事件與事件之間的關(guān)系,是一個(gè)偏序事件集合。

圖 4 例子中,事件圖譜簡(jiǎn)化為兩個(gè)事件鏈,每個(gè)事件鏈中只有事件節(jié)點(diǎn),其他信息都是節(jié)點(diǎn)的屬性信息。這種簡(jiǎn)化對(duì)于將事件圖譜應(yīng)用落地是有很大幫助的,它的關(guān)系和節(jié)點(diǎn)類(lèi)型簡(jiǎn)化后,對(duì)圖譜的學(xué)習(xí)和處理都是只針對(duì)事件一種節(jié)點(diǎn)和事件間的一種關(guān)系。

那么基于事件鏈,如何對(duì)事件進(jìn)行預(yù)測(cè)呢?

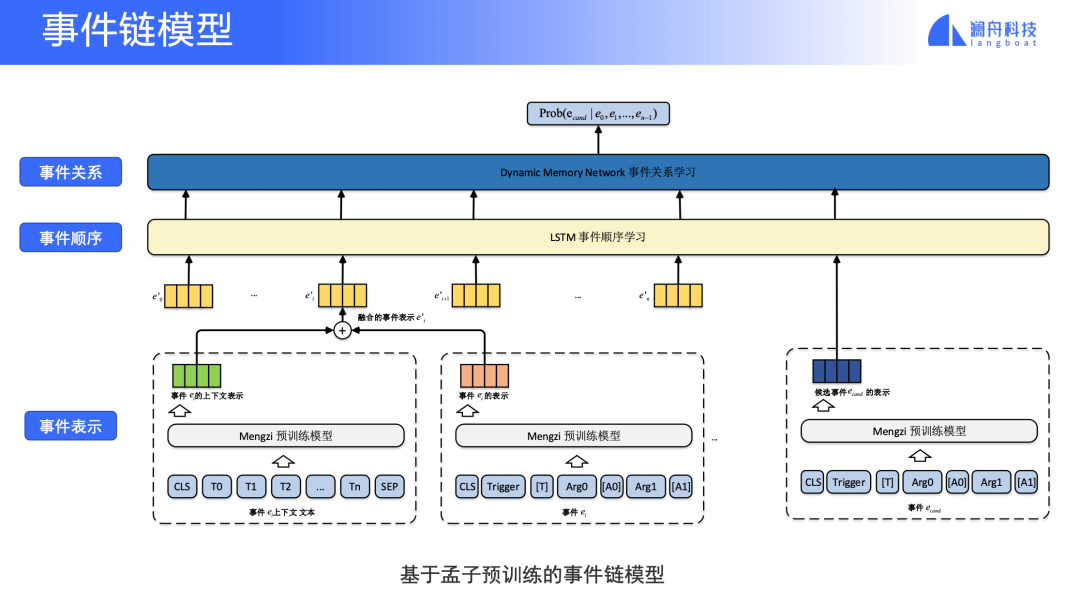

圖 5

基于事件鏈的時(shí)間預(yù)測(cè)模型主要有三部分,首先是對(duì)事件的表示,歷史事件和要預(yù)測(cè)的候選事件的表示是將事件觸發(fā)詞和事件元素拼接起來(lái)表示,為了更好的捕捉歷史事件信息,也將歷史事件的上下文表示和歷史事件的表示融合起來(lái),這些表示被輸入第二部分,一個(gè)LSTM網(wǎng)絡(luò),LSTM網(wǎng)絡(luò)可以將事件之間順序信息(哪些事件發(fā)生在哪些事件之前等)融入到事件的表示中。

最后將LSTM編碼后的每個(gè)事件信息傳入動(dòng)態(tài)記憶網(wǎng)絡(luò),這個(gè)網(wǎng)絡(luò)的設(shè)計(jì)是為了在事件鏈中對(duì)不同的事件,根據(jù)他他們與候選事件的關(guān)系,進(jìn)行加權(quán)。也就是說(shuō)跟候選事件聯(lián)系重要的具有更高的權(quán)重,最后計(jì)算給定歷史事件的情況下,候選事件發(fā)生的概率。

3. 事件問(wèn)答

基于事件鏈的事件預(yù)測(cè)能夠提供信息對(duì)還沒(méi)有發(fā)生的情況做判斷,事件分析也能夠幫助人們更好的了解已經(jīng)發(fā)生的情況,比如事件問(wèn)答。

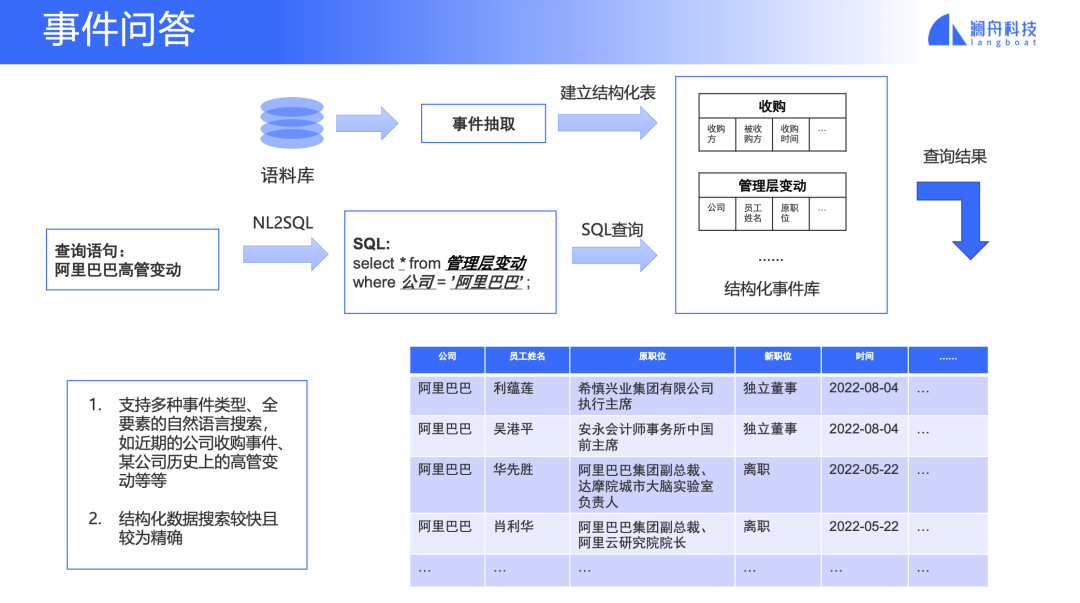

圖 6

事件問(wèn)答支持用自然語(yǔ)言對(duì)事件進(jìn)行語(yǔ)義查詢(xún)。比如查詢(xún)阿里巴巴的高管變動(dòng)。通過(guò)對(duì)語(yǔ)料進(jìn)行事件抽取,建立一個(gè)結(jié)構(gòu)化事件庫(kù),不同的事件類(lèi)型存放在不同的表中。利用NL2SQL技術(shù)對(duì)問(wèn)題理解后轉(zhuǎn)化為數(shù)據(jù)庫(kù)查詢(xún)SQL語(yǔ)句,找到對(duì)應(yīng)的表和符合條件的事件返回。

事件分析框架

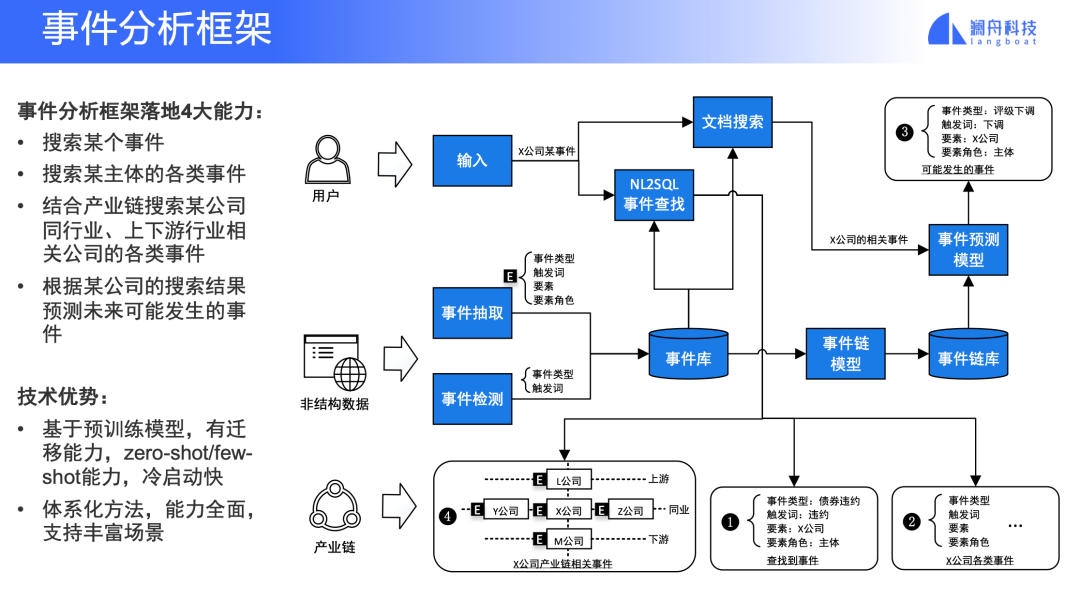

圖 7

綜合前面介紹的各種事件分析技術(shù)和應(yīng)用場(chǎng)景,一個(gè)完整的事件分析框架支持4大能力:搜索某個(gè)事,搜索某個(gè)主體的事件,結(jié)合產(chǎn)業(yè)鏈搜索等業(yè)務(wù)數(shù)據(jù)搜索相應(yīng)主體的公司,以及根據(jù)搜索到的一個(gè)主體的已經(jīng)發(fā)生的時(shí)間預(yù)測(cè)可能發(fā)生的事件。

瀾舟事件分析技術(shù)的最新進(jìn)展

接下來(lái)介紹我們?cè)谑录治鲱I(lǐng)域上的一些工作,時(shí)間所限,今天我將主要介紹兩個(gè)技術(shù):事件檢測(cè)和事件抽取。

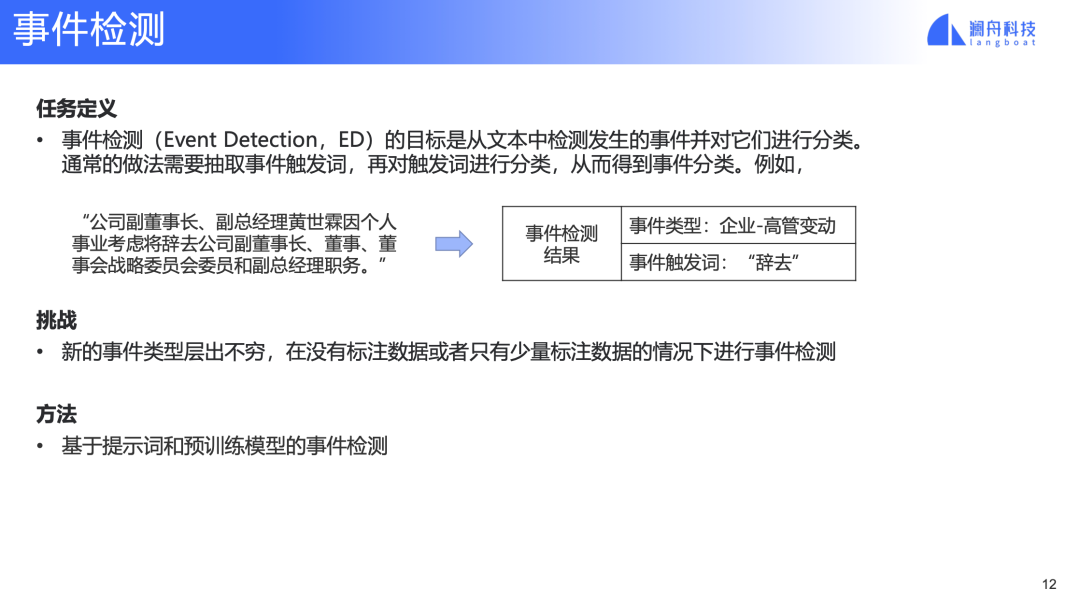

1. 事件檢測(cè)

圖 8

事件檢測(cè)是從文本中檢測(cè)是否有事件以及事件的類(lèi)型。通常還會(huì)抽取對(duì)應(yīng)事件類(lèi)型的觸發(fā)詞。例如,“公司副董事長(zhǎng)、副總經(jīng)理黃世霖因個(gè)人事業(yè)考慮將辭去公司副董事長(zhǎng)、董事、董事會(huì)戰(zhàn)略委員會(huì)委員和副總經(jīng)理職務(wù)”,事件檢測(cè)的結(jié)果是一個(gè)“企業(yè)-高管變動(dòng)”事件,觸發(fā)詞是“辭去”。

事件檢測(cè)的挑戰(zhàn)一個(gè)來(lái)自事件觸發(fā)詞的標(biāo)注,通常的事件檢測(cè)任務(wù)要求訓(xùn)練數(shù)據(jù)有觸發(fā)詞的標(biāo)注,標(biāo)注工作量大。另外一個(gè)是事件類(lèi)型的變化,有的時(shí)候是增加新的類(lèi)型,有的時(shí)候是對(duì)原有類(lèi)型進(jìn)行合并或者拆分,這些變化都涉及到標(biāo)注數(shù)據(jù)和模型的改變。

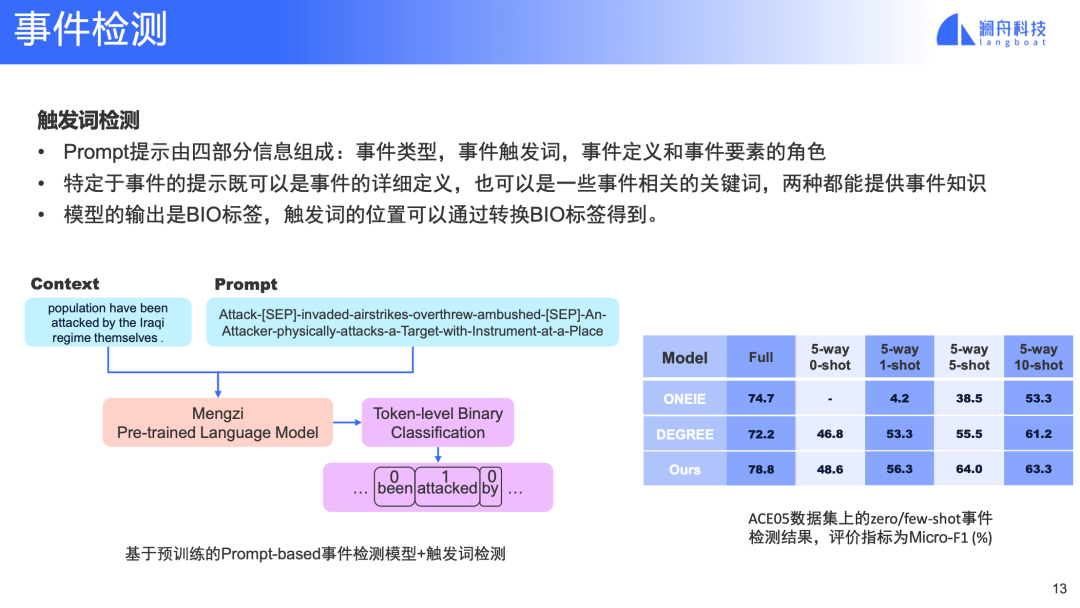

圖 9

針對(duì)上述挑戰(zhàn),我們使用了基于提示(也就是prompt)的事件檢測(cè)模型。事件檢測(cè)的prompt模板中拼接了四種信息,一種是事件類(lèi)型,另外一個(gè)是事件的觸發(fā)詞,觸發(fā)詞可以有多個(gè),還有就是事件的描述信息和事件元素的角色,這兩個(gè)信息會(huì)融合在一個(gè)字段中。

根據(jù)某個(gè)事件類(lèi)型的prompt,模型在輸入文本上進(jìn)行token的BIO標(biāo)簽分類(lèi),抽取相應(yīng)事件的觸發(fā)詞。如果針對(duì)當(dāng)前的prompt類(lèi)型能夠抽出觸發(fā)詞,則對(duì)應(yīng)的事件類(lèi)型和觸發(fā)詞就得到了。

對(duì)于zero-shot的情況,定義相應(yīng)事件類(lèi)型的prompt模型則可以進(jìn)行事件檢測(cè)了。為了對(duì)比SOTA方法的方便,我們?cè)谟⑽臄?shù)據(jù)集ACE05上進(jìn)行了實(shí)驗(yàn)。實(shí)驗(yàn)顯示,對(duì)比另外兩個(gè)事件模型,我們的方法在全量訓(xùn)練數(shù)據(jù)和zero-shot和few-shot上都有明顯的優(yōu)勢(shì)(見(jiàn)圖 9 右側(cè)表格)。

2. 事件抽取

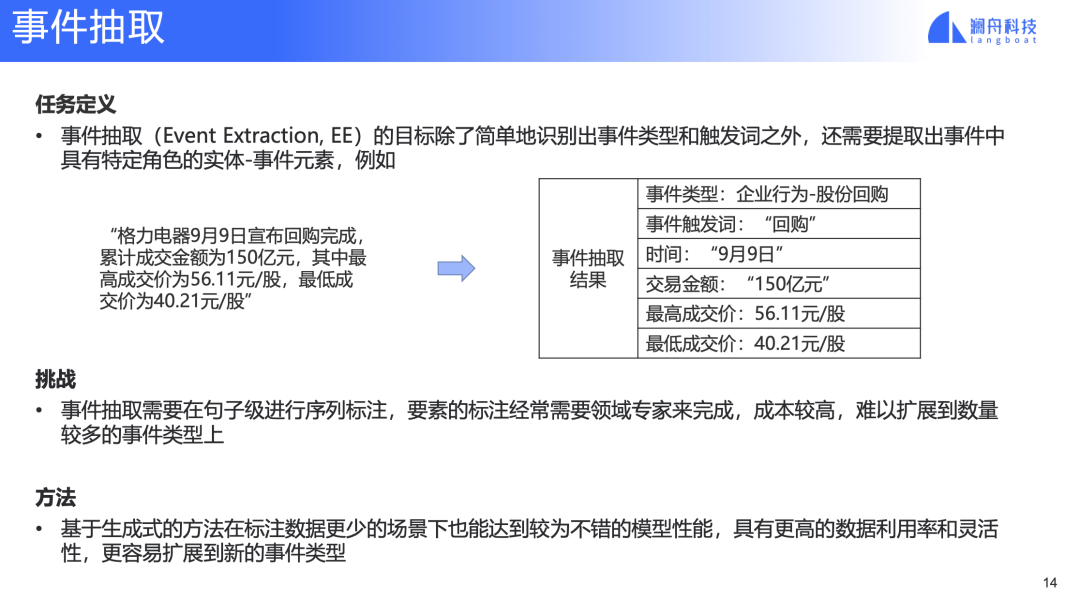

事件抽取任務(wù)是事件檢測(cè)任務(wù)的基礎(chǔ)上做了功能擴(kuò)展,它不僅檢測(cè)了事件類(lèi)型、觸發(fā)詞,還將事件的詳細(xì)信息抽取出來(lái)作為事件元素。例如,“格力電器9月9日宣布回購(gòu)?fù)瓿桑塾?jì)成交金額為150億元,其中最高成交價(jià)為56.11元/股,最低成交價(jià)為40.21元/股”。除了事件類(lèi)型和觸發(fā)詞外,抽取結(jié)果還包括像時(shí)間,交易金額等事件元素。

在一個(gè)完善的金融事件體系中,要完整的定義一個(gè)事件類(lèi)型所涉及的元素,這樣在抽取中才能盡可能將一個(gè)文本中的事件的完整信息抽取出來(lái),否則一個(gè)不完整的事件抽取結(jié)果意味著在結(jié)構(gòu)化過(guò)程中流失了。

圖 10

事件抽取的挑戰(zhàn)主要來(lái)自于訓(xùn)練數(shù)據(jù)的標(biāo)注,有些事件要素的標(biāo)注會(huì)和領(lǐng)域知識(shí)緊密相關(guān),可能需要標(biāo)注人員有一定的專(zhuān)業(yè)知識(shí)。這種標(biāo)注成本高,難以擴(kuò)展到大量的數(shù)據(jù)和事件類(lèi)型上。

針對(duì)上述挑戰(zhàn),我們基于生成式抽取的方法,提出了一些改進(jìn)的技術(shù),在ACE05上達(dá)到SOTA的效果,并且顯著提升了模型的zero-shot和few-shot能力。

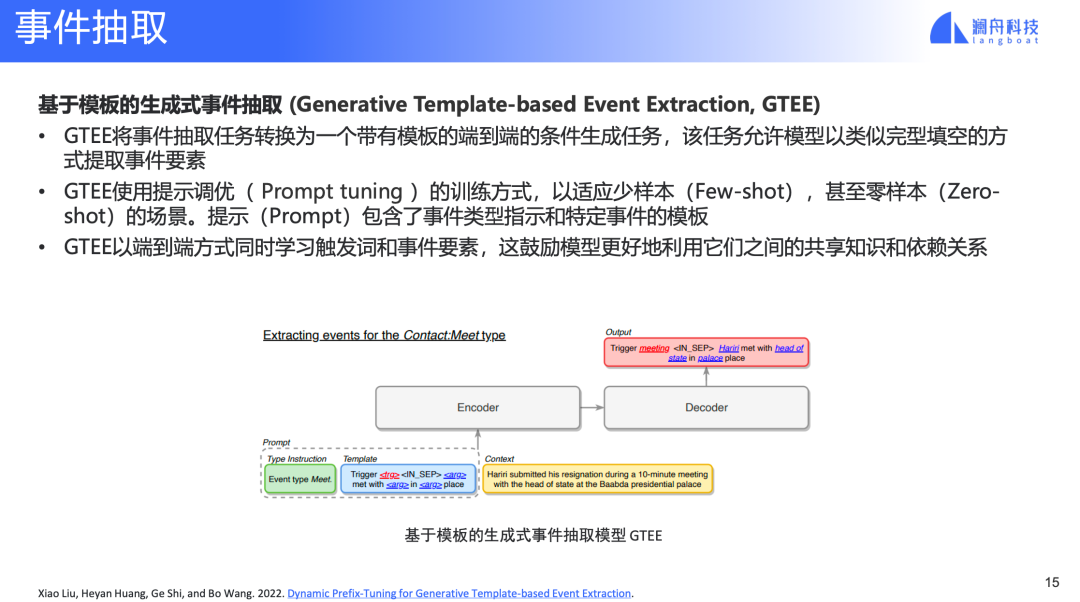

圖 11

基于模板的生成式事件抽取將事件抽取轉(zhuǎn)換為一個(gè)生成任務(wù),這種方法的一個(gè)好處就是可以將模板當(dāng)成是prompt,通過(guò)改寫(xiě)模板支持新的事件類(lèi)型,或者改變已有的事件類(lèi)型,比如增加事件元素。提示信息為GTEE提供了語(yǔ)義指導(dǎo),以便利用標(biāo)簽語(yǔ)義更好地捕獲事件要素,提示中編碼的事件描述使GTEE能夠使用附加的弱監(jiān)督信息。prompt和context輸入到encoder后,decoder段輸出填充之后的模板,根據(jù)模板得到事件的元素信息。GTEE做為這種方法的一個(gè)代表,證明了基于生成式的事件抽取方法也可以做到SOTA,超過(guò)傳統(tǒng)的基于序列標(biāo)注的方法。

圖 12

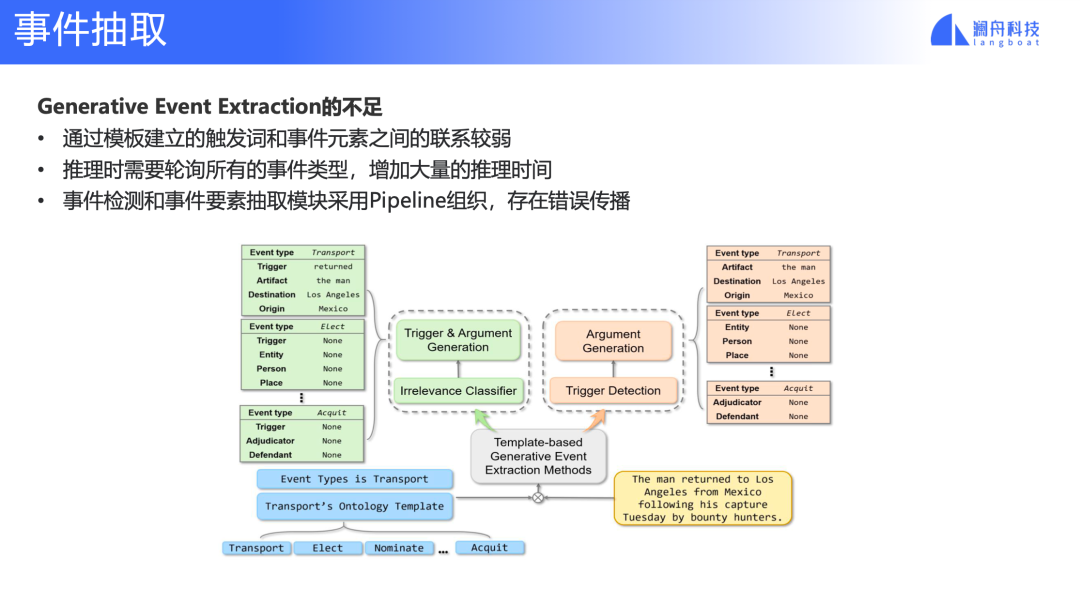

但是,現(xiàn)有的生成式事件抽取方法還存在幾個(gè)不足,第一,觸發(fā)詞和事件元素之間的聯(lián)系較弱,他們都定義在模板中,沒(méi)有顯示的對(duì)應(yīng)關(guān)系。第二,模型推理時(shí),針對(duì)一個(gè)輸入文本,每個(gè)事件類(lèi)型都要進(jìn)行一次推理,推理的計(jì)算量和事件類(lèi)型成正比。事件檢測(cè)和事件抽取采用了pipeline的方式組織,導(dǎo)致錯(cuò)誤傳播,不能聯(lián)合學(xué)習(xí)優(yōu)化。

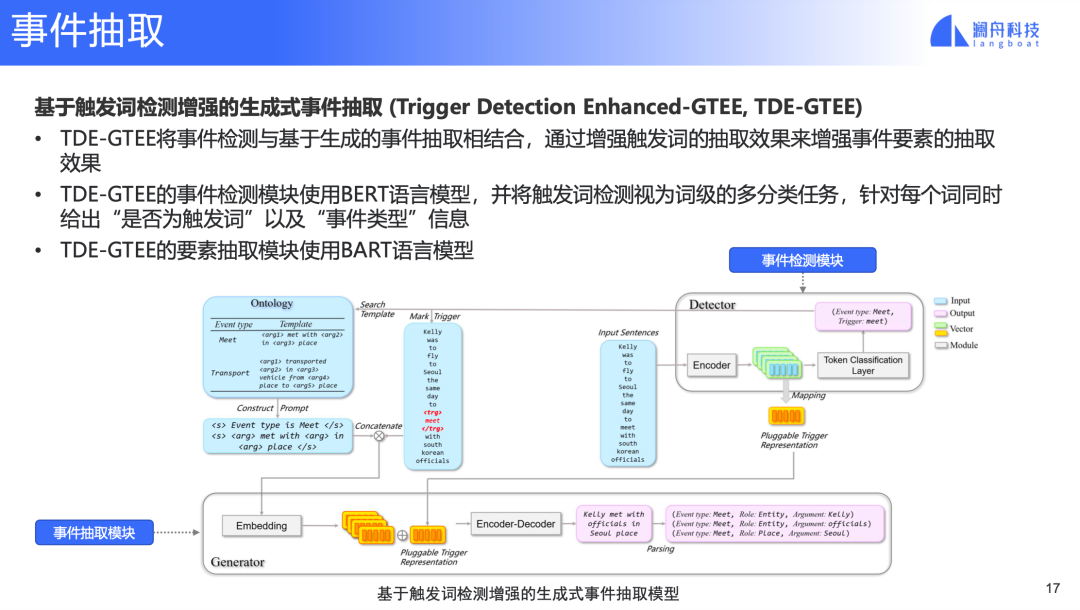

為解決以上不足,我們提出基于觸發(fā)詞檢測(cè)增強(qiáng)的生成式事件抽取,如下圖所示:

圖 13

在TDE-GTEE中,事件檢測(cè)模塊提供觸發(fā)詞和事件類(lèi)型信息,在輸入中標(biāo)注觸發(fā)詞得到新的輸入,并且根據(jù)事件類(lèi)型信息選擇相應(yīng)的模板,新的輸入和事件模板輸入concat后的表示結(jié)合事件檢測(cè)模型中觸發(fā)詞的表示輸入bart模型,最終得到填充后的模板,進(jìn)而得到事件元素信息。

這里事件觸發(fā)詞在輸入中的標(biāo)注,以及觸發(fā)詞表示和prompt表示融合,都是在加強(qiáng)觸發(fā)詞與輸入和模板中信息的交互,同時(shí),檢測(cè)模型過(guò)濾了無(wú)關(guān)的事件類(lèi)型模板,推理效率更高。最后,檢測(cè)模型和事件抽取模型融入一個(gè)端到端的模型,并聯(lián)合訓(xùn)練。

圖 14

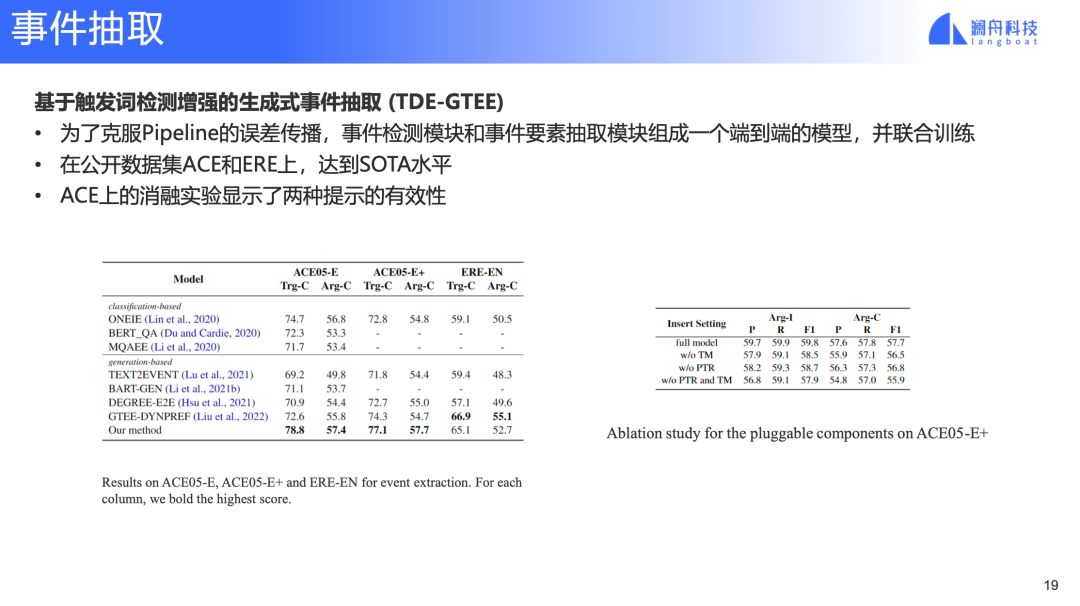

基于以上改進(jìn),TDE-GTEE在ACE05和ERE上都達(dá)到了SOTA水平,如圖 14 表格所示。

圖 15

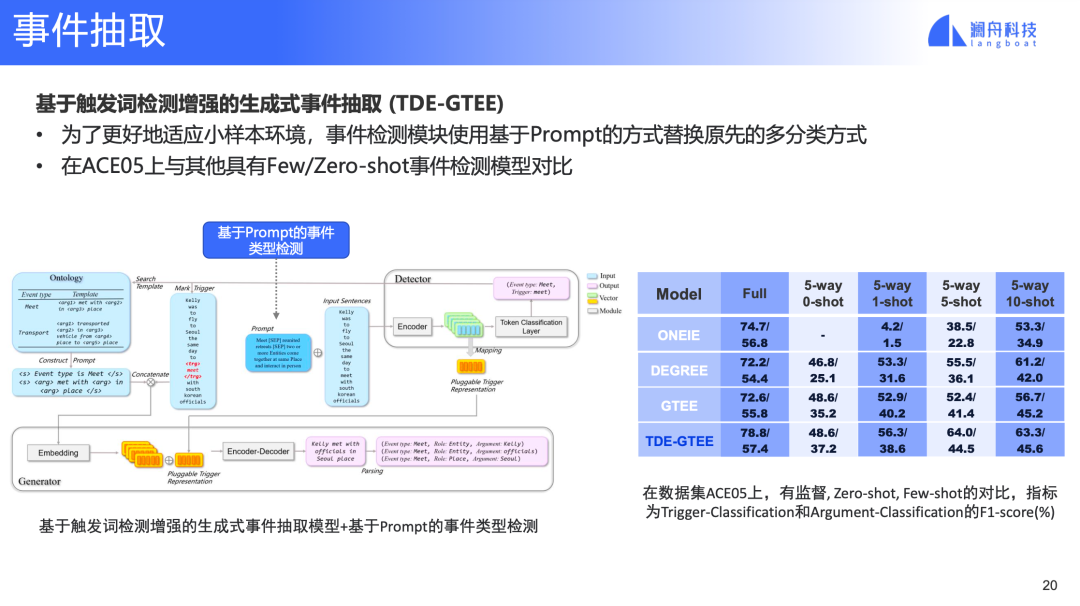

為支持zero-shot 和few-shot,在TDE-GTEE的基礎(chǔ)上,我們將前面介紹過(guò)的基于prompt的事件檢測(cè)模塊集成進(jìn)來(lái)。同樣在ACE05上對(duì)比GTEE等模型,TDE-GTEE的 zero-shot和few-shot 事件抽取效果也達(dá)到了SOTA水平。

總結(jié)

事件分析在金融領(lǐng)域廣泛,應(yīng)用場(chǎng)景眾多,一個(gè)完善的覆蓋金融事件體系和核心技術(shù)的金融事件分析框架,為金融領(lǐng)域的信息理解提供了強(qiáng)有力的支持。

審核編輯:劉清

-

SQL

+關(guān)注

關(guān)注

1文章

780瀏覽量

44776 -

編碼

+關(guān)注

關(guān)注

6文章

965瀏覽量

55436 -

PDF

+關(guān)注

關(guān)注

1文章

172瀏覽量

34285

原文標(biāo)題:基于預(yù)訓(xùn)練模型的金融事件分析及應(yīng)用

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

用PaddleNLP為GPT-2模型制作FineWeb二進(jìn)制預(yù)訓(xùn)練數(shù)據(jù)集

從Open Model Zoo下載的FastSeg大型公共預(yù)訓(xùn)練模型,無(wú)法導(dǎo)入名稱(chēng)是怎么回事?

用PaddleNLP在4060單卡上實(shí)踐大模型預(yù)訓(xùn)練技術(shù)

【「基于大模型的RAG應(yīng)用開(kāi)發(fā)與優(yōu)化」閱讀體驗(yàn)】+大模型微調(diào)技術(shù)解讀

KerasHub統(tǒng)一、全面的預(yù)訓(xùn)練模型庫(kù)

什么是大模型、大模型是怎么訓(xùn)練出來(lái)的及大模型作用

AI大模型的訓(xùn)練數(shù)據(jù)來(lái)源分析

直播預(yù)約 |數(shù)據(jù)智能系列講座第4期:預(yù)訓(xùn)練的基礎(chǔ)模型下的持續(xù)學(xué)習(xí)

預(yù)訓(xùn)練模型技術(shù)在金融事件分析中有何作用

預(yù)訓(xùn)練模型技術(shù)在金融事件分析中有何作用

評(píng)論