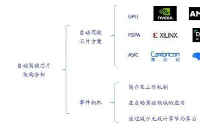

在深度學習的概念中,通常可以簡化為兩大工作流,一是訓練,二是推理。兩者完美融合才是一個現代化的完整深度學習網絡,缺一不可。訓練用于調整神經網絡模型的參數,從而在給定的數據上實現良好的表現;推理則用于執行訓練過的神經網絡模型,以在新數據上獲得輸出。

為了讓一個模型用于特定的用例,比如圖像識別、語音識別等,開發者必須要先訓練這個模型。一旦模型訓練完成后,就可以投入使用(用于推理)。這兩大工作流有著類似的特點,但對硬件資源的要求卻存在一定的差距。

以訓練來說,硬件需要的是大帶寬大容量的內存,所以芯片之間的互聯相當重要,當然了這些需求會極大地增加BOM和功耗。而推理則常用于自然語言處理、推薦系統和語音識別這樣的實時應用中,因此必須做到低延遲、高吞吐量,再者由于更加貼近應用端,所以低功耗和低成本也是這類AI推理硬件的首選特性。

而這幾年間,不少半導體公司、云服務廠商和初創AI芯片公司都在AI推理上頻頻布局,甚至收購了不少企業來放大優勢或補全短板,尤其是“御三家”英偉達、英特爾和AMD。筆者這里特地選擇了三家的代表性產品,以及他們走的不同技術路線。

市場與生態的寵兒——GPU王牌部隊

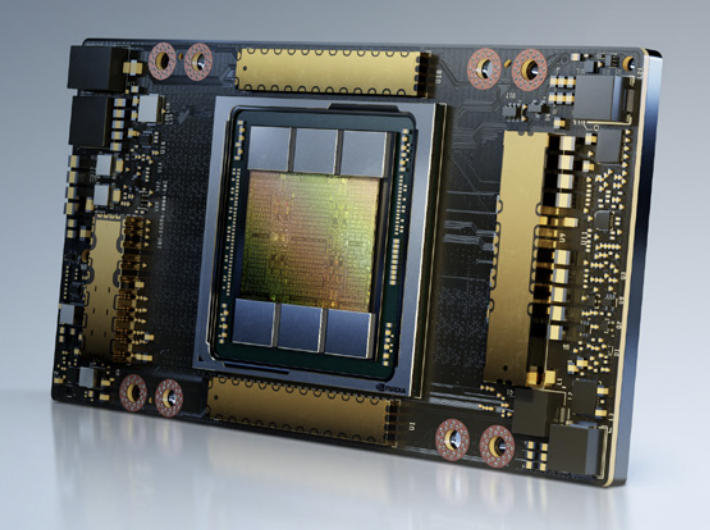

自英偉達從2010年推出M2050專業GPU,并大肆推行GPGPU在AI推理上的應用后,英偉達DGX產品線在AI推理算力上的占比就在一路走高。2020年阿里云、AWS和騰訊云等公有云平臺中,英偉達GPU AI推理算力超過了100 exaflops,也首次奪下了云端CPU統治多年的推理算力寶座,這其中的旗艦就是A100 GPU。

A100 SXM / 英偉達

我們以旗艦型號A100 80GB SXM為例,318 TFLOPS的TF32算力,1248 TOPS的INT8算力,80GB的GPU內存帶寬達到了2039GB/s。不僅支持NVLink600GB/s的互聯,也支持64GB/s的PCIe4.0互聯。A100還可以被分為7個獨立的GPU實例,無論是端到端AI還是數據中心的HPC平臺,都適合該GPU大顯身手。

但A100的缺點也相當明顯,第一就是功耗,高達400W的功耗讓這張卡成了很多AI推理加速器競相對比能效比的對象。其次就是價格,高達一萬美元以上的單價讓不少人望而卻步,至少個人開發者使用GPU或基于該GPU的云服務器的話,不免會肉疼好一陣了。

靈活的代表——FPGA抵抗軍

對于AMD來說,過去主要是與英偉達、英特爾在一些通用計算領域進行交鋒,而在AI訓練和推理上,AMD其實并沒有推出太多針對這類應用的方案,直到對Xilinx的收購。不可置否的是,AMD在數據中心和HPC已經嶄露頭角,甚至開始拔尖,但AI推理可以說一直是AMD的弱勢所在。

其實收購的部分原因,也要歸功于Xilinx在AI市場上得天獨厚的優勢,而這種優勢在兩家聯手之下更加明顯,這一點早在過去的合作中就可以看出來。2018年的Xilinx開發者論壇上,AMD的EPYC CPU和Xilinx的AlveoU250在GoogLeNet CNN框架上實現了3萬張圖片每秒的世界記錄級吞吐量。目前不少公有云廠商也在用Xilinx的FPGA方案,比如阿里云就有基于XilinxVU9P的方案。

VCK5000 / Xilinx

Xilinx最近也推出了全新的VCK5000AI加速器,該卡基于Xilinx7nm的VersalACAP架構,專為高吞吐量的AI推理打造。從紙面參數上看,這張卡好像性能不算強大,在ResNet-50的吞吐量上只能算優于英偉達的T4顯卡,但VCK5000還準備了一些奇招。

電路中有個叫做暗硅(DarkSilicon)的概念,指的就是在功耗限制下,處理器電路上常常出現“一方有難,多方看戲”的情況,所以實際的效能根本達不到紙面參數。而Xilinx稱VCK5000將實際效率推至90%,相較英偉達GPU普遍低于50%的效率可謂秒殺了,甚至高過A100。成本上,VCK5000的單價也做到了2745美元,從性價比和TCO來說,FPGA方案可以說是真香了。

初創公司首選——ASIC異軍突起

作為英特爾在2019年收購的一家以色列人工智能公司,Habana倒是很少出現在人們的視線中,遠不如同被英特爾收購的以色列自動駕駛芯片公司Mobileye或是晶圓代工廠TowerSemiconductor那般高調,但他們給英特爾帶來的AI方案還是有點東西的。

HL-100 / Habana

Habana擁有兩大產品線,一是主打訓練的Gaudi系列,二是主打推理的Goya系列。雖然兩者采用了不同的芯片設計,但仍基于相同的基本架構(TPC),只不過是針對兩種工作負載做了優化而已。同樣以ResNet50的吞吐量作為比較,在Batch大小為10時,基于Goya的HL-100加速卡可以做到15488張圖片每秒的吞吐量,更吃驚的是其延遲可以做到0.8ms。對于延遲敏感型應用來說,Goya很可能就是最佳的選擇。

不過HL-100的TPC還只是基于臺積電的16nm工藝而已,而基于更先進的工藝的TPC和HL-200系列遲遲沒有消息公布。不知是不是Habana打算在新產品上直接用上英特爾的工藝。

孰優孰劣?還是取決于生態和市場選擇

要想對比這三家AI推理加速器的性能著實有些困難,且不說三者在規模和功耗上的不同,所用系統、軟件、模型、數據集和測試環境也都是各不一樣。那么對于AI開發者來說,應該如何選擇呢?我們不妨從市場和生態的角度來看。

首先是市場的主流選擇,無疑目前市面應用占比最多的還是英偉達旗下的加速器,這在數據中心和超算等場景中都能看出來,無論是訓練還是推理,云服務廠商推出最多的旗艦實例基本都是基于英偉達的A100、A30等GPU,在其TensorRT推理框架的大力推動下,英偉達占據了絕對的主導位置。然而作為通用方案,英偉達的A100在總體性能上雖然不錯,但泛用性還是無法覆蓋到一些特定的應用。比如主打超低延遲或超高吞吐量的場景,可能還是不如FPGA或推理專用ASIC給到的吸引力高,更不用說這些方案在成本上的優勢了。

反觀Xilinx的VCK5000,單純比算力的話,FPGA與GPU、ASIC相比優勢不大,倒是FPGA的可編程靈活性為開發帶來了不少便利,可隨時更新和優化硬件加速而無需重新設計硬件。但不少AI開發者可能看到Xilinx這個大名就望而生畏,紛紛表示自己一個深度學習“煉丹師”,可不想學Verilog之類的RTL編程設計。這也是為何英特爾和Xilinx等FPGA廠商近年來開始在軟件上發力的原因,像Xilinx Vitis這樣的統一軟件,可以說給了一個面向全平臺開發者的方案,直接支持到Pytorch和TensorFlow這些主流的框架和模型。

至于Habana的Goya這種產品形式,其實是目前不少初創公司走的路線。與以上GPU和FPGA方案相比,他們在軟件開發上要花費更多的心力,所以不少初創企業的AI加速器支持的框架和模型都不是太多,支持的程度也尚未完善。至于市場反響來看,Goya也不比Habana的Gaudi訓練加速器,后者已經有了基于該硬件的AWS實例,而Goya目前已知的應用還是超算。未來Goya面向的,可能還是比較“專”的場景。

-

FPGA

+關注

關注

1643文章

21944瀏覽量

613385 -

gpu

+關注

關注

28文章

4904瀏覽量

130575 -

AI

+關注

關注

87文章

33998瀏覽量

274924

發布評論請先 登錄

FPGA+AI王炸組合如何重塑未來世界:看看DeepSeek東方神秘力量如何預測......

當我問DeepSeek AI爆發時代的FPGA是否重要?答案是......

FPGA+GPU+CPU國產化人工智能平臺

GPU、FPGA和ASIC鏖戰AI推理

GPU、FPGA和ASIC鏖戰AI推理

評論