2020年,GPT-3可謂火出了圈。

不僅講故事的本職工作做得風生水起,還跨界玩起了網頁設計、運維、下象棋……

不過,盡管表現驚艷,GPT-3背后到底是實實在在的1750億參數,想要在實際應用場景中落地,難度著實不小。

現在,針對這個問題,普林斯頓的陳丹琦、高天宇師徒和MIT博士生Adam Fisch在最新論文中提出,使用較小的語言模型,并用少量樣本來微調語言模型的權重。

并且,實驗證明,這一名為LM-BFF(better few-shot fine-tuning fo language models)的方法相比于普通微調方法,性能最多可以提升30%。

詳情如何,一起往下看。

方法原理

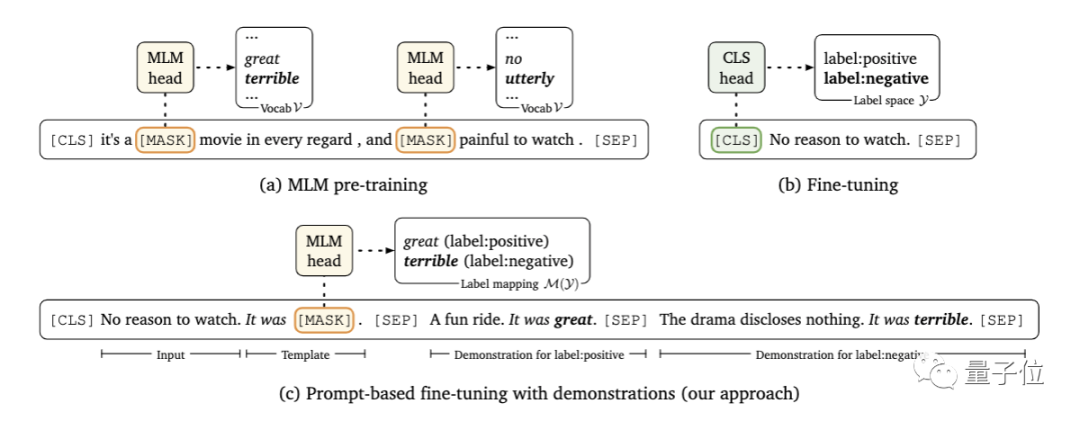

首先,研究人員采用了基于提示的預測路線。

所謂基于提示的預測,是將下游任務視為一個有遮蓋(mask)的語言建模問題,模型會直接為給定的提示生成文本響應。

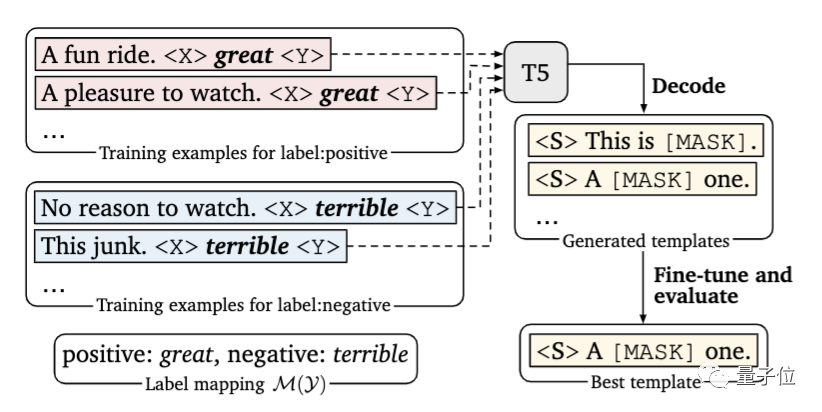

這里要解決的問題,是尋找正確的提示。這既需要該領域的專業知識,也需要對語言模型內部工作原理的理解。

在本文中,研究人員提出引入一個新的解碼目標來解決這個問題,即使用谷歌提出的T5模型,在指定的小樣本訓練數據中自動生成提示。

其次,研究人員在每個輸入中,以額外上下文的形式添加了示例。

問題的關鍵在于,要有限考慮信息量大的示例,一方面,因為可用示例的數量會受到模型最大輸入長度的限制;另一方面,不同類型的大量隨機示例混雜在一起,會產生很長的上下文,不利于模型學習。

為此,研究人員開發了一種動態的、有選擇性的精細策略:對于每個輸入,從每一類中隨機抽取一個樣本,以創建多樣化的最小演示集。

另外,研究人員還設計了一種新的抽樣策略,將輸入與相似的樣本配對,以此為模型提供更多有價值的比較。

實驗結果

那么,這樣的小樣本學習方法能實現怎樣的效果?

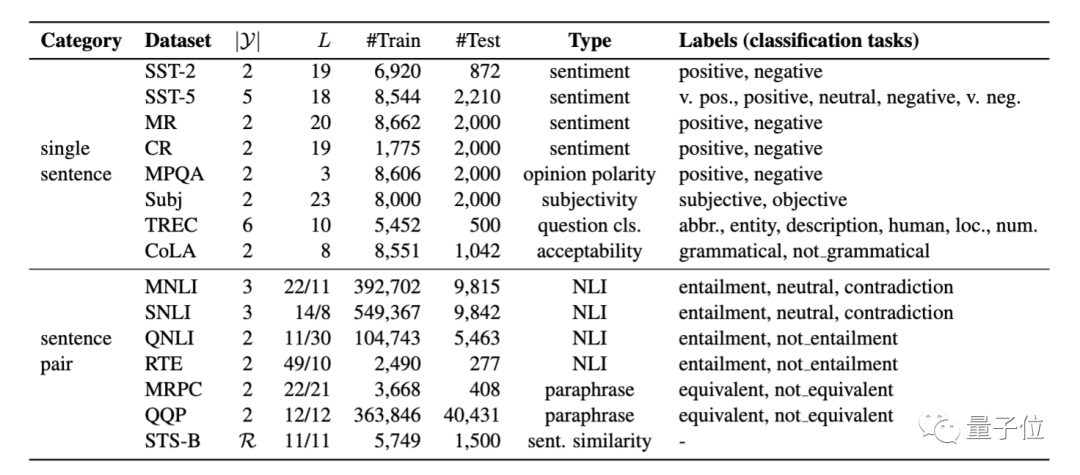

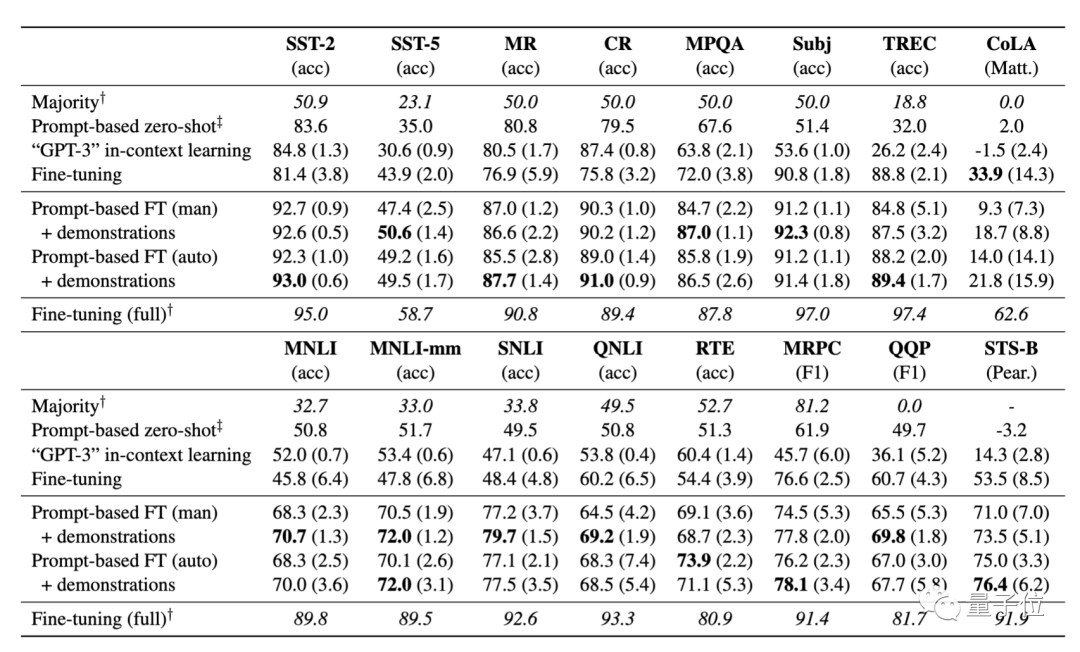

研究人員在8個單句、7個句子對NLP任務上,對其進行了系統性評估,這些任務涵蓋分類和回歸。

結果顯示:

基于提示的微調在很大程度上優于標準微調;

自動提示搜索能匹敵、甚至優于手動提示;

加入示例對于微調而言很有效,并提高了少樣本學習的性能。

在K=16(即每一類樣本數為16)的情況下,從上表結果可以看到,該方法在所有任務中,平均能實現11%的性能增益,顯著優于標準微調程序。在SNLI任務中,提升達到30%。

不過,該方法目前仍存在明顯的局限性,性能仍大大落后于采用大量樣本訓練獲得的微調結果。

關于作者

論文有兩位共同一作。

高天宇,清華大學本科生特等獎學金獲得者,本科期間即發表4篇頂會論文,師從THUNLP實驗室的劉知遠副教授。

今年夏天,他本科畢業后赴普林斯頓攻讀博士,師從本文的另一位作者陳丹琦。

此前,量子位曾經分享過他在寫論文、做實驗、與導師相處方面的經驗。

Adam Fisch,MIT電氣工程與計算機科學專業在讀博士,是CSAIL和NLP研究小組的成員,主要研究方向是應用于NLP的遷移學習和多任務學習。

他本科畢業于普林斯頓大學,2015-2017年期間曾任Facebook AI研究院研究工程師。

至于陳丹琦大神,想必大家已經很熟悉了。她本科畢業于清華姚班,后于斯坦福大學拿下博士學位,2019年秋成為普林斯頓計算機科學系助理教授。

最后,該論文代碼即將開源,如果還想了解更多論文細節,請戳文末論文鏈接詳讀~

傳送門

論文地址:

https://arxiv.org/abs/2012.15723v1

項目地址:

https://github.com/princeton-nlp/LM-BFF

責任編輯:xj

原文標題:【前沿】陳丹琦團隊最新論文:受GPT-3啟發,用小樣本學習給語言模型做微調,性能最高提升30%

文章出處:【微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

-

語言模型

+關注

關注

0文章

558瀏覽量

10667 -

GPT

+關注

關注

0文章

368瀏覽量

15930 -

自然語言

+關注

關注

1文章

291瀏覽量

13600

原文標題:【前沿】陳丹琦團隊最新論文:受GPT-3啟發,用小樣本學習給語言模型做微調,性能最高提升30%

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【「基于大模型的RAG應用開發與優化」閱讀體驗】+大模型微調技術解讀

大語言模型開發語言是什么

云端語言模型開發方法

【《大語言模型應用指南》閱讀體驗】+ 基礎篇

【《大語言模型應用指南》閱讀體驗】+ 俯瞰全書

大語言模型的預訓練

大模型為什么要微調?大模型微調的原理

如何加速大語言模型推理

深度學習中的模型權重

大語言模型(LLM)快速理解

LLM之外的性價比之選,小語言模型

如何使用較小的語言模型,并用少量樣本來微調語言模型的權重

如何使用較小的語言模型,并用少量樣本來微調語言模型的權重

評論