導讀

今天給大家介紹半監(jiān)督學習中的3個最基礎的概念:一致性正則化,熵最小化和偽標簽,并介紹了兩個經(jīng)典的半監(jiān)督學習方法。

沒看一的點這里哈:半監(jiān)督學習入門基礎(一)

半監(jiān)督學習 (SSL) 是一種非常有趣的方法,用來解決機器學習中缺少標簽數(shù)據(jù)的問題。SSL利用未標記的數(shù)據(jù)和標記的數(shù)據(jù)集來學習任務。SSL的目標是得到比單獨使用標記數(shù)據(jù)訓練的監(jiān)督學習模型更好的結果。這是關于半監(jiān)督學習的系列文章的第2部分,詳細介紹了一些基本的SSL技術。

一致性正則化,熵最小化,偽標簽

SSL的流行方法是在訓練期間往典型的監(jiān)督學習中添加一個新的損失項。通常使用三個概念來實現(xiàn)半監(jiān)督學習,即一致性正則化、熵最小化和偽標簽。在進一步討論之前,讓我們先理解這些概念。

一致性正則化強制數(shù)據(jù)點的實際擾動不應顯著改變預測器的輸出。簡單地說,模型應該為輸入及其實際擾動變量給出一致的輸出。我們人類對于小的干擾是相當魯棒的。例如,給圖像添加小的噪聲(例如改變一些像素值)對我們來說是察覺不到的。機器學習模型也應該對這種擾動具有魯棒性。這通常通過最小化對原始輸入的預測與對該輸入的擾動版本的預測之間的差異來實現(xiàn)。

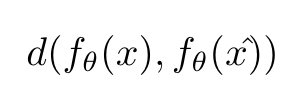

模型對輸入x及其擾動x^的一致性度量

d(.,.) 可以是均方誤差或KL散度或任何其他距離度量。

一致性正則化是利用未標記數(shù)據(jù)找到數(shù)據(jù)集所在的平滑流形的一種方法。這種方法的例子包括π模型、Temporal Ensembling,Mean Teacher,Virtual Adversarial Training等。

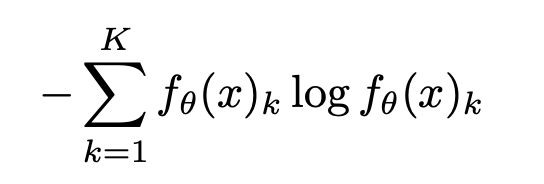

熵最小化鼓勵對未標記數(shù)據(jù)進行更有信心的預測,即預測應該具有低熵,而與ground truth無關(因為ground truth對于未標記數(shù)據(jù)是未知的)。讓我們從數(shù)學上理解下這個。

熵的計算

這里,K是類別的數(shù)量, 是模型對x預測是否屬于類別k的置信度。

是模型對x預測是否屬于類別k的置信度。

此外,輸入示例中所有類的置信度之和應該為1。這意味著,當某個類的預測值接近1,而其他所有類的預測值接近0時,熵將最小化。因此,這個目標鼓勵模型給出高可信度的預測。

理想情況下,熵的最小化將阻止決策邊界通過附近的數(shù)據(jù)點,否則它將被迫產生一個低可信的預測。請參閱下圖以更好地理解此概念。

由不同的半監(jiān)督學習方法生成的決策邊界

偽標簽是實現(xiàn)半監(jiān)督學習最簡單的方法。一個模型一開始在有標記的數(shù)據(jù)集上進行訓練,然后用來對沒有標記的數(shù)據(jù)進行預測。它從未標記的數(shù)據(jù)集中選擇那些具有高置信度(高于預定義的閾值)的樣本,并將其預測視為偽標簽。然后將這個偽標簽數(shù)據(jù)集添加到標記數(shù)據(jù)集,然后在擴展的標記數(shù)據(jù)集上再次訓練模型。這些步驟可以執(zhí)行多次。這和自訓練很相關。

在現(xiàn)實中視覺和語言上擾動的例子

視覺:

翻轉,旋轉,裁剪,鏡像等是圖像常用的擾動。

語言

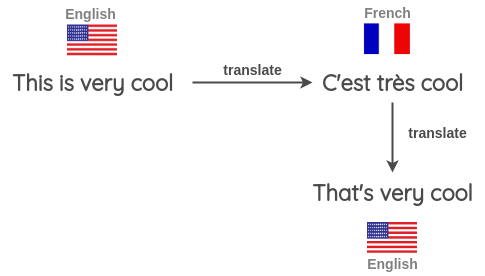

反向翻譯是語言中最常見的擾動方式。在這里,輸入被翻譯成不同的語言,然后再翻譯成相同的語言。這樣就獲得了具有相同語義屬性的新輸入。

NLP中的反向翻譯

半監(jiān)督學習方法

π model:

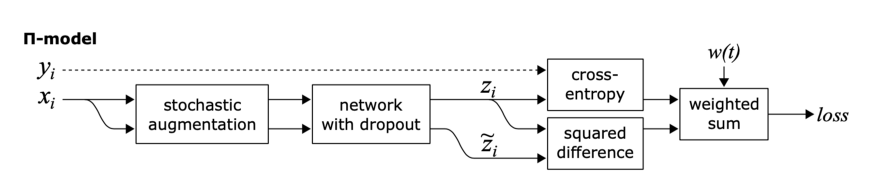

這里的目標是一致性正則化。

π模型鼓勵模型對兩個相同的輸入(即同一個輸入的兩個擾動變量)輸出之間的一致性。

π模型有幾個缺點,首先,訓練計算量大,因為每個epoch中單個輸入需要送到網(wǎng)絡中兩次。第二,訓練目標zi?是有噪聲的。

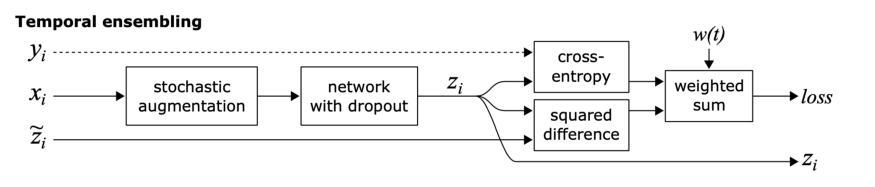

Temporal Ensembling:

這個方法的目標也是一致性正則化,但是實現(xiàn)方法有點不一樣。

眾所周知,與單一模型相比,模型集成通常能提供更好的預測。通過在訓練期間使用單個模型在不同訓練時期的輸出來形成集成預測,這一思想得到了擴展。

簡單來說,不是比較模型的相同輸入的兩個擾動的預測(如π模型),模型的預測與之前的epoch中模型對該輸入的預測的加權平均進行比較。

這種方法克服了π模型的兩個缺點。它在每個epoch中,單個輸入只進入一次,而且訓練目標zi? 的噪聲更小,因為會進行滑動平均。

這種方法的缺點是需要存儲數(shù)據(jù)集中所有的zi? 。

英文原文:https://medium.com/analytics-vidhya/a-primer-on-semi-supervised-learning-part-2-803f45edac2

責任編輯:xj

原文標題:半監(jiān)督學習入門基礎(二):最基礎的3個概念

文章出處:【微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

-

SSL

+關注

關注

0文章

129瀏覽量

26055 -

半監(jiān)督

+關注

關注

0文章

5瀏覽量

6382 -

機器學習

+關注

關注

66文章

8487瀏覽量

133986 -

深度學習

+關注

關注

73文章

5554瀏覽量

122430

原文標題:半監(jiān)督學習入門基礎(二):最基礎的3個概念

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

使用MATLAB進行無監(jiān)督學習

新品 | 半橋1200V CoolSiC? MOSFET EconoDUAL? 3模塊

NX-HB-GAN3R2-BSC半橋評估板

半橋LLC諧振電路的工作原理與模態(tài)分析

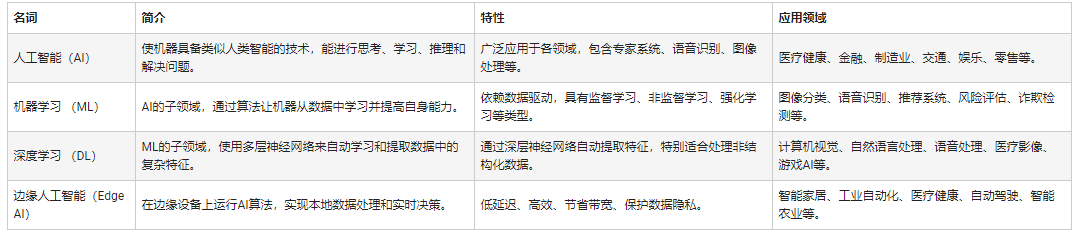

人工智能和機器學習以及Edge AI的概念與應用

自然語言處理與機器學習的關系 自然語言處理的基本概念及步驟

使用卷積神經(jīng)網(wǎng)絡進行圖像分類的步驟

時空引導下的時間序列自監(jiān)督學習框架

半監(jiān)督學習最基礎的3個概念

半監(jiān)督學習最基礎的3個概念

評論