什么是RNN?

RNN的思想是利?序列化的信息。在傳統(tǒng)的神經(jīng)?絡(luò)中,我們假設(shè)所有輸?和輸出彼此獨?。 但對于 許多任務(wù)??,這個假設(shè)有問題。例如你想預(yù)測句?中的下?個單詞,就需要知道它前?有哪些單詞。 RNN被稱為循環(huán),因為它對序列的每個元素執(zhí)?相同的任務(wù),并且基于先前的計算進?輸出。RNN的另 ?個優(yōu)點是它具有“記憶”,它可以收集到?前為?已經(jīng)計算的信息。 理論上,RNN可以在任意?的序列 中使?信息,但實際使?中僅僅往回記錄?步。這是典型的RNN的樣?:

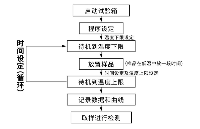

這個圖是循環(huán)是循環(huán)神經(jīng)?絡(luò)正向計算時按時間順序展開。這?展開意味著把完整的序列的?絡(luò)展示出 來。例如,如果我們關(guān)?的序列是5個單詞的句?,則?絡(luò)將展開為5層神經(jīng)?絡(luò),每個單詞?層。途中 的表達式解釋如下:

這?有?點需要注意:

RNN可以做什么?

RNN在許多NLP任務(wù)中取得了巨?成功。 在這個領(lǐng)域最常?的RNN類型是LSTM,它在捕獲?期依賴? ?要?普通的RNN好得多。但不要擔?,LSTM和RNN基本相同,它們只是采?不同的?式來計算隱藏 狀態(tài)。以下是RNP在NLP中的?些示例應(yīng)?。

語?模型和?成?本

給定?個單詞的序列,我們想要根據(jù)給出的前?個詞預(yù)測出下?個詞的概率。根據(jù)語?模型我們可以計 算句?的可能性,這是機器翻譯的重要輸?(因為概率?的句?通常是正確的)。能夠預(yù)測下?個單詞 的副作?是我們得到?個?成模型,?成模型是的我們可以通過從輸出概率中抽樣來?成新?本。根據(jù) 我們的訓(xùn)練數(shù)據(jù),我們可以?成各種各樣的東?。在語?模型中,我們的輸?通常是?系列單詞(編碼 成one-hot),我們的輸出是預(yù)測單詞的序列。在訓(xùn)練?絡(luò)時,我們設(shè)置 ,因為我們希望 時 刻的輸出是下?個時刻的輸?。

機器翻譯

機器翻譯類似于語?模型,因為我們的輸?是源語?中的?系列單詞(例如德語)。我們希望輸出?標 語?的?系列單詞(例如英語)。關(guān)鍵的區(qū)別是只有輸?完整之后才會進?輸出,因為我們翻譯的句? 的第?個單詞可能需要從完整的輸?序列中獲取信息。

機器翻譯的RNN

語?識別 給定來?聲波的聲學(xué)信號作為輸?序列,我們可以預(yù)測?系列語??段及其概率。 ?成圖像描述 RNN作為模型的?部分與卷積神經(jīng)?絡(luò)?起?成未標記圖像的描述。

這個組合模型?常令?驚訝的,結(jié) 果很不錯。 組合模型甚?可以把?成的單詞與圖像中找到的特征對應(yīng)起來。

LSTM?絡(luò)現(xiàn)在?常流?,我們這?簡單的討論?下。 LSTM與RNN基本架構(gòu)師相同的,只不過它們使 ?不同的函數(shù)來計算隱藏狀態(tài)。LSTM中的記憶單元稱為 ,可以把它們視為?框,將前?個狀態(tài) 和當前輸? 作為輸?。這些單元在內(nèi)部決定要保留什么。 然后它們組合了先前的狀態(tài),當前的 記憶和輸?。事實證明,這些單元在捕獲?期依賴???常有效。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4814瀏覽量

103564

發(fā)布評論請先 登錄

順絡(luò)貼片電容的漏電流問題如何解決?

順絡(luò)壓敏電阻的選用要點

技術(shù)干貨驛站 ▏深入理解C語言:嵌套循環(huán)與循環(huán)控制的底層原理

BP神經(jīng)網(wǎng)絡(luò)與卷積神經(jīng)網(wǎng)絡(luò)的比較

可靠性溫度循環(huán)試驗至少需要幾個循環(huán)?

循環(huán)神經(jīng)?絡(luò)是什么?可以做什么

循環(huán)神經(jīng)?絡(luò)是什么?可以做什么

評論