什么是神經(jīng)網(wǎng)絡(luò)

深度學(xué)習(xí)是指訓(xùn)練神經(jīng)網(wǎng)絡(luò)的過程,有的時(shí)候深度學(xué)習(xí)表示大規(guī)模的神經(jīng)網(wǎng)絡(luò)的訓(xùn)練,本節(jié)課程我們將從直觀的理解上講解什么是神經(jīng)網(wǎng)絡(luò)。

我們還是通過舉例子的方式來解釋一下,究竟什么才是神經(jīng)網(wǎng)絡(luò),從經(jīng)典的房價(jià)預(yù)測的例子開始講起。

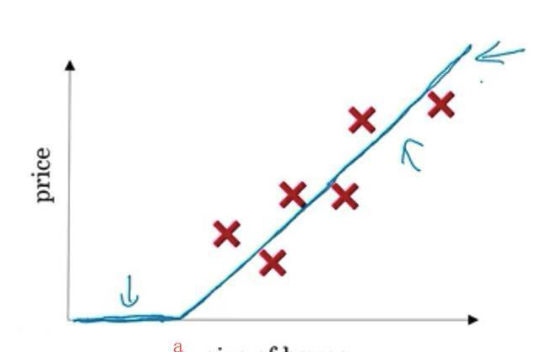

假如我們有一個(gè)有關(guān)于房價(jià)的數(shù)據(jù)集,這個(gè)數(shù)據(jù)集中有6個(gè)樣本,每個(gè)樣本的特征是房屋的面積,而樣本的標(biāo)簽就是房屋的價(jià)格,此時(shí)我們需要一個(gè)能夠擬合這個(gè)數(shù)據(jù)集的函數(shù),并且能夠通過這個(gè)函數(shù)根據(jù)房屋的面積來預(yù)測房價(jià)。

我們?cè)?a target="_blank">機(jī)器學(xué)習(xí)的專欄中已經(jīng)學(xué)習(xí)過了線性回歸,所以我們很清楚如何通過線性回歸來擬合出一條直線,于是我們可能得到這樣的一條直線來擬合我們的數(shù)據(jù)集。

但是此時(shí)的模型會(huì)有一些問題,我們將我們的直線繼續(xù)擴(kuò)展,我們會(huì)發(fā)現(xiàn),當(dāng)我們的房屋的面積小于a的時(shí)候,我們的房屋的價(jià)格就會(huì)為負(fù)數(shù),這是不現(xiàn)實(shí)的,因?yàn)槲覀冎婪课莸膬r(jià)格永遠(yuǎn)都不能為負(fù)數(shù),因此為了解決這個(gè)問題,我們需要把我們的直線彎曲一點(diǎn),讓它最終在零結(jié)束,那么我們最終的函數(shù)就如下所示:

我們可以看出我們的模型在大于a的時(shí)候,也就是直線部分會(huì)擬合的很好。以上是我們通過線性回歸的方式來擬合我們的房屋的數(shù)據(jù)。

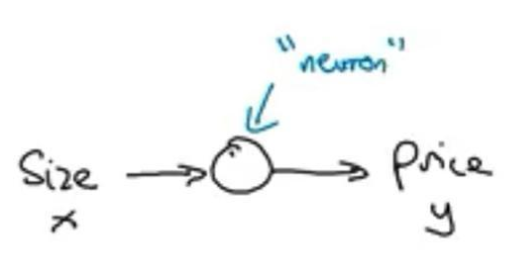

如果我們要通過神經(jīng)網(wǎng)絡(luò)的方式來實(shí)現(xiàn)上面的模型的話,這可能是最簡單的神經(jīng)網(wǎng)絡(luò)了。我們把房屋的面積作為神經(jīng)網(wǎng)絡(luò)的輸入(x),通過一個(gè)神經(jīng)元(小圓圈),最終輸出價(jià)格(y)。

我們通過上面的神經(jīng)網(wǎng)絡(luò)就能擬合出線性回歸所擬合出來的函數(shù),而這個(gè)函數(shù)我們未來在深度學(xué)習(xí)的過程中會(huì)經(jīng)常的見到,這個(gè)函數(shù)從趨近于0開始,然后變?yōu)橐粭l直線,這個(gè)函數(shù)被稱為RELU激活函數(shù),它的全稱就是Rectified Linear Unit(修正線性單元)。修正可以理解為max(0,x)。

所以我們當(dāng)前的神經(jīng)網(wǎng)絡(luò)可以做到和線性回歸一樣的功能,這個(gè)神經(jīng)網(wǎng)絡(luò)的工作原理就是輸入房屋面積,然后直接使用RELU激活函數(shù)來對(duì)房屋的面積進(jìn)行映射,然后我們就可以得出房屋的面積了,和線性回歸的效果是一樣的。

我們可以看出我們只通過一個(gè)神經(jīng)元就完成了房價(jià)預(yù)測的任務(wù),我們可以通過更多的神經(jīng)元來搭建一個(gè)更大的神經(jīng)網(wǎng)絡(luò)。我們?cè)賮砜匆粋€(gè)例子。

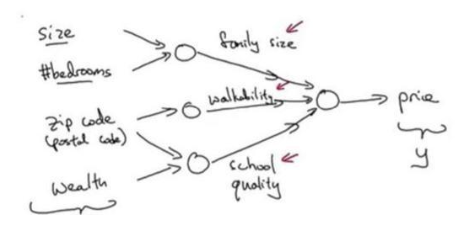

現(xiàn)在我們不僅使用單一的房屋的面積來預(yù)測房屋的價(jià)格,我們現(xiàn)在還有房屋的一些其它的特征,比如臥室的數(shù)量,郵政編碼(郵政編碼決定了你步行化的程度),地區(qū)富裕度。

{!-- PGC_COLUMN --}

這些特征能夠決定我們一個(gè)房子的價(jià)格,比如房子的大小和臥室的數(shù)量可以決定家庭的大小,郵政編碼可以決定步行化的程度,郵政編碼和地區(qū)富裕度還可以決定學(xué)校的質(zhì)量,而又可以根據(jù)家庭的大小,步行化的程度,以及學(xué)校的質(zhì)量可以決定最終的房屋的價(jià)格,所以我們可以根據(jù)這個(gè)邏輯建立如下所示的神經(jīng)網(wǎng)絡(luò)。

該圖中的每一個(gè)神經(jīng)元都可以是一個(gè)Relu,也就是修正線性單元,或者其它非線性的函數(shù)。

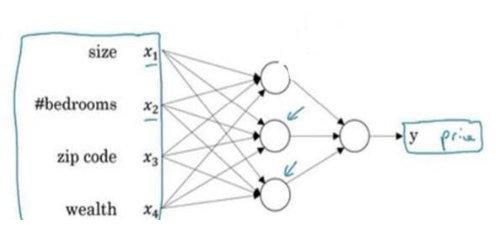

雖然我們已經(jīng)描述出來了這樣的一個(gè)神經(jīng)網(wǎng)絡(luò),但是看起來家庭的大小,步行化的程度,以及學(xué)校的質(zhì)量可能也需要我們得到,其實(shí)不用我們得到,我們只用像神經(jīng)網(wǎng)絡(luò)中輸入房屋的大小,臥室的數(shù)量,郵政編碼,富裕度這四個(gè)特征x,就能得到價(jià)格y,這正是神經(jīng)網(wǎng)絡(luò)神奇的地方,因?yàn)樯窠?jīng)網(wǎng)絡(luò)自己可以計(jì)算你訓(xùn)練集中樣本的數(shù)目以及所有的中間過程。這樣的話,我們就可以建立如下所示的神經(jīng)網(wǎng)絡(luò)了:

所以我們要做的就是將房屋大小,臥室數(shù)量,郵政編碼,富裕度這四個(gè)特征(x1、x2、x3、x4)輸入到神經(jīng)網(wǎng)絡(luò)中,輸入之后,神經(jīng)網(wǎng)絡(luò)就會(huì)預(yù)測出對(duì)應(yīng)的價(jià)格。

同時(shí)我們也要注意隱藏層的單元,我們可以看到隱藏層的單元都是從輸入的四個(gè)特征獲得自身的輸入,比如說隱藏層的第一個(gè)節(jié)點(diǎn)表示家庭人口,而家庭人口僅僅取決于特征x1和特征x2,神經(jīng)網(wǎng)絡(luò)的厲害之處在于,雖然這個(gè)隱藏層的結(jié)點(diǎn)也在和特征x3和特征x4相連,但是神經(jīng)網(wǎng)絡(luò)總是能夠通過權(quán)重參數(shù)的作用使得x3和x4對(duì)第一個(gè)隱藏層結(jié)點(diǎn)沒有作用,所以我們的特征x3和特征x4依然可以和這個(gè)隱藏層的結(jié)點(diǎn)相連(雖然x3和x4并不會(huì)對(duì)第一個(gè)隱藏層有什么意義)。

這樣的好處就是我們沒有必要去考慮很細(xì)節(jié)的東西,比如考慮第一個(gè)隱藏層和x1和x2有關(guān),從而連接x1和x2,而與x3和x4無關(guān),從而不連接x3和x4,如果我們考慮到如此細(xì)節(jié)的東西,那么我們的神經(jīng)網(wǎng)絡(luò)的搭建會(huì)異常的麻煩,當(dāng)我們喂給神經(jīng)網(wǎng)絡(luò)足夠多的數(shù)據(jù)的時(shí)候,神經(jīng)網(wǎng)絡(luò)總是能夠自動(dòng)學(xué)習(xí)到相應(yīng)的參數(shù),使得雖然與x3和x4相連,但是x3和x4卻不會(huì)對(duì)隱藏層第一個(gè)單元造成任何影響。

這里我們可以把神經(jīng)網(wǎng)絡(luò)的隱藏層看成是特征的升級(jí),比如一開始我們輸入的是房屋大小,臥室數(shù)量,郵政編碼,富裕度,經(jīng)過隱藏層之后,我們的特征變?yōu)榱思彝サ拇笮。叫谢某潭龋约皩W(xué)校的質(zhì)量(有可能)然后輸入到最后輸出層,相比來說家庭的大小,步行化的程度,以及學(xué)校的質(zhì)量更能決定房價(jià)y,所以我們可以簡單的看成神經(jīng)網(wǎng)絡(luò)的隱藏層就是對(duì)我們特征的升級(jí)。

至此我們就知道了什么是神經(jīng)網(wǎng)絡(luò),希望能夠通過本節(jié)課程能夠了解到神經(jīng)網(wǎng)絡(luò)。神經(jīng)網(wǎng)絡(luò)非常擅長從x到y(tǒng)的精準(zhǔn)映射函數(shù)。它非常的強(qiáng)大,只要你輸入x,我們就可以將映射成y,就像我們上面的預(yù)測房價(jià)的例子一樣。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4814瀏覽量

103568 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1224瀏覽量

25444

發(fā)布評(píng)論請(qǐng)先 登錄

BP神經(jīng)網(wǎng)絡(luò)與卷積神經(jīng)網(wǎng)絡(luò)的比較

如何優(yōu)化BP神經(jīng)網(wǎng)絡(luò)的學(xué)習(xí)率

BP神經(jīng)網(wǎng)絡(luò)的優(yōu)缺點(diǎn)分析

什么是BP神經(jīng)網(wǎng)絡(luò)的反向傳播算法

BP神經(jīng)網(wǎng)絡(luò)與深度學(xué)習(xí)的關(guān)系

BP神經(jīng)網(wǎng)絡(luò)的基本原理

人工神經(jīng)網(wǎng)絡(luò)的原理和多種神經(jīng)網(wǎng)絡(luò)架構(gòu)方法

卷積神經(jīng)網(wǎng)絡(luò)與傳統(tǒng)神經(jīng)網(wǎng)絡(luò)的比較

卷積神經(jīng)網(wǎng)絡(luò)的基本原理與算法

RNN模型與傳統(tǒng)神經(jīng)網(wǎng)絡(luò)的區(qū)別

LSTM神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)與工作機(jī)制

LSTM神經(jīng)網(wǎng)絡(luò)的基本原理 如何實(shí)現(xiàn)LSTM神經(jīng)網(wǎng)絡(luò)

Moku人工神經(jīng)網(wǎng)絡(luò)101

從直觀的理解上講解什么是神經(jīng)網(wǎng)絡(luò)

從直觀的理解上講解什么是神經(jīng)網(wǎng)絡(luò)

評(píng)論