最近The M Tank發(fā)布了一份對計算機視覺領(lǐng)域最近一年進展的報告《A Year in Computer Vision》,詳述了四大部分的內(nèi)容,包括分類/定位,目標(biāo)檢測,目標(biāo)追蹤等。不管對于初學(xué)者還是緊追前沿的研究者,這些都是不可多得的有用資料。

綜述:計算機視覺最重要的進展

計算機視覺通常是指賦予機器視覺的能力,或賦予機器能夠直觀地分析它們的環(huán)境和內(nèi)在的刺激。這個過程通常包括對一個圖像、很多圖像或視頻的評估。英國機器視覺協(xié)會(BMVA)將計算機視覺定義為“自動提取、分析和理解來自單個圖像或一系列圖像的有用信息的過程”。

這個定義中的“理解”這個詞說明了計算機視覺的重要性和復(fù)雜性。對我們的環(huán)境的真正理解不是僅僅通過視覺表現(xiàn)來實現(xiàn)的。相反,視覺信號通過視覺神經(jīng)傳遞給主視覺皮層,并由大腦來解釋。從這些感官信息中得出的解釋包含了我們的自然編程和主觀體驗的總體,即進化是如何讓我們生存下來,以及我們在生活中對世界的理解。

從這個角度看,視覺僅僅與圖像的傳輸有關(guān);雖然計算機認為圖像與思想或認知更相似,涉及多個大腦區(qū)域的協(xié)作。因此,許多人認為由于計算機視覺的跨領(lǐng)域性質(zhì),對視覺環(huán)境及其背景的真正理解能為未來的強人工智能的迭代開拓道路。

然而,我們?nèi)匀惶幱谶@個迷人的領(lǐng)域的萌芽階段。這份報告的目的是為了讓我們對近年計算機視覺領(lǐng)域一些最重要的進展。盡管我們盡可能寫得簡明,但由于領(lǐng)域的特殊性,可能有些部分讀起來比較晦澀。我們?yōu)槊總€主題提供了基本的定義,但這些定義通常只是對關(guān)鍵概念的基本解釋。為了將關(guān)注的重點放在2016年的新工作,限于篇幅,這份報告會遺漏一些內(nèi)容。

其中明顯省略的一個內(nèi)容是卷積神經(jīng)網(wǎng)絡(luò)(以下簡稱CNN或ConvNet)的功能,因為它在計算機視覺領(lǐng)域無處不在。2012年出現(xiàn)的 AlexNet(一個在ImageNet競賽獲得冠軍的CNN架構(gòu))的成功帶來了計算機視覺研究的轉(zhuǎn)折點,許多研究人員開始采用基于神經(jīng)網(wǎng)絡(luò)的方法,開啟了計算機視覺的新時代。

4年過去了,CNN的各種變體仍然是視覺任務(wù)中新的神經(jīng)網(wǎng)絡(luò)架構(gòu)的主要部分,研究人員像搭樂高積木一樣創(chuàng)造它們,這是對開源信息和深度學(xué)習(xí)能力的有力證明。不過,解釋CNN的事情最好留給在這方面有更深入的專業(yè)知識的人。

對于那些希望在繼續(xù)進行之前快速了解基礎(chǔ)知識的讀者,我們推薦下面的參考資料的前兩個。對于那些希望進一步了解的人,以下的資料都值得一看:

深度神經(jīng)網(wǎng)絡(luò)如何看待你的自拍?by Andrej Karpathy 這篇文章能很好地幫助你了解產(chǎn)品和應(yīng)用背后的CNN技術(shù)。

Quora:什么是卷積神經(jīng)網(wǎng)絡(luò)。這個quora問題下的回答有很多很好的參考鏈接和解釋,適合初學(xué)者。

CS231n:視覺識別的卷積神經(jīng)網(wǎng)絡(luò)。這是斯坦福大學(xué)的一門深度的課程。

《深度學(xué)習(xí)》(Goodfellow, Bengio & Courville, 2016)第九章對CNN特征和功能提供了詳細的解釋。

對于那些希望更多地了解關(guān)于神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)的讀者,我們推薦:

神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)(Nielsen,2017),這是一本免費的電子版教科書,它為讀者提供了對于神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)的復(fù)雜性的非常直觀的理解。

我們希望讀者能從這份報告的信息匯總中獲益,無論以往的經(jīng)驗如何,都可以進一步增加知識。

本報告包括以下部分(限于篇幅,文章省略了參考文獻標(biāo)識,請至原文查看):

第一部分:分類/定位,目標(biāo)檢測,目標(biāo)追蹤

第二部分:分割,超分辨率,自動上色,風(fēng)格遷移,動作識別

第三部分:3D世界理解

第四部分:卷積網(wǎng)絡(luò)架構(gòu),數(shù)據(jù)集,新興應(yīng)用

第一部分:分類/定位,目標(biāo)檢測,目標(biāo)追蹤

分類/定位

涉及到圖像時,“分類”任務(wù)通常是指給一個圖像分配一個標(biāo)簽,例如“貓”。這種情況下,“定位”(locolisation)指的是找到某個對象(object)在圖像中的位置,通常輸出為對象周圍的某種形式的邊界框。當(dāng)前在ImageNet競賽的圖像分類/定位技術(shù)準確性超過一個經(jīng)訓(xùn)練的人類。

圖:計算機視覺任務(wù)

Source: Fei-Fei Li, Andrej Karpathy & Justin Johnson (2016) cs231n, Lecture 8 - Slide 8, Spatial Localization and Detection (01/02/2016). Available:http://cs231n.stanford.edu/slides/2016/winter1516_...

然而,由于更大的數(shù)據(jù)集(增加了11個類別)的引入,這很可能為近期的進展提供新的度量標(biāo)準。在這一點上,Keras的作者Fran?ois Chollet已經(jīng)在有超過3.5億的多標(biāo)簽圖像,包含17000個類的谷歌內(nèi)部數(shù)據(jù)集應(yīng)用了新的技術(shù),包括流行的Xception架構(gòu)。

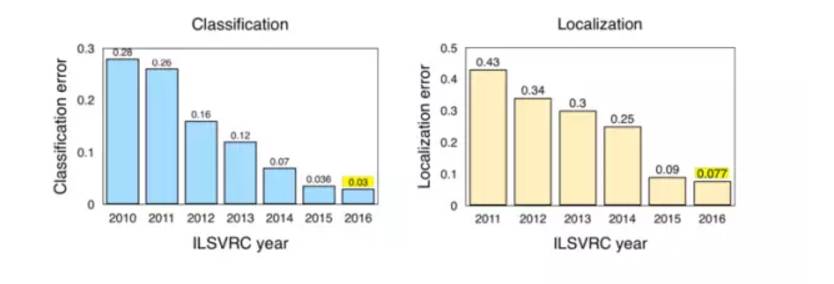

圖:ILSVRC(2010-2016)圖像分類/定位結(jié)果

Source: Jia Deng (2016). ILSVRC2016 object localisation: introduction, results. Slide 2.

2016年在ImageNet LSVRC 的一些主要進步:

場景分類(Scene Classification)是指用“溫室”、“體育館”、“大教堂”等特定場景來給圖像貼上標(biāo)簽的任務(wù)。去年,ImageNet 進行了一個場景分類競賽,使用Places2數(shù)據(jù)集的一個子集:包含800萬張圖片,用365類場景訓(xùn)練。Hikvision 以 9% top-5 error贏了比賽,利用一個深 Inception-style 網(wǎng)絡(luò),以及一個不特別深的殘差網(wǎng)絡(luò)。

Trimps-Soushen以 2.99% 的top-5分類錯誤和7.71%的定位錯誤贏得了ImageNet分類任務(wù)。

Facebook的ResNeXt通過使用擴展原始ResNet架構(gòu)的新架構(gòu),以3.03%在top-5 分類錯誤中排名第二。

對象檢測(Object Dection)

對象檢測的過程即檢測圖像中的某個對象。ILSVRC 2016 對對象檢測的定義包括為單個對象輸出邊界框和標(biāo)簽。這不同于分類/定位任務(wù),分類和定位的應(yīng)用是多個對象,而不是一個對象。

圖:對象檢測(人臉是該情況需要檢測的唯一一個類別)

Source: Hu and Ramanan (2016, p. 1)

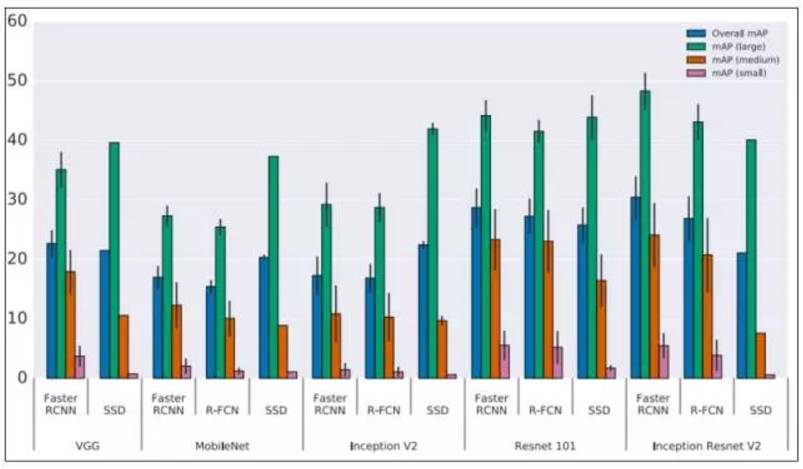

2016年對象檢測的主要趨勢是轉(zhuǎn)向更快、更高效的檢測系統(tǒng)。這在YOLO、SSD和R-FCN等方法中表現(xiàn)出來,目的是為了在整個圖像上共享計算。因此,這些與計算昂貴的Fast R-CNN和Faster R-CNN相區(qū)別。這通常被稱為“端到端訓(xùn)練/學(xué)習(xí)”。

其基本原理是避免將單獨的算法集中在各自的子問題上,因為這通常會增加訓(xùn)練時間,并降低網(wǎng)絡(luò)的準確性。也就是說,這種網(wǎng)絡(luò)的端到端適應(yīng)通常是在初始的子網(wǎng)絡(luò)解決方案之后進行的,因此,是一種回顧性優(yōu)化( retrospective optimisation)。當(dāng)然,F(xiàn)ast R-CNN和Faster R-CNN仍然是非常有效的,并且被廣泛應(yīng)用于物體檢測。

SSD:Single Shot MultiBox Detector這篇論文利用單個神經(jīng)網(wǎng)絡(luò)來封裝所有必要的計算,它實現(xiàn)了“75.1%的mAP,超越了更先進的R-CNN模型”(Liu et al., 2016)。我們在2016年看到的最令人印象深刻的系統(tǒng)之一是“YOLO9000:Better, Faster, Stronger”,其中介紹了YOLOv2和YOLO9000檢測系統(tǒng)。YOLOv2大大改善了初始的YOLO模型,并且能夠以非常高的FPS獲得更好的結(jié)果。除了完成速度之外,系統(tǒng)在特定對象檢測數(shù)據(jù)集上的性能優(yōu)于使用ResNet和SSD的Faster-RCNN。

FAIR的Feature Pyramid Networks for Object Detection

R-FCN:Object Detection via Region-based Fully Convolutional Networks

圖:不同架構(gòu)在對象檢測任務(wù)的準確率

Source: Huang et al. (2016, p. 9)

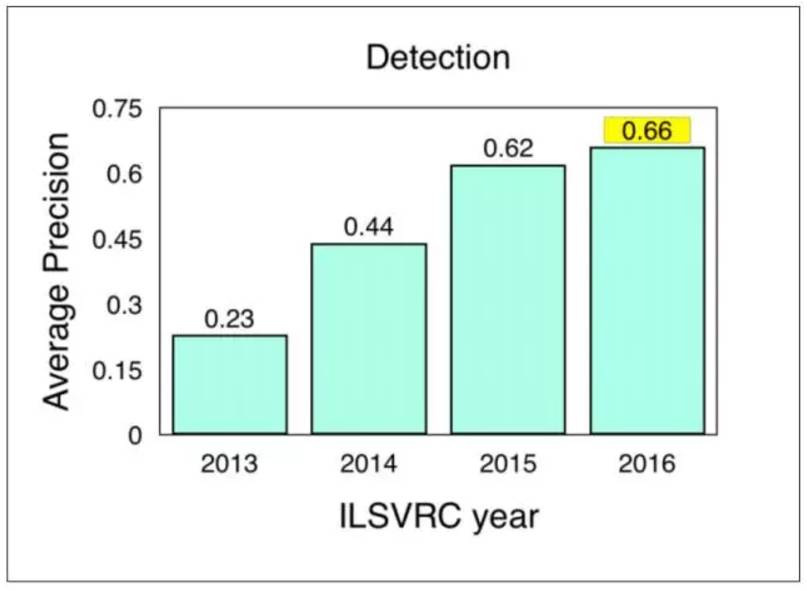

ILSVRC 和 COCO Challenge的結(jié)果

COCO(Common Objects in Context)是另一個流行的圖像數(shù)據(jù)集。不過,它比ImageNet小,也更具有策略性,在更廣泛的場景理解的背景下著重于對象識別。組織者每年都要針對對象檢測,分割和關(guān)鍵點組織競賽。 ILSVRC 和COCO 對象檢測挑戰(zhàn)的檢測是:

ImageNet LSVRC Object Detection from Images (DET):CUImage 66% meanAP. Won 109 out of 200 object categories.

ImageNet LSVRC Object Detection from video (VID):NUIST 80.8% mean AP

ImageNet LSVRC Object Detection from video with tracking:CUvideo 55.8% mean AP

COCO 2016 Detection Challenge (bounding boxes):G-RMI (Google) 41.5% AP (4.2% absolute percentage increase from 2015 winner MSRAVC)

圖:ILSVRC 對象檢測結(jié)果(2013-2016)

Source: ImageNet. 2016. [Online] Workshop Presentation, Slide 2. Available:http://image-net.org/challenges/talks/2016/ECCV2016_ilsvrc_coco_detection_segmentation.pdf

對象跟蹤

對象跟蹤(Object Tracking)是指在給定場景中跟蹤特定對象或多個對象的過程。傳統(tǒng)上,它在視頻和現(xiàn)實世界的交互中都有應(yīng)用,例如,對象跟蹤對自動駕駛系統(tǒng)至關(guān)重要。

用于對象跟蹤的全卷積的Siamese網(wǎng)絡(luò)(Fully-Convolutional Siamese Networks for Object Tracking)結(jié)合了一個基本的跟蹤算法和一個Siamese網(wǎng)絡(luò),經(jīng)過端到端的訓(xùn)練,它實現(xiàn)了SOTA,并且可以在幀速率超過實時的情況下進行操作。

利用深度回歸網(wǎng)絡(luò)學(xué)習(xí)以100 FPS跟蹤(Learning to Track at 100 FPS with Deep Regression Networks)是另一篇試圖通過在線訓(xùn)練方法改善現(xiàn)有問題的論文。作者提出了一種利用前饋網(wǎng)絡(luò)的跟蹤器來學(xué)習(xí)對象運動、外觀和定位的一般關(guān)系,從而有效地跟蹤沒有在線訓(xùn)練的新對象。它提供了SOTA標(biāo)準跟蹤基準,同時實現(xiàn)了“以100 fps跟蹤通用對象”(Held et al., 2016)。

Deep Motion Features for Visual Tracking綜合了人工特征,deep RGB/外觀特征(來自CNN),以及深度運動特性(在光流圖像上訓(xùn)練)來實現(xiàn)SOTA。雖然Deep Motion Feature在動作識別和視頻分類中很常見,但作者稱這是第一次使用視覺追蹤技術(shù)。這篇論文獲得了2016年ICPR的最佳論文,用于“計算機視覺和機器人視覺”跟蹤。

Virtual Worlds as Proxy for Multi-Object Tracking Analysis,這篇文章在現(xiàn)有的視頻跟蹤基準和數(shù)據(jù)集中,提出了一種新的現(xiàn)實世界克隆方法,該方法可以從零開始生成豐富的、虛擬的、合成的、逼真的環(huán)境,并使用全標(biāo)簽來克服現(xiàn)有數(shù)據(jù)集的不足。這些生成的圖像被自動地標(biāo)記為準確的ground truth,允許包括對象檢測/跟蹤等一系列應(yīng)用。

全卷積網(wǎng)絡(luò)的全局最優(yōu)對象跟蹤(Globally Optimal Object Tracking with Fully Convolutional Networks),這篇文章解決了對象的變化和遮擋問題,并將它們作為對象跟蹤中的兩個根限制。作者稱,“我們提出的方法利用一個全卷積的網(wǎng)絡(luò)解決了對象的外形變化問題,并處理了動態(tài)規(guī)劃的遮擋問題”(Lee et al., 2016)。

第二部分:分割、 超分辨率/色彩化/風(fēng)格遷移、 行為識別

計算機視覺的中心就是分割的過程,它將整個圖像分成像素組,然后可以對這些組進行標(biāo)記和分類。此外,語義分割通過試圖在語義上理解圖像中每個像素的角色是貓,汽車還是其他類型的,又在這一方向上前進了一步。實例分割通過分割不同類的實例來進一步實現(xiàn)這一點,比如,用三種不同顏色標(biāo)記三只不同的狗。這是目前在自動駕駛技術(shù)套件中使用的計算機視覺應(yīng)用的一大集中點。

也許今年分割領(lǐng)域的一些最好的提升來自FAIR,他們從2015年開始繼續(xù)深入研究DeepMask。DeepMask生成粗糙的“mask”作為分割的初始形式。 2016年,F(xiàn)air推出了SharpMask ,它改進了DeepMask提供的“mask”,糾正了細節(jié)的缺失,改善了語義分割。除此之外,MultiPathNet 標(biāo)識了每個mask描繪的對象。

“為了捕捉一般的物體形狀,你必須對你正在看的東西有一個高水平的理解(DeepMask),但是要準確地描述邊界,你需要再回過去看低水平的特征,一直到像素(SharpMask)。“ - Piotr Dollar,2016

圖:Demonstration of FAIR techniques in action

視頻傳播網(wǎng)絡(luò)(Vedio Propagation Network)試圖創(chuàng)建一個簡單的模型來傳播準確的對象mask,在第一幀分配整個視頻序列以及一些附加信息。

2016年,研究人員開始尋找替代網(wǎng)絡(luò)配置來解決上述的規(guī)模和本地化問題。 DeepLab 就是這樣一個例子,它為語義圖像分割任務(wù)取得了令人激動的結(jié)果。 Khoreva等人(2016)基于Deeplab早期的工作(大約在2015年),提出了一種弱監(jiān)督訓(xùn)練方法,可以獲得與完全監(jiān)督網(wǎng)絡(luò)相當(dāng)?shù)慕Y(jié)果。

計算機視覺通過使用端到端網(wǎng)絡(luò)進一步完善了有用信息網(wǎng)絡(luò)的共享方式,減少了分類中,多個全向子任務(wù)的計算需求。兩個關(guān)鍵的論文使用這種方法是:

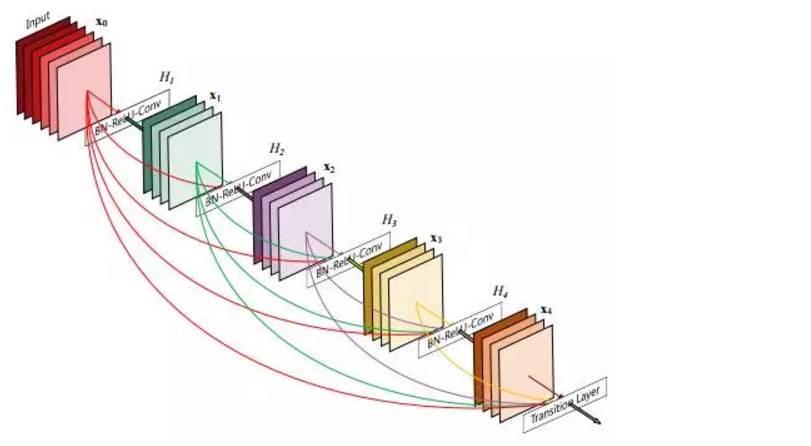

100 Layers Tiramisu是一個完全卷積的DenseNet,它以前饋的方式將每一層連接到每一層。它還通過較少的參數(shù)和訓(xùn)練/處理在多個基準數(shù)據(jù)集上實現(xiàn)SOTA。

Fully Convolutional Instance-aware Semantic Segmentation共同執(zhí)行實例掩碼預(yù)測和分類(兩個子任務(wù))。COCO分割挑戰(zhàn)冠軍MSRA。 37.3%AP。比起2015 COCO挑戰(zhàn)賽中的MSRAVC,絕對躍升了9.1%。

雖然ENet是一種用于實時語義分割的DNN體系結(jié)構(gòu),但它并不屬于這一類別,它證明了降低計算成本和提供更多移動設(shè)備訪問的商業(yè)價值。

我們的工作希望將盡可能多的這些進步回溯到有形的公開應(yīng)用。考慮到這一點,以下內(nèi)容包含2016年一些最有意義的醫(yī)療保健應(yīng)用細分市場:

A Benchmark for Endoluminal Scene Segmentation of Colonoscopy Images

3D fully convolutional networks for subcortical segmentation in MRI: A large-scale study

Semi-supervised Learning using Denoising Autoencoders for Brain Lesion Detection and Segmentation

3D Ultrasound image segmentation: A Survey

A Fully Convolutional Neural Network based Structured Prediction Approach Towards the Retinal Vessel Segmentation

3-D Convolutional Neural Networks for Glioblastoma Segmentation

我們最喜歡的準醫(yī)學(xué)分割應(yīng)用之一是FusionNet——一個深度全卷積神經(jīng)網(wǎng)絡(luò),用于連接組學(xué)的圖像分割,基于SOTA電子顯微鏡(EM)分割方法。

超分辨率、風(fēng)格遷移和著色

并非計算機視覺領(lǐng)域的所有研究都是為了擴展機器的偽認知能力,而且神經(jīng)網(wǎng)絡(luò)的神話般的可塑性以及其他ML技術(shù)常常適用于各種其他新穎的應(yīng)用,這些應(yīng)用可以滲透到公共空間中。超分辨率方案,風(fēng)格轉(zhuǎn)移和著色去年的進步占據(jù)了整個領(lǐng)域。

超分辨率指的是從低分辨率對應(yīng)物估計高分辨率圖像的過程,以及不同放大倍數(shù)下圖像特征的預(yù)測,這是人腦幾乎毫不費力地完成的。最初的超分辨率是通過簡單的技術(shù),如bicubic-interpolation和最近鄰。在商業(yè)應(yīng)用方面,克服低分辨率限制和實現(xiàn)“CSI Miami”風(fēng)格圖像增強的愿望推動了該領(lǐng)域的研究。以下是今年的一些進展及其潛在的影響:

Neural Enhance是Alex J. Champandard的創(chuàng)意,結(jié)合四篇不同研究論文的方法來實現(xiàn)超分辨率方法。

實時視頻超分辨率解決方案也在2016年進行了兩次著名的嘗試。

RAISR:來自Google的快速而準確的圖像超分辨率方法。通過使用低分辨率和高分辨率圖像對訓(xùn)練濾波器,避免了神經(jīng)網(wǎng)絡(luò)方法的昂貴內(nèi)存和速度要求。作為基于學(xué)習(xí)的框架,RAISR比同類算法快兩個數(shù)量級,并且與基于神經(jīng)網(wǎng)絡(luò)的方法相比,具有最小的存儲器需求。因此超分辨率可以擴展到個人設(shè)備。

生成對抗網(wǎng)絡(luò)(GAN)的使用代表了當(dāng)前用于超分辨率的SOTA:

SRGAN通過訓(xùn)練區(qū)分超分辨率和原始照片真實圖像的辨別器網(wǎng)絡(luò),在公共基準測試中提供多采樣圖像的逼真紋理。

盡管SRResNet在峰值信噪比(PSNR)方面的表現(xiàn)最佳,但SRGAN獲得更精細的紋理細節(jié)并達到最佳的平均評分(MOS),SRGAN表現(xiàn)最佳。

“據(jù)我們所知,這是第一個能夠推出4倍放大因子的照片般真實的自然圖像的框架。”以前所有的方法都無法在較大的放大因子下恢復(fù)更精細的紋理細節(jié)。

Amortised MAP Inference for Image Super-resolution提出了一種使用卷積神經(jīng)網(wǎng)絡(luò)計算最大后驗(MAP)推斷的方法。但是,他們的研究提出了三種優(yōu)化方法,GAN在其中實時圖像數(shù)據(jù)上表現(xiàn)明顯更好。

毫無疑問,Style Transfer集中體現(xiàn)了神經(jīng)網(wǎng)絡(luò)在公共領(lǐng)域的新用途,特別是去年的Facebook集成以及像Prisma 和Artomatix 這樣的公司。風(fēng)格轉(zhuǎn)換是一種較舊的技術(shù),但在2015年出版了一個神經(jīng)算法的藝術(shù)風(fēng)格轉(zhuǎn)換為神經(jīng)網(wǎng)絡(luò)。從那時起,風(fēng)格轉(zhuǎn)移的概念被Nikulin和Novak擴展,并且也被用于視頻,就像計算機視覺中其他的共同進步一樣。

圖:風(fēng)格遷移的例子

風(fēng)格轉(zhuǎn)換作為一個主題,一旦可視化是相當(dāng)直觀的,比如,拍攝一幅圖像,并用不同的圖像的風(fēng)格特征呈現(xiàn)。例如,以著名的繪畫或藝術(shù)家的風(fēng)格。今年Facebook發(fā)布了Caffe2Go,將其深度學(xué)習(xí)系統(tǒng)整合到移動設(shè)備中。谷歌也發(fā)布了一些有趣的作品,試圖融合多種風(fēng)格,生成完全獨特的圖像風(fēng)格。

除了移動端集成之外,風(fēng)格轉(zhuǎn)換還可以用于創(chuàng)建游戲資產(chǎn)。我們團隊的成員最近看到了Artomatix的創(chuàng)始人兼首席技術(shù)官Eric Risser的演講,他討論了該技術(shù)在游戲內(nèi)容生成方面的新穎應(yīng)用(紋理突變等),因此大大減少了傳統(tǒng)紋理藝術(shù)家的工作。

著色

著色是將單色圖像更改為新的全色版本的過程。最初,這是由那些精心挑選的顏色由負責(zé)每個圖像中的特定像素的人手動完成的。2016年,這一過程自動化成為可能,同時保持了以人類為中心的色彩過程的現(xiàn)實主義的外觀。雖然人類可能無法準確地表現(xiàn)給定場景的真實色彩,但是他們的真實世界知識允許以與圖像一致的方式和觀看所述圖像的另一個人一致的方式應(yīng)用顏色。

著色的過程是有趣的,因為網(wǎng)絡(luò)基于對物體位置,紋理和環(huán)境的理解(例如,圖像)為圖像分配最可能的著色。它知道皮膚是粉紅色,天空是藍色的。

“而且,我們的架構(gòu)可以處理任何分辨率的圖像,而不像現(xiàn)在大多數(shù)基于CNN的方法。”

在一個測試中,他們的色彩是多么的自然,用戶從他們的模型中得到一個隨機的圖像,并被問到,“這個圖像看起來是自然的嗎?

他們的方法達到了92.6%,基線達到了大約70%,而實際情況(實際彩色照片)被認為是自然的97.7%。

行為識別

行為識別的任務(wù)是指在給定的視頻幀內(nèi)動作的分類,以及最近才出現(xiàn)的,用算法預(yù)測在動作發(fā)生之前幾幀的可能的相互作用的結(jié)果。在這方面,我們看到最近的研究嘗試將上下文語境嵌入到算法決策中,類似于計算機視覺的其他領(lǐng)域。這個領(lǐng)域的一些關(guān)鍵論文是:

Long-term Temporal Convolutions for Action Recognition利用人類行為的時空結(jié)構(gòu),即特定的移動和持續(xù)時間,以使用CNN變體正確識別動作。為了克服CNN在長期行為的次優(yōu)建模,作者提出了一種具有長時間卷積(LTC-CNN)的神經(jīng)網(wǎng)絡(luò)來提高動作識別的準確性。簡而言之,LTC可以查看視頻的較大部分來識別操作。他們的方法使用和擴展了3D CNN,以便在更充分的時間尺度上進行行動表示。

“我們報告了人類行為識別UCF101(92.7%)和HMDB51(67.2%)兩個具有挑戰(zhàn)性的基準的最新成果。

用于視頻動作識別的時空殘差網(wǎng)絡(luò)將兩個流CNN的變體應(yīng)用于動作識別的任務(wù),該任務(wù)結(jié)合了來自傳統(tǒng)CNN方法和最近普及的殘留網(wǎng)絡(luò)(ResNet)的技術(shù)。這兩種方法從視覺皮層功能的神經(jīng)科學(xué)假設(shè)中獲得靈感,即分開的路徑識別物體的形狀/顏色和運動。作者通過注入兩個CNN流之間的剩余連接來結(jié)合ResNets的分類優(yōu)勢。

Anticipating Visual Representations from Unlabeled Video[89]是一個有趣的論文,盡管不是嚴格的行為分類。該程序預(yù)測了在一個動作之前一個視頻幀序列可能發(fā)生的動作。該方法使用視覺表示而不是逐像素分類,這意味著程序可以在沒有標(biāo)記數(shù)據(jù)的情況下運行,利用深度神經(jīng)網(wǎng)絡(luò)的特征學(xué)習(xí)特性。

Thumos Action Recognition Challenge 的組織者發(fā)表了一篇論文,描述了最近幾年來Action Action Recognition的一般方法。本文還提供了2013-2015年挑戰(zhàn)的概要,以及如何通過行動識別讓計算機更全面地了解視頻的挑戰(zhàn)和想法的未來方向。

第三部分 走向理解3D世界

在計算機視覺中,正如我們所看到的,場景,對象和活動的分類以及邊界框和圖像分割的輸出是許多新研究的重點。實質(zhì)上,這些方法應(yīng)用計算來獲得圖像的二維空間的“理解”。然而,批評者指出,3D理解對于解釋系統(tǒng)成功和現(xiàn)實世界導(dǎo)航是必不可少的。

例如,一個網(wǎng)絡(luò)可能會在圖像中找到一只貓,為它的所有像素著色,并將其歸類為一只貓。但是,在貓所處的環(huán)境中,網(wǎng)絡(luò)是否完全理解圖像中貓的位置?

有人認為,從上述任務(wù)中,計算機對于3D世界的了解很少。與此相反,即使在看2D圖片(即,透視圖,遮擋,深度,場景中的對象如何相關(guān))等情況下,人們也能夠以3D來理解世界。將這些3D表示及其相關(guān)知識傳遞給人造系統(tǒng)代表了下一個偉大計算機視覺的前沿。一般認為這樣做的一個主要原因是:

“場景的2D投影是構(gòu)成場景的相機,燈光和物體的屬性和位置的復(fù)雜功能的組合。如果賦予3D理解,智能體可以從這種復(fù)雜性中抽象出來,形成穩(wěn)定的,不受限制的表示,例如,認識到在不同的光照條件下,或者在部分遮擋下,是從上面或從側(cè)面看的椅子。“

但是,3D理解傳統(tǒng)上面臨著幾個障礙。首先關(guān)注“自我和正常遮擋”問題以及適合給定2D表示的眾多3D形狀。由于無法將相同結(jié)構(gòu)的不同圖像映射到相同的3D空間以及處理這些表示的多模態(tài),所以理解問題變得更加復(fù)雜。最后,實況3D數(shù)據(jù)集傳統(tǒng)上相當(dāng)昂貴且難以獲得,當(dāng)與表示3D結(jié)構(gòu)的不同方法結(jié)合時,可能導(dǎo)致訓(xùn)練限制。

我們認為,在這個領(lǐng)域進行的工作很重要,需要注意。從早期的AGI系統(tǒng)和機器人技術(shù)的早期理論應(yīng)用,到在不久的將來會影響我們社會,盡管還在萌芽期,由于利潤豐厚的商業(yè)應(yīng)用,我們謹慎地預(yù)測這一計算機視覺領(lǐng)域的指數(shù)級增長,這意味著計算機很快就可以開始推理世界,而不僅僅是像素。

OctNet: Learning Deep 3D Representations at High Resolutions

ObjectNet3D: A Large Scale Database for 3D Object Recognition

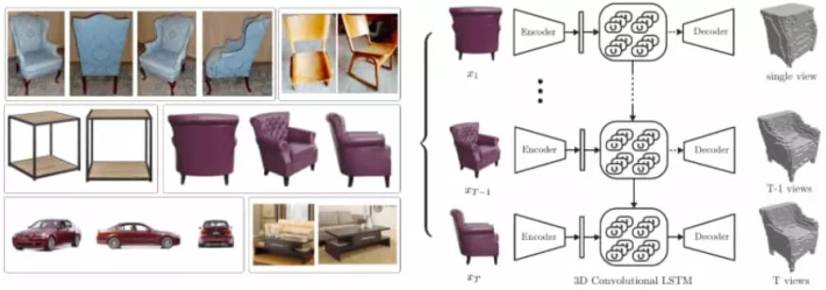

3D-R2N2: A Unified Approach for Single and Multi-view 3D Object Reconstruction

3D Shape Induction from 2D Views of Multiple Objects

Unsupervised Learning of 3D Structure from Images

人類姿勢預(yù)估和關(guān)鍵點監(jiān)測

人體姿勢估計試圖找出人體部位的方向和構(gòu)型。 2D人體姿勢估計或關(guān)鍵點檢測一般是指定人體的身體部位,例如尋找膝蓋,眼睛,腳等的二維位置。

然而,三維姿態(tài)估計通過在三維空間中找到身體部位的方向來進一步進行,然后可以執(zhí)行形狀估計/建模的可選步驟。這些分支已經(jīng)有了很大的改進。

在過去的幾年中,在競爭性評估方面,“COCO2016挑戰(zhàn)包括同時檢測人和本地化關(guān)鍵點”。 ECCV 供了有關(guān)這些主題的更多的文獻,但是我們想強調(diào)以下幾篇論文:

Realtime Multi-Person 2D Pose Estimation using Part Affinity Fields

Keep it SMPL: Automatic Estimation of 3D Human Pose and Shape from a Single Image

重構(gòu)

如前所述,前面的部分介紹了重構(gòu)的一些例子,但總的來說重點是物體,特別是它們的形狀和姿態(tài)。雖然其中一些在技術(shù)上是重構(gòu)的,但是該領(lǐng)域本身包括許多不同類型的重構(gòu),例如,場景重構(gòu),多視點和單視點重建,運動結(jié)構(gòu)(SfM),SLAM等。此外,一些重構(gòu)方法利用附加(和多個)傳感器和設(shè)備,例如事件或RGB-D攝像機,多種技術(shù)來推動進步。

結(jié)果?整個場景可以非剛性地重建并且在時空上改變,例如,對你自己的高保真重構(gòu),以及你的動作進行實時更新。

如前所述,圍繞2D圖像映射到3D空間的問題持續(xù)存在。以下文章介紹了大量創(chuàng)建高保真實時重建的方法:

Fusion4D: Real-time Performance Capture of Challenging Scenes

Real-Time 3D Reconstruction and 6-DoF Tracking with an Event Camera

Unsupervised CNN for Single View Depth Estimation: Geometry to the Rescue

其他未分類3D

IM2CA

Learning Motion Patterns in Videos

Deep Image Homography Estimation

gvnn: Neural Network Library for Geometric Computer Vision

3D summation and SLAM

在整個這一節(jié)中,我們在3D理解領(lǐng)域進行了一個橫切面似的介紹,主要側(cè)重于姿態(tài)估計,重構(gòu),深度估計和同形目錄。但是,還有更多的精彩的工作被我們忽略了,我們在數(shù)量上受到限制。所以,我們希望給讀者提供一個寶貴的出發(fā)點。

大部分突出顯示的作品可能被歸類于幾何視覺,它通常涉及從圖像直接測量真實世界的數(shù)量,如距離,形狀,面積和體積。我們的啟發(fā)是基于識別的任務(wù)比通常涉及幾何視覺中的應(yīng)用程序更關(guān)注更高級別的語義信息。但是,我們經(jīng)常發(fā)現(xiàn),這些3D理解的不同領(lǐng)域大部分是密不可分的。

最大的幾何問題之一是SLAM,研究人員正在考慮SLAM是否會成為深度學(xué)習(xí)所面臨的下一個問題。所謂“深度學(xué)習(xí)的普遍性”的懷疑論者,其中有很多都指出了SLAM作為算法的重要性和功能性:

“視覺SLAM算法能夠同時建立世界三維地圖,同時跟蹤攝像機的位置和方向。” SLAM方法的幾何估計部分目前不適合深度學(xué)習(xí)方法,所以端到端學(xué)習(xí)不太可能。 SLAM代表了機器人中最重要的算法之一,并且是從計算機視覺領(lǐng)域的大量輸入設(shè)計的。該技術(shù)已經(jīng)在Google Maps,自動駕駛汽車,Google Tango 等AR設(shè)備,甚至Mars Luver等應(yīng)用。

第四部分:卷積架構(gòu)、數(shù)據(jù)集、新興應(yīng)用

ConvNet架構(gòu)最近在計算機視覺之外發(fā)現(xiàn)了許多新穎的應(yīng)用程序,其中一些應(yīng)用程序?qū)⒃谖覀兗磳l(fā)布的論文中出現(xiàn)。然而,他們繼續(xù)在計算機視覺領(lǐng)域占有突出的地位,架構(gòu)上的進步為本文提到的許多應(yīng)用和任務(wù)提供了速度,準確性和訓(xùn)練方面的改進。

圖:DenseNet架構(gòu)

基于這個原因,ConvNet體系結(jié)構(gòu)對整個計算機視覺至關(guān)重要。以下是2016年以來一些值得關(guān)注的ConvNet架構(gòu),其中許多從ResNets最近的成功中獲得靈感。

Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning

Densely Connected Convolutional Networks

FractalNet Ultra-Deep Neural Networks without Residuals

Lets keep it simple: using simple architectures to outperform deeper architectures

Swapout: Learning an ensemble of deep architectures

SqueezeNet

Concatenated Rectified Linear Units (CRelu)

Exponential Linear Units (ELUs)

Parametric Exponential Linear Unit (PELU)

Harmonic CNNs

Exploiting Cyclic Symmetry in Convolutional Neural Networks

Steerable CNNs

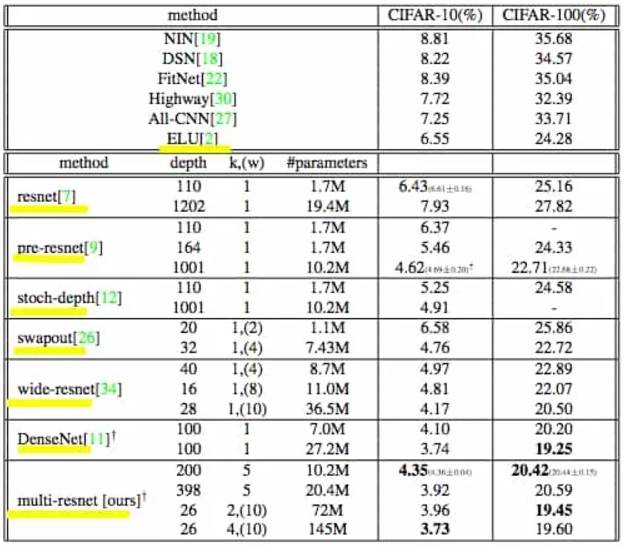

殘差網(wǎng)絡(luò)(Residual Networks)

圖:Test-Error Rates on CIFAR Datasets

隨著微軟ResNet的成功,Residual Networks及其變體在2016年變得非常受歡迎,現(xiàn)在提供了許多開源版本和預(yù)訓(xùn)練模型。在2015年,ResNet在ImageNet的檢測,本地化和分類任務(wù)以及COCO的檢測和分段挑戰(zhàn)中獲得了第一名。雖然深度問題仍然存在,但ResNet處理梯度消失的問題為“深度增加產(chǎn)生超級抽象”提供了更多的動力,這是目前深度學(xué)習(xí)的基礎(chǔ)。

ResNet通常被概念化為一個較淺的網(wǎng)絡(luò)集合,它通過運行平行于其卷積層的快捷連接來抵消深度神經(jīng)網(wǎng)絡(luò)(DNN)的層次性。這些快捷方式或跳過連接可減輕與DNN相關(guān)的消失/爆炸梯度問題,從而允許在網(wǎng)絡(luò)層中更容易地反向傳播梯度。

殘差學(xué)習(xí)、理論與進展

Wide Residual Networks

Deep Networks with Stochastic Depth

Learning Identity Mappings with Residual Gates

Residual Networks Behave Like Ensembles of Relatively Shallow Networks

Identity Mappings in Deep Residual Networks

Multi-Residual Networks: Improving the Speed and Accuracy of Residual Networks

Highway and Residual Networks learn Unrolled Iterative Estimation

Residual Networks of Residual Networks: Multilevel Residual Networks

Resnet in Resnet: Generalizing Residual Architectures

Wider or Deeper: Revisiting the ResNet Model for Visual Recognition

Bridging the Gaps Between Residual Learning, Recurrent Neural Networks and Visual Cortex

Convolutional Residual Memory Networks

Identity Matters in Deep Learning

Deep Residual Networks with Exponential Linear Unit

Weighted Residuals for Very Deep Networks

數(shù)據(jù)集

Places2

SceneNet RGB-D

CMPlaces

MS-Celeb-1M

Open Images

YouTube-8M

一些用例和趨勢

來自Facebook的盲人應(yīng)用程序和百度的硬件

情感檢測結(jié)合了面部檢測和語義分析,并且正在迅速增長。目前有20多個API可用。

從航空影像中提取道路,從航空地圖和人口密度地圖中分類土地。

盡管目前還存在一些功能性問題,但Amazon Go進一步提高了計算機視覺的形象,證明了無排隊的購物體驗。

對于我們基本上沒有提到無人駕駛,我們做了大量的工作。然而,對于那些希望深入研究一般市場趨勢的人來說,莫里茨·穆勒 - 弗雷塔格(Moritz Mueller-Freitag)就德國汽車工業(yè)和自動駕駛汽車的影響作了精彩的介紹。

其他有趣的領(lǐng)域:圖像檢索/搜索,手勢識別,修復(fù)和面部重建。

數(shù)字成像與醫(yī)學(xué)通訊(DICOM)和其他醫(yī)學(xué)應(yīng)用(特別是與成像相關(guān)的)。例如,有許多Kaggle檢測競賽(肺癌,宮頸癌),其中一些有較大的金錢誘因,其中的算法試圖在分類/檢測任務(wù)中勝過專家。

硬件和市場

機器人視覺/機器視覺(獨立領(lǐng)域)和物聯(lián)網(wǎng)的潛在目標(biāo)市場不斷壯大。我們個人最喜歡的是一個日本的農(nóng)民的孩子使用深度學(xué)習(xí),樹莓派和TensorFlow對黃瓜形狀,大小和顏色進行分類。這使他的母親分揀黃瓜所花的人力時間大大減少。

計算需求的縮減和移動到移動的趨勢是顯而易見的,但是它也是通過硬件加速來實現(xiàn)的。很快我們會看到口袋大小的CNN和視覺處理單元(VPUs)到處都是。例如,Movidius Myriad2被谷歌的Project Tango和無人機所使用。

Movidius Fathom 也使用了Myriad2的技術(shù),允許用戶將SOTA計算機視覺性能添加到消費類設(shè)備中。具有USB棒的物理特性的Fathom棒將神經(jīng)網(wǎng)絡(luò)的能力帶到幾乎任何設(shè)備:一根棒上的大腦。

傳感器和系統(tǒng)使用可見光以外的東西。例子包括雷達,熱像儀,高光譜成像,聲納,磁共振成像等。

LIDAR的成本降低,它使用光線和雷達來測量距離,與普通的RGB相機相比具有許多優(yōu)點。目前有不少于500美元的LIDAR設(shè)備。

Hololens和近乎無數(shù)的其他增強現(xiàn)實頭盔進入市場。

Google的Project Tango 代表了SLAM的下一個大型商業(yè)化領(lǐng)域。 Tango是一個增強現(xiàn)實計算平臺,包含新穎的軟件和硬件。 Tango允許在不使用GPS或其他外部信息的情況下檢測移動設(shè)備相對于世界的位置,同時以3D形式繪制設(shè)備周圍的區(qū)域。

Google合作伙伴聯(lián)想于2016年推出了價格適中的Tango手機,允許數(shù)百名開發(fā)人員開始為該平臺創(chuàng)建應(yīng)用程序。 Tango采用以下軟件技術(shù):運動跟蹤,區(qū)域?qū)W習(xí)和深度感知。

與其他領(lǐng)域結(jié)合的前沿研究:

唇語

生成模型

結(jié)論

總之,我們想突出一些在我們的研究回顧過程中反復(fù)出現(xiàn)的趨勢和反復(fù)出現(xiàn)的主題。首先,我們希望引起人們對機器學(xué)習(xí)研究社區(qū)極度追求優(yōu)化的關(guān)注。這是最值得注意的,體現(xiàn)在這一年里精確率的不斷提升。

錯誤率不是唯一的狂熱優(yōu)化參數(shù),研究人員致力于提高速度、效率,甚至算法能夠以全新的方式推廣到其他任務(wù)和問題。我們意識到這是研究的前沿,包括one-shot learning、生成模型、遷移學(xué)習(xí),以及最近的evolutionary learning,我們認為這些研究原則正逐漸產(chǎn)生更大的影響。

雖然這最后一點毫無疑問是值得稱贊的,而不是對這一趨勢的貶低,但人們還是禁不住要把他們的注意力放在(非常)的通用人工智能。我們只是希望向?qū)<液头菍I(yè)人士強調(diào),這一擔(dān)憂源自于此,來自計算機視覺和其他人工智能領(lǐng)域的驚人進展。通過對這些進步及其總體影響的教育,可以減少公眾不必要的擔(dān)憂。這可能會反過來冷卻媒體的情緒和減少有關(guān)AI的錯誤信息。

出于兩個原因,我們選擇專注于一年的時間里的進展。第一個原因與這一領(lǐng)域的新工作數(shù)量之大有關(guān)。即使對那些密切關(guān)注這一領(lǐng)域的人來說,隨著出版物數(shù)量呈指數(shù)級的增長,跟上研究的步伐也變得越來越困難。第二個原因,讓我們回頭看看這一年內(nèi)的變化。

在了解這一年的進展的同時,讀者可以了解目前的研究進展。在這么短的時間跨度里,我們看到了這么多的進步,這是如何得到的?研究人員形成了以以前的方法(架構(gòu)、元架構(gòu)、技術(shù)、想法、技巧、結(jié)果等)和基礎(chǔ)設(shè)施(Keras、TensorFlow、PyTorch、TPU等)的全球社區(qū),這不禁值得鼓勵,也值得慶祝。很少有開源社區(qū)像這樣不斷吸引新的研究人員,并將它的技術(shù)應(yīng)用于經(jīng)濟學(xué)、物理學(xué)和其他無數(shù)領(lǐng)域。

對于那些尚未注意到的人來說,理解這一點非常重要,即在許多不同聲音中,宣稱對這種技術(shù)的本質(zhì)有理解,至少有共識,認同這項技術(shù)將以新的令人興奮的方式改變世界。然而,在這些改變實現(xiàn)之前,仍存在許多分歧。

我們將繼續(xù)盡最大的努力提供信息。有了這樣的資源,我們希望滿足那些希望跟蹤計算機視覺和人工智能的進展的人的需求,我們的項目希望為開源革命增添一些價值,而這個革命正在技術(shù)領(lǐng)域悄然發(fā)生。

*推薦文章*

【ICCV2017論文技術(shù)解讀】阿里-基于層次化多模態(tài)LSTM的視覺語義聯(lián)合嵌入

NIPS 2017論文深度離散哈希算法,可用于圖像檢索

原文標(biāo)題:計算機視覺這一年:這是最全的一份CV技術(shù)報告

文章出處:【微信公眾號:ADAS】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

3D

+關(guān)注

關(guān)注

9文章

2950瀏覽量

109412 -

人工智能

+關(guān)注

關(guān)注

1804文章

48677瀏覽量

246242 -

計算機視覺

+關(guān)注

關(guān)注

9文章

1706瀏覽量

46556

發(fā)布評論請先 登錄

什么是計算機視覺?計算機視覺的三種方法

計算機最重要的特點是什么

基于OpenCV的計算機視覺技術(shù)實現(xiàn)

計算機視覺與機器視覺區(qū)別

基于計算機視覺的多維圖像智能

計算機視覺中的重要研究方向

計算機視覺入門指南

計算機視覺的重要性及如何幫助解決問題

計算機視覺為何重要?

計算機視覺的基礎(chǔ)概念和現(xiàn)實應(yīng)用

機器視覺和計算機視覺的區(qū)別

計算機視覺的十大算法

詳解計算機視覺最重要的進展

詳解計算機視覺最重要的進展

評論