語言,之所以重要,在于人類的思維能力是伴隨著它的產生而迅速發展的,這也是人類在智能上區別于其他物種的原因。語音識別,作為人工智能應用的一個場景,也是研究者們一直試圖解決的問題。

2016年10月底,微軟宣布語音識別實現了歷史性突破,詞錯率僅5.9%,英語的語音轉錄達到專業速錄員水平,微軟的此次突破是機器的識別能力在英語水平上第一次超越人類。微軟的這條消息發布之后在業內引起了極大的關注。語音識別一直是國內外許多科技公司重點發展的技術之一,百度首席科學家吳恩達就發推特恭賀微軟在英語語音識別上的突破,同時也回憶起一年前百度在漢語語音識別上的突破,其Deep Speech2的短語識別的詞錯率已經降到了3.7%,Deep Speech2轉錄某些語音的能力基本上是超人級的,能夠比普通話母語者更精確地轉錄較短的查詢。

夢想從貝爾實驗室開始

不久前,麻省理工學院(MIT)主辦的知名科技期刊《麻省理工科技評論》(MITTechnologyReview),評選出了“2016年十大突破技術”。《麻省理工科技評論》稱,在過去的一年里,這十項技術均已到達一個里程碑式的階段或即將到達這一階段。而語音識別的突破就是其中的第三項。

回顧人類發展史,不難看出,隨著人的不斷進化,從最初通過手掌、肢體使用簡單工具、傳遞簡單信息,發展到控制發聲并通過耳朵接收,形成了一個以語音為載體的快速信息傳遞通道和收發閉環,成為人類間最自然、最重要的信息交互手段。聲波作為一種音頻信號,和視頻信號、無線電信號一樣是,非接觸方式的傳播,也是人類唯一可以不借助工具就可自由掌控的一種天然“無線”資源。而且聲波對接收指向性的要求更寬松,這個非常寶貴的特性會在很多場景下帶來極大便利。特別是對于一些在視覺、觸覺等方面存在障礙(如老年人、弱視、殘障人士)或不適合(如兒童需要保護視力)的龐大特定人群,語音更是最佳的交互選擇。

1946年,現代電子計算機出現后,計算機在很多事情上做得比人還好,既然如此,機器能不能懂得自然語言呢?與機器進行語音交流,讓它聽明白你在說什么,語音識別技術是計算機一出現,人類就開始憧憬的一大夢想。

最早提出機器智能概念的是計算機科學之父阿蘭·圖靈,1950年他在《思想》(Mind)雜志上發表了一篇題為“計算的機器和智能”的論文。在論文中,圖靈并沒有提出什么研究方法,而是提出了一種驗證機器是否有智能的方法:讓人和機器進行交流,如果人無法判斷自己交流的對象是人還是機器,就說明這個機器有智能了。這種方法被后人稱作圖靈測試。圖靈其實是留下了一個問題,而非答案,但是一般認為對自然語言的機器處理可以追溯到那個時候。

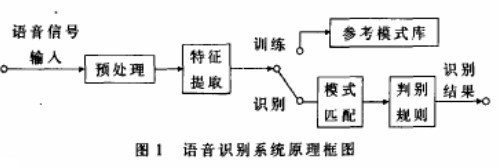

科學家認為語音識別就好比“機器的聽覺系統”,該技術可以讓機器通過識別和理解,把語音信號轉變為相應的文本或命令。1952年,貝爾研究所,Davis 等人研制了世界上第一個能識別10個英文數字發音的實驗系統。1960年,英國的Denes等人研制了第一個計算機語音識別系統。

事實上,語音識別60多年的發展過程可以分成多個階段。早期的20多年,即從20世紀50年代到70年代,是科學家們走彎路的階段,全世界的科學家對計算機完成語音識別這類只有人才能做的事情,認為必須先讓計算機理解自然語言,這就局限在人類學習語言的方式上了,也就是用電腦模擬人腦,這20多年的研究成果近乎為零。

賈里尼克的貢獻

直到1970年后,統計語言學的出現才使語音識別重獲新生,并取得了今天的飛凡成就。推動這個技術路線轉變的關鍵人物是德里克·賈里尼克(FrederickJelinek)和他領導的IBM華生實驗室(T.J.Watson),開始使用統計方法。采用統計的方法,IBM將當時的語音識別率從70%提升到90%,同時語音識別的規模從幾百單詞上升到幾萬單詞,這樣語音識別就有了從實驗室走向實際應用的可能。

《從水門事件到莫妮卡·萊溫斯基》是賈里尼克在1999年ICASSP(國際聲學、語言和信號處理大會)做的報告題目,因為水門事件發生的時間1972年,恰好是統計語音識別開始的時間,而因萊溫斯基事件彈劾克林頓總統正好發生于當時會議的前一年。

賈里尼克在康奈爾十年磨一劍,潛心研究信息論,終于悟出了真諦。1972年,賈里尼克到IBM華生實驗室做學術休假,無意中領導了語音識別實驗室,兩年后他在康奈爾和IBM之間選擇了留在IBM。

20世紀70年代的IBM有點像90年代的微軟和過去十年(施密特時代)的Google,任由杰出科學家做自己感興趣的研究。在那種寬松的環境里,賈里尼克等人提出了統計語音識別的框架結構。

在賈里尼克之前,科學家們把語音識別問題當作人工智能和模式匹配問題,而賈里尼克將它當作通信問題,并用兩個隱含馬爾可夫模型(聲學模型和語言模型)把語音識別概括得清清楚楚。這個框架結構至今仍對語音識別影響深遠,它不僅從根本上使得語音識別有使用的可能,而且奠定了今天自然語言處理的基礎。賈里尼克后來也因此當選美國工程院院士,并被Technology雜志評為20世紀100名發明家之一。

賈里尼克的前輩們在將統計的方法應用于語音識別時,遇到了兩個不可逾越的障礙:缺乏計算能力強大的計算機和大量可以用于統計的機讀文本語料,最后前輩們不得不選擇放棄。20世紀的IBM,雖然計算機的計算能力不能和今天相比,但已可以做不少事了,賈里尼克和他的同事需要解決的問題就是如何找到大量的機讀語料。好在當時有一項全球性的業務是通過電信網連接在一起的,那就是電傳,IBM的科學家最初就是通過電傳業務的文本開始進行研究的。

為什么當初是沒有什么語音識別基礎的IBM,而不是在這個領域里有很長研究時間的貝爾實驗室或者卡內基-梅隆大學提出統計語音識別的處理。很多歷史的偶然性背后都有著它必然的原因,因為IBM有著這樣的計算能力,又有物質條件,同時聚集了一大批世界上最聰明的頭腦。

基于統計的語音識別替代基于規則的前后方法交替經歷了15年時間。之所以歷經許久,是因為新的研究方法成熟需要很多年。

剩下的難題依舊

語音識別的獨特性不僅僅是因為其成就:盡管已有成果斐然,但剩下的難題和目前已克服的一樣令人生畏。

隨著語音識別研究思路的變化,大規模的語音識別研究始于20世紀70年代以后,并在小詞匯量、孤立詞的識別方面取得了實質性的進展。20世紀80年代以后,語音識別研究的重點則逐漸轉向大詞匯量、非特定人連續語音識別。20世紀90年代以后,在語音識別的系統框架方面并沒有什么重大突破。

但在語音識別技術的應用及產品化方面出現了很大的進展。比如,DARPA是在20世紀70年代由美國國防部遠景研究計劃局資助的一項計劃,旨在支持語言理解系統的研究開發工作。進入90年代,DARPA計劃仍在持續進行中,其研究重點已轉向識別裝置中的自然語言處理部分,識別任務設定為“航空旅行信息檢索”。根據DARPA資助的多次語音評測,語音識別詞錯誤率已經是評估進步的主要指標。

我國的語音識別研究起始于1958年,由中國科學院聲學研究所利用電子管電路識別10個元音。由于當時條件的限制,中國的語音識別研究工作一直處于緩慢發展階段。直至1973年,中國科學院聲學研究所開始了計算機語音識別。

進入80年代以來,隨著計算機應用技術在我國逐漸普及和應用以及數字信號技術的進一步發展,國內許多單位具備了研究語音技術的基本條件。與此同時,國際上語音識別技術在經過多年的沉寂之后重又成為研究熱點。在這種形式下,國內許多單位紛紛投入到這項研究工作中去。

1986年,語音識別作為智能計算機系統研究的一個重要組成部分,被專門列為研究課題。在“863”計劃的支持下,中國開始組織語音識別技術的研究,并決定了每隔兩年召開一次語音識別的專題會議。

大數據與深度神經網絡帶來的大爆發

任何技術都有蓄能階段和爆發階段,語音識別技術的爆發是源于大數據,伴隨互聯網出現的漣漪效應和深度神經網絡。漣漪效應,指互聯網思維在提高核心技術表現中的作用。也有人稱之為優化迭代,比如吳恩達將其稱之為把研究層、產品和用戶使用組合在一起,形成一個閉環的迭代優化,這是互聯網思維在核心技術優化和突破所發揮作用的一種表達。通過這種方式不僅可以獲取數據,還能學習經驗、認識以及怎么使用等,比如說調整哪些東西讓用戶體驗得更好。

語音識別是需要經驗、數據和用戶反饋共同作用來提升表現的。需要利用用戶的反饋總結出一些特點。比如說用戶在說話時會截斷,這樣你就可以通過調整一些參數來提升表現。因為語音識別不僅是數據多了,識別率提高了,還有更多的因素,比如說用戶的感覺、一些關鍵的參數點、經驗等,這些都是可以學習到的。互聯網思維所帶來的就像軟件迭代一樣,通過反饋回來的信息進行調整,這是最核心的。

在大數據時代到來后,隱馬爾可夫模型出現了局限,即數據量提升時,它帶來的表現提升沒有深度神經網絡那么大,但其實都屬于統計模式識別。在語音識別發展的過程中,深度學習是同時發生的一件事,如果沒有深度神經網絡,但是有大數據和漣漪效應,隱馬爾可夫模型也可以做到實用。深度神經網絡是讓其做得最好,降低了門檻,讓更多的人可以加入進來。在同樣具有漣漪效應的情況下,深度神經網絡比之前的算法好,數據越多,深度神經網絡的效果更好。還有更加重要的一點,深度神經網絡只是整個統計機器模式識別理論框架中的一個環節而已,真正重要的環節是統計決策系統。

深度神經網絡由Geoffrey Hinton與微軟的鄧力研究員最先開始做,谷歌是最早在全球范圍內大規模使用深度神經網絡的公司,谷歌的VoiceSearch也在最早開創了用互聯網思維做語音識別。在這方面,科大訊飛受到谷歌的啟發,迅速跟進成為國內第一個在商用系統里使用深度神經網絡的公司。

語音識別技術已經發展了幾十年的時間,因為大數據和深度神經網絡的應用,這一領域的傳統強者成了谷歌、亞馬遜、蘋果和微軟這些美國科技巨頭,但據TechCrunch統計,美國至少有26家公司在開發語音識別技術。

不過,盡管谷歌這些巨頭在語音識別技術上的技術積累和先發優勢讓后來者似乎難望其項背,但因為一些政策和市場方面的原因,這些巨頭的語音識別主要偏向于英語,這給科大訊飛、百度、搜狗等在漢語領域實現突出表現提供了機會。在國內,這些本土化產品更為用戶所熟知。

從識別到感知認知

在語音識別中,訓練數據的匹配和豐富性是推動系統性能提升的最重要因素之一,但是語料的標注和分析需要長期的積累和沉淀,隨著大數據時代的來臨,大規模語料資源的積累將提到戰略高度。現如今,語音識別在移動終端上的應用最為火熱,語音對話機器人、語音助手、互動工具等層出不窮,許多互聯網公司紛紛投入人力、物力和財力展開此方面的研究和應用,目的是通過語音交互的新穎和便利模式迅速占領客戶群。

盡管視覺和語音識別在近些年來都取得了巨大的進步,但這些研究者仍然提醒說,還有很多的工作要做。

展望未來,研究者正在努力工作以確保語音識別能在更為真實生活的環境中良好地工作。這些環境包括具有很多背景噪聲的地方,比如聚會場所或在高速路上駕駛的時候。他們也將關注如何更好地在多人交談環境中將不同的說話人區分開,并且確保其能夠在各種各樣的聲音上發揮效用,而不管說話人的年齡、口音或說話能力。

從更長遠來看,研究者將會關注如何教計算機不只是轉錄來自人類嘴巴的聲音信號,而且還要理解他們所說的話。這樣就能讓這項技術可以根據自己被告知的內容回答問題或采取行動。

下一個前沿是從識別走向理解,我們正在從一個人類必須理解計算機的世界邁向一個計算機必須理解我們的世界。

但是,我們也應該清醒的是,真正的人工智能仍然還在遙遠的地平線上。在計算機能理解其所聽到或看到的事物的真正含義之前,還需要很長時間的工作,還有很長的路要走。

電子發燒友App

電子發燒友App

評論