隨著預(yù)訓(xùn)練語(yǔ)言模型(PLMs)的不斷發(fā)展,各種NLP任務(wù)設(shè)置上都取得了不俗的性能。盡管PLMs可以從大量語(yǔ)料庫(kù)中學(xué)習(xí)一定的知識(shí),但仍舊存在很多問(wèn)題,如知識(shí)量有限、受訓(xùn)練數(shù)據(jù)長(zhǎng)尾分布影響魯棒性不好

2022-04-02 17:21:43 8765

8765 大型語(yǔ)言模型在關(guān)鍵任務(wù)和實(shí)際應(yīng)用中的可靠性受到挑戰(zhàn)。 模型產(chǎn)生幻覺(jué)可能是由于模型缺乏或錯(cuò)誤地理解了相關(guān)的知識(shí)。當(dāng)人類思考和記憶事物時(shí),本體知識(shí)在我們的思維過(guò)程中扮演著重要角色。本體知識(shí)涉及類別、屬性以及它們之間的關(guān)系。它幫助

2023-08-15 09:33:45 1090

1090

在大型語(yǔ)言模型(LLMs)的應(yīng)用中,提示工程(Prompt Engineering)是一種關(guān)鍵技術(shù),用于引導(dǎo)模型生成特定輸出或執(zhí)行特定任務(wù)。通過(guò)精心設(shè)計(jì)的提示,可以顯著提高LLMs的性能和適用性。本文將介紹提示工程的主要方法和技巧,包括少樣本提示、提示壓縮和提示生成。

2023-12-13 14:21:47 274

274

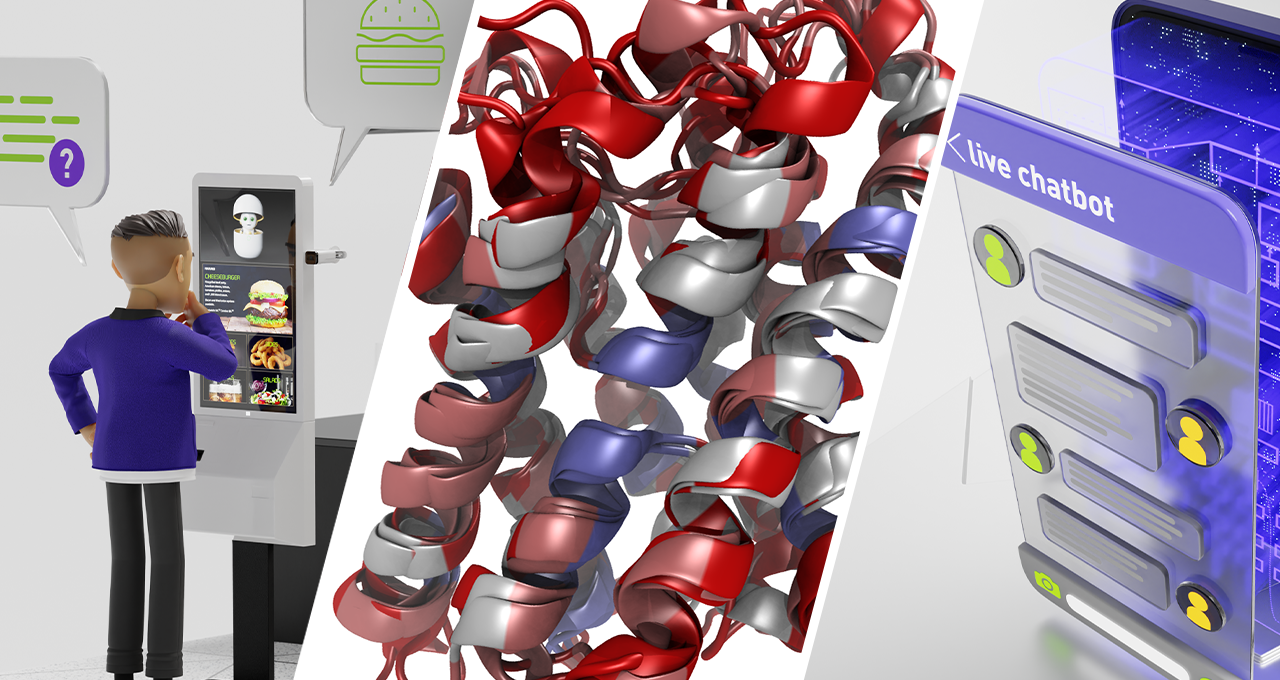

NVIDIA NeMo 大型語(yǔ)言模型(LLM)服務(wù)幫助開(kāi)發(fā)者定制大規(guī)模語(yǔ)言模型;NVIDIA BioNeMo 服務(wù)幫助研究人員生成和預(yù)測(cè)分子、蛋白質(zhì)及 DNA ? 美國(guó)加利福尼亞州圣克拉拉

2022-09-21 15:24:52 434

434

一種新穎的觸摸式開(kāi)關(guān)臺(tái)燈電路本文所應(yīng)用到的相關(guān)器件資料: TT6061A 最近,筆者對(duì)一種新的觸摸式臺(tái)燈按其實(shí)物畫(huà)下

2008-09-22 16:01:24

一種新穎的ZVZCSPWM全橋變換器

2012-04-08 12:46:49

制作12 dBi線極化天線最常采用微帶天線組陣,其尺寸較大為580 mm×260 mm×50 mm。而本文采用了一種新穎的形式即單極天線組陣進(jìn)行設(shè)計(jì)。

2019-07-23 07:51:50

和可用性有很大影響。在對(duì)測(cè)試性建模理論進(jìn)行研究的基礎(chǔ)上,借鑒多信號(hào)流圖模型和eXpress信息模型,提出了一種適合電子系統(tǒng)的測(cè)試性模型——ESTIM(electrotic system

2010-04-22 11:28:58

范式間區(qū)別構(gòu)造數(shù)據(jù)庫(kù)必須遵循一定的規(guī)則。在關(guān)系數(shù)據(jù)庫(kù)中,這種規(guī)則就是范式。范式是符合某一種級(jí)別的關(guān)系模式的集合。關(guān)系數(shù)據(jù)庫(kù)中的關(guān)系必須滿足一定的要求,即滿足不同的范式。目前關(guān)系數(shù)據(jù)庫(kù)有六種范式:第一

2008-10-22 11:40:06

架構(gòu)聲明式UI前端****提供了UI開(kāi)發(fā)范式的基礎(chǔ)語(yǔ)言規(guī)范,并提供內(nèi)置的UI組件、布局和動(dòng)畫(huà),提供了多種狀態(tài)管理機(jī)制,為應(yīng)用開(kāi)發(fā)者提供一系列接口支持。語(yǔ)言運(yùn)行時(shí)選用方舟語(yǔ)言運(yùn)行時(shí),提供了針對(duì)UI范式

2023-01-17 15:09:29

。整體架構(gòu) 聲明式UI前端提供了UI開(kāi)發(fā)范式的基礎(chǔ)語(yǔ)言規(guī)范,并提供內(nèi)置的UI組件、布局和動(dòng)畫(huà),提供了多種狀態(tài)管理機(jī)制,為應(yīng)用開(kāi)發(fā)者提供一系列接口支持。 語(yǔ)言運(yùn)行時(shí)選用方舟語(yǔ)言運(yùn)行時(shí),提供了針對(duì)UI范式

2021-11-30 11:03:36

一種新穎的環(huán)路內(nèi)去塊效應(yīng)濾波器設(shè)計(jì),設(shè)計(jì)中采用5階流水線的去塊效應(yīng)模塊,利用混合濾波順序與打亂的存儲(chǔ)更新機(jī)制的方法提高了流水線暢順性,濾波一個(gè)16×16大小的宏塊僅需要198個(gè)時(shí)鐘周期。

2021-04-12 06:35:37

LabVIEW圖形化語(yǔ)言的事件驅(qū)動(dòng)編程 需要提醒大家的是:本節(jié)所要討論的是圖形化語(yǔ)言事件驅(qū)動(dòng)的編程范式。但我們不得不先介紹一些有關(guān)事件編程的其它知識(shí)。 我們知道:LabVIEW 6.1推出了基于事件驅(qū)動(dòng)

2015-01-19 16:51:09

后端引擎和語(yǔ)言運(yùn)行時(shí)是共用的,但是相比類Web開(kāi)發(fā)范式,聲明式開(kāi)發(fā)范式無(wú)需JS框架進(jìn)行頁(yè)面DOM管理,渲染更新鏈路更為精簡(jiǎn),占用內(nèi)存更少,應(yīng)用性能更佳。

發(fā)展趨勢(shì):聲明式開(kāi)發(fā)范式后續(xù)會(huì)作為主推的開(kāi)發(fā)

2023-04-23 09:35:15

開(kāi)發(fā)范式(簡(jiǎn)稱“類Web開(kāi)發(fā)范式”)和基于TS擴(kuò)展的聲明式開(kāi)發(fā)范式(簡(jiǎn)稱“聲明式開(kāi)發(fā)范式”)。以下是兩種開(kāi)發(fā)范式的簡(jiǎn)單對(duì)比。開(kāi)發(fā)范式名稱語(yǔ)言生態(tài)UI更新方式適用場(chǎng)景適用人群類Web開(kāi)發(fā)范式JS語(yǔ)言數(shù)據(jù)

2022-05-12 14:11:47

STM32有哪些基本知識(shí)?如何去建立一種STM32開(kāi)發(fā)環(huán)境?怎樣去安裝并下載一種keil軟件?

2021-07-05 07:30:13

VerilogHDL是硬件描述語(yǔ)言的一種,用于數(shù)字電子系統(tǒng)設(shè)計(jì)。它允許設(shè)計(jì)者用它來(lái)進(jìn)行各種級(jí)別的邏輯設(shè)計(jì),可以用它進(jìn)行數(shù)字邏輯系統(tǒng)的仿真驗(yàn)證、時(shí)序分析、邏輯綜合。它是目前應(yīng)用最廣泛的一種硬件描述語(yǔ)言之一。

2019-09-29 08:46:06

的獎(jiǎng)勵(lì)模型,對(duì)有監(jiān)督微調(diào)模型對(duì)用戶提示詞補(bǔ)全結(jié)果的質(zhì)量進(jìn)行評(píng)估,與語(yǔ)言模型建模目標(biāo)綜合得到更好的效果。這一階段的難點(diǎn)在于解決強(qiáng)化學(xué)習(xí)方法穩(wěn)定性不高、超參數(shù)眾多及模型收斂困難等問(wèn)題。

除了大語(yǔ)言模型的構(gòu)建

2024-03-11 15:16:39

的視角,以揭示大語(yǔ)言模型的精妙之處。本書(shū)的一大特色體現(xiàn)在其知識(shí)體系的系統(tǒng)性。我們從數(shù)據(jù)處理的基礎(chǔ)工作(如數(shù)據(jù)清洗與去重)講起,逐步深入,探討預(yù)訓(xùn)練、微調(diào)技術(shù)和強(qiáng)化對(duì)齊技術(shù)等核心技術(shù)環(huán)節(jié)。同時(shí),書(shū)中

2024-03-18 15:49:46

的類Web開(kāi)發(fā)范式(簡(jiǎn)稱“類Web開(kāi)發(fā)范式”)。以下是兩種開(kāi)發(fā)范式的簡(jiǎn)單對(duì)比。[td]開(kāi)發(fā)范式名稱語(yǔ)言生態(tài)UI更新方式適用場(chǎng)景適用人群聲明式開(kāi)發(fā)范式ArkTS語(yǔ)言數(shù)據(jù)驅(qū)動(dòng)更新復(fù)雜度較大、團(tuán)隊(duì)合作度較高

2022-11-06 18:51:44

介紹一種多層陶瓷電容器的動(dòng)態(tài)模型

2021-06-08 06:44:41

本文介紹了一種基于FPGA利用VHDL硬件描述語(yǔ)言的數(shù)字秒表設(shè)計(jì)方法,

2021-05-11 06:37:32

介紹了在C語(yǔ)言環(huán)境下,在LCD液晶顯示屏上實(shí)現(xiàn)多級(jí)嵌套菜單的一種簡(jiǎn)便方法,提出了一個(gè)結(jié)構(gòu)緊湊、實(shí)用的程序模型。

2011-03-03 13:10:31

在KEIL下怎樣去創(chuàng)建一種匯編語(yǔ)言STM32工程呢?有哪些操作步驟?

2022-01-19 07:02:16

STM32擴(kuò)展工具怎樣去安裝并使用呢?如何利用simulink去設(shè)計(jì)一種四則運(yùn)算仿真模型?

2021-11-19 06:28:51

Arduino是什么?如何去實(shí)現(xiàn)一種基于C語(yǔ)言與Java的WiFi避障小車的設(shè)計(jì)?

2021-11-10 07:52:41

如何去實(shí)現(xiàn)一種基于磁鏈模型的非線性觀測(cè)器設(shè)計(jì)呢?如何對(duì)其模型進(jìn)行仿真?其波形是怎樣的?

2021-11-19 07:34:36

STM32為什么使用Matlab/Simulink呢?如何去開(kāi)發(fā)一種基于HAL庫(kù)的模型并進(jìn)行仿真呢?

2021-11-18 07:56:40

永磁同步電機(jī)是什么?如何去搭建一種永磁同步電機(jī)的數(shù)學(xué)模型?

2021-08-02 07:42:42

雙向鏈表的結(jié)構(gòu)是由哪些部分組成的?如何在C語(yǔ)言中去創(chuàng)建一種雙向鏈表呢?

2021-12-24 06:22:06

如何在RKNN上開(kāi)發(fā)并運(yùn)行一種yolov3 rknn模型呢?其程序代碼該怎樣去實(shí)現(xiàn)呢?

2022-02-15 07:57:46

怎樣使用C語(yǔ)言去制作一種呼吸燈呢?C語(yǔ)言是如何控制小燈亮度的呢?

2022-01-20 07:18:02

Lua是什么?nodemcu又是什么?怎樣使用lua語(yǔ)言去開(kāi)發(fā)一種esp8266?

2021-06-15 07:28:27

怎樣去搭建一種PMSM滯環(huán)電流控制仿真模型?PMSM滯環(huán)電流控制方法是什么?

2021-10-08 07:03:24

怎樣去搭建一種STM32代碼生成模型?要注意哪些問(wèn)題?

2021-10-11 06:25:26

怎樣去搭建一種SVPWM算法模型?如何對(duì)SVPWM算法模型進(jìn)行仿真?怎樣去搭建一種滯環(huán)電流控制模型?如何對(duì)滯環(huán)電流控制模型進(jìn)行仿真?怎樣去搭建一種基于PI調(diào)節(jié)器的PMSM矢量控制系統(tǒng)模型?如何對(duì)其進(jìn)行仿真?

2021-07-27 07:13:15

雙饋風(fēng)力發(fā)電機(jī)運(yùn)行的原理是什么?怎樣去搭建一種基于Simulink的變速恒頻雙饋風(fēng)力發(fā)電模型呢?

2021-10-22 08:20:31

怎樣去搭建一種永磁同步電動(dòng)機(jī)模型?怎樣去搭建一種PMSM電流閉環(huán)模型?

2021-10-08 08:08:07

怎樣去搭建一種由轉(zhuǎn)矩方程計(jì)算角度速度的矢量控制模型?如何對(duì)速度環(huán)矢量控制模型進(jìn)行仿真?

2021-10-11 07:06:39

Boot模式有哪幾種呢?怎樣去新建一種匯編語(yǔ)言的STM32工程呢?

2021-11-26 06:00:50

怎樣去編寫一種C語(yǔ)言開(kāi)發(fā)之花樣流水燈程序呢?求解

2021-07-15 11:16:58

基于Allwinner A40i工業(yè)級(jí)芯片的大型智能網(wǎng)關(guān)具備哪些功能?怎樣去設(shè)計(jì)一種基于Allwinner A40i工業(yè)級(jí)芯片的大型智能網(wǎng)關(guān)?

2021-09-26 08:35:47

PLC的用途與特點(diǎn)有哪些?怎樣去設(shè)計(jì)一種基于PLC的知識(shí)競(jìng)賽搶答器?

2021-10-11 06:16:27

FIFO隊(duì)列是什么?怎樣去設(shè)計(jì)一種采用覆蓋機(jī)制的FIFO隊(duì)列模型呢?

2021-12-08 06:07:14

你好 !有沒(méi)有一種方法可以在電機(jī)工作臺(tái)中微調(diào)電機(jī)參數(shù)(最終斜坡值、速度斜升...),而無(wú)需從電機(jī)控制工作臺(tái)系統(tǒng)地重新生成代碼然后 Cube-MX 每次我想調(diào)整一個(gè)參數(shù)?更改每個(gè)參數(shù)可能需要 3 分鐘以上,這使得微調(diào)成為一個(gè)障礙。

2023-01-03 09:59:35

MO—OTAS和CCCII士簡(jiǎn)介一種新穎的MO-OTAS和CCCII相結(jié)合的二階多功能電流模式濾波器

2021-04-14 06:12:08

遠(yuǎn)程在線更新FPGA程序系統(tǒng)的硬件結(jié)構(gòu)是怎樣構(gòu)成的?怎樣去設(shè)計(jì)一種遠(yuǎn)程在線更新FPGA程序系統(tǒng)?

2021-06-18 09:16:18

為什么要提出一種改進(jìn)的模型預(yù)測(cè)直接轉(zhuǎn)矩控制算法?改進(jìn)的模型預(yù)測(cè)直接轉(zhuǎn)矩控制算法有哪些功能?

2021-07-06 07:45:56

可以在MATLAB、Mathematica等數(shù)學(xué)軟件上進(jìn)行線性代數(shù)編程所以,從應(yīng)用的角度看,線性代數(shù)是一種人為設(shè)計(jì)的領(lǐng)域特定語(yǔ)言(DSL),它建立了一套模型并通過(guò)符號(hào)系統(tǒng)完成語(yǔ)法和語(yǔ)義的映射。實(shí)際上

2021-04-22 06:30:00

模糊PID控制方式與傳統(tǒng)PID控制相比有何優(yōu)勢(shì)?怎樣去搭建一種模糊控制器系統(tǒng)的數(shù)學(xué)模型?如何對(duì)模糊控制器系統(tǒng)的數(shù)學(xué)模型進(jìn)行仿真?

2021-08-18 07:35:38

一種新穎的中心開(kāi)孔單脈沖毫米波縫隙陣列天線的設(shè)計(jì)

2021-05-14 07:16:41

Matlab PSB是什么?Matlab PSB主要由哪幾個(gè)子模塊庫(kù)組成?怎樣去設(shè)計(jì)一種基于MATLAB的小型電力系統(tǒng)模型?如何對(duì)基于MATLAB的小型電力系統(tǒng)模型進(jìn)行仿真?仿真結(jié)果怎樣?

2021-07-11 07:11:42

什么是測(cè)頻法?怎樣去設(shè)計(jì)一種基于VHDL語(yǔ)言的數(shù)字頻率計(jì)?如何對(duì)基于VHDL語(yǔ)言的數(shù)字頻率計(jì)進(jìn)行仿真?

2021-08-17 06:11:41

一種新穎的ZVZCSPWM全橋變換器

摘要:提出了一種新穎的零電流零電壓開(kāi)關(guān)(ZCZVS)PWM全橋變換器,通過(guò)增加一個(gè)輔助電路的方

2009-07-11 09:37:57 725

725

針對(duì)三維(3D)網(wǎng)格模型的存儲(chǔ)與網(wǎng)絡(luò)傳輸問(wèn)題,提出一種新穎的三維模型壓縮算法。該算法基于對(duì)網(wǎng)格模型的切片處理,主要由以下三個(gè)步驟組成:切片頂點(diǎn)的計(jì)算、切片邊界的均勻采樣以及對(duì)切片所得圖像的編碼。對(duì)于

2017-12-25 16:26:18 3

3 景中落地,難度著實(shí)不小。 現(xiàn)在,針對(duì)這個(gè)問(wèn)題,普林斯頓的陳丹琦、高天宇師徒和MIT博士生Adam Fisch在最新論文中提出,使用較小的語(yǔ)言模型,并用少量樣本來(lái)微調(diào)語(yǔ)言模型的權(quán)重。 并且,實(shí)驗(yàn)證明,這一

2021-01-07 14:27:36 1850

1850 今天給大家介紹EMNLP2020的一篇關(guān)于多語(yǔ)言翻譯新范式的工作multilingual Random Aligned Substitution Pre-training (mRASP)[1],核心

2021-03-31 17:24:04 2598

2598

with Informative Entities。 他們認(rèn)為現(xiàn)存的預(yù)訓(xùn)練語(yǔ)言模型很少會(huì)考慮與知識(shí)圖譜(Knowledge Graph: KG)相結(jié)合,

2021-05-19 15:47:41 3355

3355

本文關(guān)注于向大規(guī)模預(yù)訓(xùn)練語(yǔ)言模型(如RoBERTa、BERT等)中融入知識(shí)。

2021-06-23 15:07:31 3468

3468

我們的工作證明了將大型的、經(jīng)過(guò)訓(xùn)練的模型與外部知識(shí)庫(kù)相結(jié)合的好處以及生成過(guò)程的可控性。我們未來(lái)的工作將是使知識(shí)檢索器可學(xué)習(xí),并為更長(zhǎng)的世代引入結(jié)構(gòu)級(jí)控制。

2022-04-20 14:31:26 1548

1548 由于亂序語(yǔ)言模型不使用[MASK]標(biāo)記,減輕了預(yù)訓(xùn)練任務(wù)與微調(diào)任務(wù)之間的gap,并由于預(yù)測(cè)空間大小為輸入序列長(zhǎng)度,使得計(jì)算效率高于掩碼語(yǔ)言模型。PERT模型結(jié)構(gòu)與BERT模型一致,因此在下游預(yù)訓(xùn)練時(shí),不需要修改原始BERT模型的任何代碼與腳本。

2022-05-10 15:01:27 1173

1173 韓國(guó)先進(jìn)的移動(dòng)運(yùn)營(yíng)商構(gòu)建包含數(shù)百億個(gè)參數(shù)的大型語(yǔ)言模型,并使用 NVIDIA DGX SuperPOD 平臺(tái)和 NeMo Megatron 框架訓(xùn)練該模型。

2022-09-27 09:24:30 915

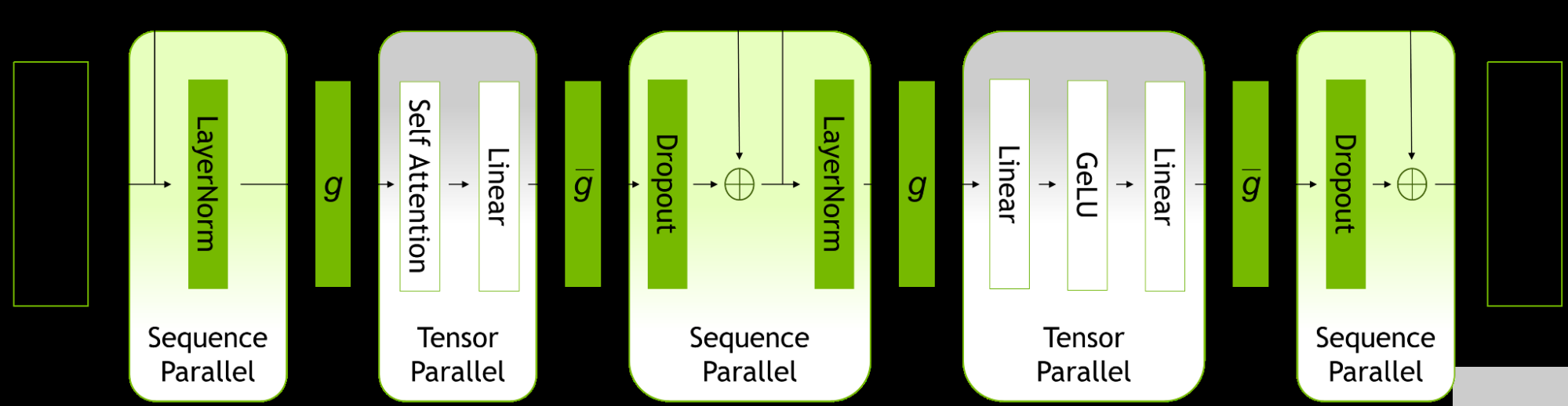

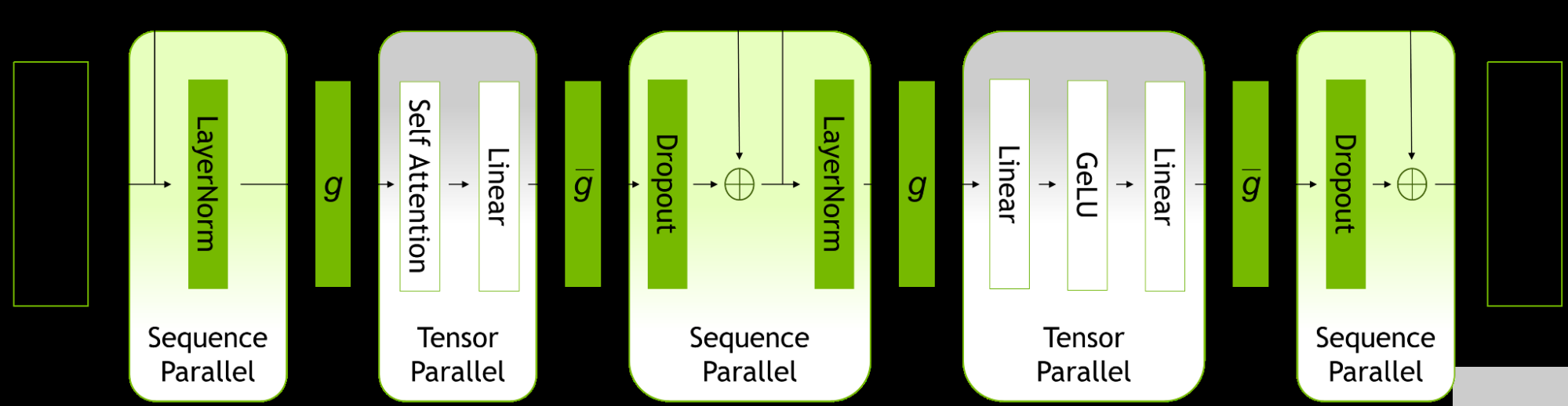

915 隨著大型語(yǔ)言模型( LLM )的規(guī)模和復(fù)雜性不斷增長(zhǎng), NVIDIA 今天宣布更新 NeMo Megatron 框架,提供高達(dá) 30% 的訓(xùn)練速度。

2022-10-10 15:39:42 644

644

另一方面,從語(yǔ)言處理的角度來(lái)看,認(rèn)知神經(jīng)科學(xué)研究人類大腦中語(yǔ)言處理的生物和認(rèn)知過(guò)程。研究人員專門設(shè)計(jì)了預(yù)訓(xùn)練的模型來(lái)捕捉大腦如何表示語(yǔ)言的意義。之前的工作主要是通過(guò)明確微調(diào)預(yù)訓(xùn)練的模型來(lái)預(yù)測(cè)語(yǔ)言誘導(dǎo)的大腦記錄,從而納入認(rèn)知信號(hào)。

2022-11-03 15:07:08 707

707 隨著B(niǎo)ERT、GPT等預(yù)訓(xùn)練模型取得成功,預(yù)訓(xùn)-微調(diào)范式已經(jīng)被運(yùn)用在自然語(yǔ)言處理、計(jì)算機(jī)視覺(jué)、多模態(tài)語(yǔ)言模型等多種場(chǎng)景,越來(lái)越多的預(yù)訓(xùn)練模型取得了優(yōu)異的效果。

2022-11-08 09:57:19 3714

3714 大型語(yǔ)言模型能識(shí)別、總結(jié)、翻譯、預(yù)測(cè)和生成文本及其他內(nèi)容。 AI 應(yīng)用在大型語(yǔ)言模型的幫助下,可用于解決總結(jié)文章、編寫故事和參與長(zhǎng)對(duì)話等多種繁重工作。 大型語(yǔ)言模型(LLM)是一種深度學(xué)習(xí)算法,可以

2023-02-23 19:50:04 3887

3887 大型語(yǔ)言模型能識(shí)別、總結(jié)、翻譯、預(yù)測(cè)和生成文本及其他內(nèi)容。

2023-03-08 13:57:00 6989

6989 NVIDIA NeMo 服務(wù)幫助企業(yè)將大型語(yǔ)言模型與其專有數(shù)據(jù)相結(jié)合,賦能智能聊天機(jī)器人、客戶服務(wù)等更多應(yīng)用。 如今的大型語(yǔ)言模型知識(shí)淵博,但它們的工作方式有點(diǎn)像時(shí)間膠囊——所收集的信息僅限于第一次

2023-03-25 09:10:03 274

274 首先,我們需要了解如何根據(jù)參數(shù)量估計(jì)模型大致所需的 RAM,這在實(shí)踐中有很重要的參考意義。我們需要通過(guò)估算設(shè)置 batch_size,設(shè)置模型精度,選擇微調(diào)方法和參數(shù)分布方法等。

2023-04-10 11:41:46 947

947 在本文中,我們將展示如何使用 大語(yǔ)言模型低秩適配 (Low-Rank Adaptation of Large Language Models,LoRA) 技術(shù)在單 GPU 上微調(diào) 110 億參數(shù)的 FLAN-T5 XXL 模型。

2023-04-14 17:37:40 1503

1503 對(duì)于任何沒(méi)有額外微調(diào)和強(qiáng)化學(xué)習(xí)的預(yù)訓(xùn)練大型語(yǔ)言模型來(lái)說(shuō),用戶得到的回應(yīng)質(zhì)量可能參差不齊,并且可能包括冒犯性的語(yǔ)言和觀點(diǎn)。這有望隨著規(guī)模、更好的數(shù)據(jù)、社區(qū)反饋和優(yōu)化而得到改善。

2023-04-24 10:07:06 2168

2168

大型語(yǔ)言模型LLM(Large Language Model)具有很強(qiáng)的通用知識(shí)理解以及較強(qiáng)的邏輯推理能力,但其只能處理文本數(shù)據(jù)。

2023-05-10 16:53:15 701

701

為了解決大型模型的這個(gè)問(wèn)題,部署者往往采用小一些的特定模型來(lái)替代。這些小一點(diǎn)的模型用常見(jiàn)范式 —— 微調(diào)或是蒸餾來(lái)進(jìn)行訓(xùn)練。微調(diào)使用下游的人類注釋數(shù)據(jù)升級(jí)一個(gè)預(yù)訓(xùn)練過(guò)的小模型。

2023-05-15 09:35:36 389

389

那么,這樣一個(gè)簡(jiǎn)單的機(jī)制能否足以建立一個(gè)通向「解決通用問(wèn)題的語(yǔ)言模型」?如果不是,哪些問(wèn)題會(huì)挑戰(zhàn)當(dāng)前的范式,真正的替代機(jī)制應(yīng)該是什么?

2023-05-24 11:09:05 806

806

確實(shí)能學(xué)習(xí)和表示文本的意義。 雖然大型預(yù)訓(xùn)練語(yǔ)言模型(LLM)在一系列下游任務(wù)中展現(xiàn)出飛速提升的性能,但它們是否真的理解其使用和生成的文本語(yǔ)義? 長(zhǎng)期以來(lái),AI社區(qū)對(duì)這一問(wèn)題存在很大的分歧。有一種猜測(cè)是,純粹基于語(yǔ)言的形式(例

2023-05-25 11:34:11 434

434

:“模型”知識(shí)無(wú)處不在。并預(yù)測(cè)下個(gè)范式會(huì)是“行動(dòng)”無(wú)所不在。 那么到底什么是范式 (Paradigm) ? 我之前在很多場(chǎng)合聽(tīng)到過(guò)所謂的第四范式,第五

2023-05-27 19:15:02 634

634

工智能領(lǐng)域,以高效和有效的方式使用大型語(yǔ)言模型正變得越來(lái)越重要。

LoRA(Low-Rank Adaption,低秩自適應(yīng)) 作為微調(diào) LLMs 一種比較出圈的技術(shù),其額外引入了可訓(xùn)練的低秩分解矩陣,同時(shí)固定住預(yù)訓(xùn)練權(quán)重,從而大大減少了下游任務(wù)的可訓(xùn)練參數(shù)數(shù)量。

2023-05-28 10:58:28 1081

1081

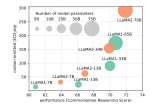

大型語(yǔ)言模型研究的發(fā)展有三條技術(shù)路線:Bert 模式、GPT 模式、混合模式。其中國(guó)內(nèi)大多采用混合模式, 多數(shù)主流大型語(yǔ)言模型走的是 GPT 技術(shù)路線,直到 2022 年底在 GPT-3.5 的基礎(chǔ)上產(chǎn)生了 ChatGPT。

2023-06-09 12:34:53 3162

3162

如何將ChatGPT的能力蒸餾到另一個(gè)大模型,是當(dāng)前許多大模型研發(fā)的研發(fā)范式。當(dāng)前許多模型都是采用chatgpt來(lái)生成微調(diào)數(shù)據(jù),如self instruct,然后加以微調(diào),這其實(shí)也是一種數(shù)據(jù)蒸餾

2023-06-12 15:06:19 526

526

他預(yù)計(jì),深度學(xué)習(xí)和大型語(yǔ)言模型會(huì)繼續(xù)發(fā)展:這個(gè)領(lǐng)域的未來(lái)可能會(huì)有一小部分重大突破,加之許多細(xì)微改進(jìn),所有這些都將融入到一個(gè)龐大而復(fù)雜的工程體系。他還給出了一些有趣、可執(zhí)行的思想實(shí)驗(yàn)。

2023-06-12 16:38:48 262

262 本文旨在更好地理解基于 Transformer 的大型語(yǔ)言模型(LLM)的內(nèi)部機(jī)制,以提高它們的可靠性和可解釋性。 隨著大型語(yǔ)言模型(LLM)在使用和部署方面的不斷增加,打開(kāi)黑箱并了解它們的內(nèi)部

2023-06-25 15:08:49 991

991

?? 大型語(yǔ)言模型(LLM) 是一種深度學(xué)習(xí)算法,可以通過(guò)大規(guī)模數(shù)據(jù)集訓(xùn)練來(lái)學(xué)習(xí)識(shí)別、總結(jié)、翻譯、預(yù)測(cè)和生成文本及其他內(nèi)容。大語(yǔ)言模型(LLM)代表著 AI 領(lǐng)域的重大進(jìn)步,并有望通過(guò)習(xí)得的知識(shí)改變

2023-07-05 10:27:35 1463

1463 LoRA微調(diào)是一種高效的融入學(xué)習(xí)算法。類似人類把新知識(shí)融入現(xiàn)有知識(shí)體系的學(xué)習(xí)過(guò)程。學(xué)習(xí)時(shí)無(wú)需新知識(shí)特別多的樣本,學(xué)習(xí)后原有的龐大知識(shí)和能力可以基本不受影響。

2023-07-18 14:44:39 2543

2543

近日,美智庫(kù)蘭德公司高級(jí)工程師克里斯托弗·莫頓(Christopher Mouton)在C4ISRNET網(wǎng)站撰文,分析ChatGPT等大型語(yǔ)言模型的出現(xiàn)給國(guó)家安全帶來(lái)的新風(fēng)險(xiǎn)。主要觀點(diǎn)如下:

2023-08-04 11:44:53 304

304 今天,Meta發(fā)布了Code Llama,一款可以使用文本提示生成代碼的大型語(yǔ)言模型(LLM)。

2023-08-25 09:06:57 885

885

使用領(lǐng)域適應(yīng)技術(shù)對(duì)預(yù)訓(xùn)練LLM進(jìn)行微調(diào)可以提高在特定領(lǐng)域任務(wù)上的性能。但是,進(jìn)行完全微調(diào)可能會(huì)很昂貴,并且可能會(huì)導(dǎo)致CUDA內(nèi)存不足錯(cuò)誤。當(dāng)進(jìn)行完全微調(diào)時(shí),可能會(huì)發(fā)生災(zāi)難性遺忘,因?yàn)樵S多權(quán)重在"知識(shí)存儲(chǔ)"的地方發(fā)生了變化。

2023-09-19 16:33:19 298

298

大規(guī)模語(yǔ)言模型(Large Language Models,LLM),也稱大規(guī)模語(yǔ)言模型或大型語(yǔ)言模型,是一種由包含數(shù)百億以上參數(shù)的深度神經(jīng)網(wǎng)絡(luò)構(gòu)建的語(yǔ)言模型,使用自監(jiān)督學(xué)習(xí)方法通過(guò)大量無(wú)標(biāo)注

2023-12-07 11:40:43 1141

1141

全微調(diào)(Full Fine-tuning):全微調(diào)是指對(duì)整個(gè)預(yù)訓(xùn)練模型進(jìn)行微調(diào),包括所有的模型參數(shù)。在這種方法中,預(yù)訓(xùn)練模型的所有層和參數(shù)都會(huì)被更新和優(yōu)化,以適應(yīng)目標(biāo)任務(wù)的需求。

2024-01-03 10:57:21 2301

2301

隨著開(kāi)源預(yù)訓(xùn)練大型語(yǔ)言模型(Large Language Model, LLM )變得更加強(qiáng)大和開(kāi)放,越來(lái)越多的開(kāi)發(fā)者將大語(yǔ)言模型納入到他們的項(xiàng)目中。其中一個(gè)關(guān)鍵的適應(yīng)步驟是將領(lǐng)域特定的文檔集成到預(yù)訓(xùn)練模型中,這被稱為微調(diào)。

2024-01-04 12:32:39 228

228

自然語(yǔ)言處理領(lǐng)域存在著一個(gè)非常有趣的現(xiàn)象:在多語(yǔ)言模型中,不同的語(yǔ)言之間似乎存在著一種隱含的對(duì)齊關(guān)系。

2024-02-20 14:53:06 84

84

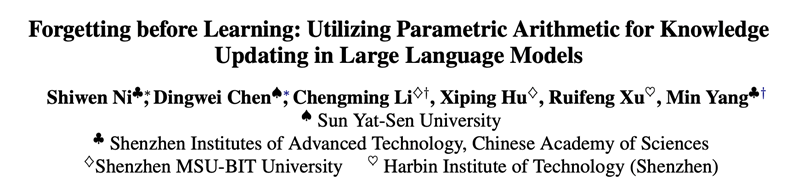

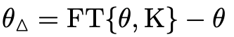

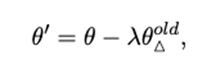

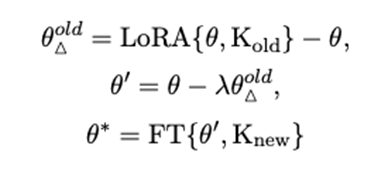

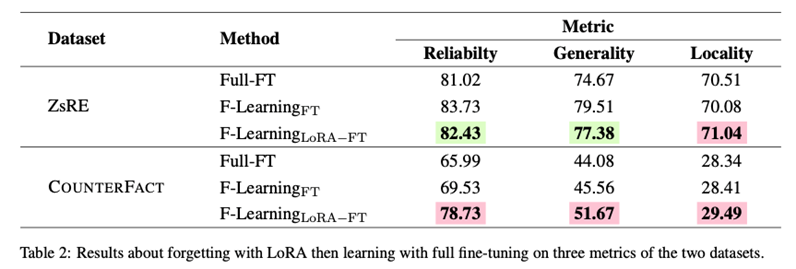

其中FT表示有監(jiān)督微調(diào),和分別表示包含知識(shí)的數(shù)據(jù)集以及原始模型的參數(shù)。類似地,我們首先在一個(gè)包含舊知識(shí)的數(shù)據(jù)集上對(duì)進(jìn)行微調(diào),然后用微調(diào)后的模型參數(shù)減去原始模型的參數(shù)得到表示舊知識(shí)的知識(shí)參數(shù),如下所示:

其中FT表示有監(jiān)督微調(diào),和分別表示包含知識(shí)的數(shù)據(jù)集以及原始模型的參數(shù)。類似地,我們首先在一個(gè)包含舊知識(shí)的數(shù)據(jù)集上對(duì)進(jìn)行微調(diào),然后用微調(diào)后的模型參數(shù)減去原始模型的參數(shù)得到表示舊知識(shí)的知識(shí)參數(shù),如下所示:

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論